Die Geschichte der KI:Von der futuristischen Fiktion zur Zukunft des Unternehmens

Sagen Sie die Worte „künstliche Intelligenz“, und die meisten Leute denken an Alexa und Siri. Andere denken vielleicht an Filme wie „Terminator“ oder „2001:Odyssee im Weltraum“.

Die Wahrheit ist, dass künstliche Intelligenz (KI) kein weit entferntes Science-Fiction-Konzept ist. Tatsächlich ist es überall um uns herum – denken Sie an Netflix, das Ihre nächste TV-Sendung empfiehlt, oder an Uber, das die beste Route nach Hause optimiert.

KI ist ein ausgeklügeltes Ökosystem moderner, miteinander verbundener Technologien, das sich über Jahrzehnte entwickelt hat – und sich bis heute weiterentwickelt. Kein Wunder also, dass auch die Geschichte der KI komplex und vielschichtig ist. Es ist eine Geschichte, die eine Vielzahl von sich ändernden Tools und Fähigkeiten aufweist, die die KI, wie wir sie kennen, bis zu ihrem aktuellen Stand aufgebaut haben.

Um die Bedeutung der KI heute zu verstehen und sich auf morgen vorzubereiten, hilft es zu verstehen, wo die KI begann und wie sie sich zu der bahnbrechenden Technologie entwickelt hat, die sie heute ist.

KI des 20. Jahrhunderts:Ein ehrgeiziger Machbarkeitsnachweis

Die moderne KI wurde in den akademischen Kammern der Elite-Forschungsabteilungen von Universitäten geboren, wo Wissenschaftler intensiv über die Zukunft des Computing nachdachten. Aber seine frühen Jahre ließen es auf diese Kammern beschränkt zurück, gestrandet dank eines Mangels an Daten und Rechenleistung.

1956 veranstaltete das Dartmouth College das Dartmouth Summer Research Project on Artificial Intelligence – einen Workshop, der als entscheidender erster Schritt in die akademische KI-Forschung bekannt wurde. Während des Workshops wollten 20 Forscher die Hypothese beweisen, dass Lernen so genau beschrieben werden kann, „dass eine Maschine dazu gebracht werden kann, es zu simulieren.“

Ein Jahr später, 1957, erweiterte der amerikanische Psychologe Frank Rosenblatt die Dartmouth-Forschung um Perceptron, einen Algorithmus, der erfolgreich eine binäre Klassifizierung durchführen konnte. Hier begannen wir, vielversprechende Beweise dafür zu sehen, wie künstliche Neuronen aus Daten lernen können.

Und ein weiteres Jahr später entwickelten John McCarthy, ein Teilnehmer des Dartmouth Summer Research Project on Artificial Intelligence, und zahlreiche Studenten des MIT Lisp (eine neue Programmiersprache). Jahrzehnte später trug McCarthys Forschung dazu bei, neue und noch aufregendere Projekte zum Leben zu erwecken, darunter das SHRDLU-Programm für natürliche Sprache, das Macsyma-Algebrasystem und das ACL2-Logiksystem.

Quelle

Wenn wir auf diese frühen Experimente zurückblicken, können wir sehen, wie die KI ihre ersten wackeligen Schritte aus der Welt der hochgesinnten Forschung in die praktische Welt der Computer unternimmt.

Das Jahr 1960 sah das Debüt von Simulmatics, einem Unternehmen, das behauptete, es könne vorhersagen, wie Menschen aufgrund ihrer demografischen Daten wählen würden.

1965 entwickelten Forscher sogenannte „Expertensysteme“. Diese Systeme ermöglichten es der KI, spezielle Probleme innerhalb von Computersystemen zu lösen, indem eine Sammlung von Fakten und eine Inferenzmaschine kombiniert wurden, um Daten zu interpretieren und auszuwerten.

Dann, ein Jahr später, im Jahr 1966, entwarf MIT-Professor Joseph Weizenbaum ein Mustervergleichsprogramm namens Eliza, das den Benutzern zeigte, dass KI intelligent ist. Benutzer könnten dem Programm Informationen geben, und Eliza, die als Psychotherapeutin fungiert, würde ihnen als Antwort eine offene Frage stellen.

Mitte der 1970er Jahre verloren Regierungen und Unternehmen das Vertrauen in KI. Die Finanzierung versiegte und die Zeit danach wurde als „KI-Winter“ bekannt. Während es in den 1980er und 1990er Jahren kleine Wiederauferstehungen gab, wurde KI meist in den Bereich der Science-Fiction verbannt und der Begriff wurde von ernsthaften Informatikern vermieden.

In den späten 1990er bis frühen 2000er Jahren sahen wir eine groß angelegte Anwendung von maschinellen Lerntechniken wie Bayes-Methoden zur Spam-Filterung durch Microsoft und kollaborative Filterung für Amazon-Empfehlungen.

KI des 21. Jahrhunderts:Wild erfolgreiche Pilotprogramme

In den 2000er Jahren ermöglichten Rechenleistung, größere Datensätze und der Aufstieg von Open-Source-Software Entwicklern, fortschrittliche Algorithmen zu entwickeln, die die Wissenschaft, Verbraucher, Fertigung und Geschäftswelt in relativ kurzer Zeit revolutionieren würden. KI ist heute für viele Unternehmen Realität geworden. McKinsey hat beispielsweise 400 Beispiele gefunden, in denen Unternehmen derzeit KI einsetzen, um geschäftliche Probleme anzugehen.

Das Web bietet neue Möglichkeiten, Daten zu organisieren

Die Webrevolution, die Anfang bis Mitte der 2000er Jahre die Welt erfasste, hinterließ in der Welt der KI-Forschung einige wichtige Veränderungen. Grundlegende Technologien wie Extensible Markup Language (XML) und PageRank organisierten Daten auf neue Weise, die KI nutzen könnte.

XML war eine Voraussetzung für das semantische Web und für Suchmaschinen. PageRank, eine frühe Innovation von Google, organisierte das Web weiter. Diese Fortschritte haben das Web benutzerfreundlicher gemacht und große Datenmengen für die KI besser zugänglich gemacht.

Gleichzeitig wurden Datenbanken beim Speichern und Abrufen von Daten immer besser, während Entwickler an funktionalen Programmiersprachen arbeiteten, die es einfacher machten, mit diesen Daten zu arbeiten. Die Tools standen Forschern und Entwicklern zur Verfügung, um die KI-Technologie voranzutreiben.

Neuronale Netze und Deep Learning demonstrieren das Potenzial von KI

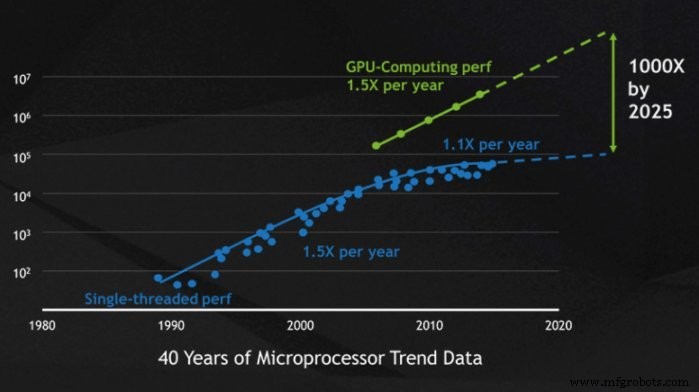

Im 20. Jahrhundert gab es große Träume von KI, aber die Rechenleistung hatte es fast unmöglich gemacht, sie zu bauen. Im 21. Jahrhundert wurden Computer jedoch exponentiell leistungsfähiger beim Speichern, Verarbeiten und Analysieren großer Datenmengen. Dies bedeutete, dass die hochgesteckten Ziele von neuronalen Netzwerken und Deep Learning Wirklichkeit werden konnten.

Die Forscher entwickelten Datensätze, die speziell für das Training von Maschinen geeignet waren, was zu neuronalen Netzen wie AlexNet führte. Zuvor stützte sich das maschinelle Training auf Datensätze, die in die Zehntausende gingen, aber der Fortschritt der Grafikprozessoren (GPUs) bedeutete, dass neue Datensätze in die Zehnmillionen gehen konnten.

Der Computerchip-Hersteller Nvidia brachte 2006 seine Parallel-Computing-Plattform CUDA auf den Markt. Innerhalb dieser Plattform verwendete Nvidia GPUs, um die Datenverarbeitung zu beschleunigen. Diese Leistungssteigerung half mehr Menschen, große und komplexe Modelle für maschinelles Lernen auszuführen, die in Bibliotheken für maschinelles Lernen wie TensorFlow und PyTorch geschrieben wurden.

Quelle

Später würden diese Bibliotheken Open Source werden und zu weit verbreiteten Experimenten anregen, wenn die Technologie zugänglicher wird. Diese Demokratisierung der KI würde dazu beitragen, aufregende neue Tools wie AlphaGo, Google DeepMind und IBM Deep Blue auf den Weg zu bringen.

Computer Vision öffnet die Tür zu neuen Industrieanwendungen

Bis in die 2000er Jahre war KI nur dann wirklich nützlich, wenn Sie Text verarbeiteten. Aber um die Jahrhundertwende brachten Fortschritte in der Computervision, die es Computern ermöglichten, Bilder zu erkennen und zu interpretieren, die Anwendungsfälle der KI auf neue Höhen.

Diesmal waren unsere Pioniere keine Akademiker. Stattdessen lebten sie in Ihrem Zuhause und machten das Reinigen (der Roomba) und das Spielen (die XBox Kinect) einfacher als je zuvor und brachten Computer Vision in Haushalte auf der ganzen Welt.

Wir haben auch gesehen, wie Computer Vision in neu entstehenden selbstfahrenden Autos und in Krankenhäusern eingesetzt wird, um automatisch Erkrankungen wie Läsionen und Lungenentzündungen zu erkennen.

Über branchenspezifische Anwendungsfälle hinaus trug die Variation von Computer Vision auch dazu bei, die Weiterentwicklung der robotergesteuerten Prozessautomatisierung (RPA) voranzutreiben. 🎉 Ergänzt durch optische Zeichenerkennung (OCR) können RPA-Roboter sowohl strukturierte als auch unstrukturierte Daten verarbeiten, was die Welt der Datenanalyse, wie wir sie kennen, verändert hat.

Datenanalyse verbessert KI-Geschäftsanwendungen

Die letzten zwei Jahrzehnte haben uns gezeigt, dass Automatisierung und KI sich mit komplexen Geschäftsanwendungsfällen messen können. Und da die KI bei der Analyse von Daten immer besser wird, können Unternehmen die KI noch stärker nutzen, um intelligenter und effizienter zu arbeiten.

Banken verwenden KI, um Kundenanfragen aus einer großen Menge unstrukturierter E-Mails, die jährlich eingehen, in verschiedene Kategorien zu klassifizieren. Dieser Prozess ist manuell intensiv oder führt zu schlechten Ergebnissen, wenn eine regelbasierte Schlüsselwortklassifizierung verwendet wird. KI ermöglicht es Banken, diese E-Mails mit hoher Genauigkeit zu klassifizieren und die durchschnittliche Bearbeitungszeit (AHT) zu reduzieren.

KI und Automatisierung helfen nicht nur Finanzdienstleistungsunternehmen. Kostenträger im Gesundheitswesen beschleunigen die Identifizierung von Risikoschwangerschaften. Der Software-Roboter lädt verifizierte Patientendaten und greift auf ein Vorhersagemodell zu, um den Patienten auf Risiken zu bewerten, und bestimmt den geeigneten Pflegemanagementplan. Die Ergebnisse sind eine 24 % höhere Anzahl von Schwangerschaften mit niedrigem Geburtsgewicht, die genau identifiziert wurden, während 44 % der Schwangerschaften mit niedrigem Geburtsgewicht vermieden wurden – insgesamt Einsparungen von 11 Millionen US-Dollar pro Jahr. Lesen Sie die ganze Geschichte.

Verarbeitung natürlicher Sprache und Spracherkennung steigern die Benutzerfreundlichkeit von KI

KI hat zwar mit der Textanalyse begonnen, beherrscht sie aber noch lange nicht. Bis vor kurzem mussten Texte – auch mit OCR – in maschinenlesbare Formate strukturiert werden. Das Gebiet der Verarbeitung natürlicher Sprache (NLP) hat die Fähigkeit, Computer so zu programmieren, dass sie natürliche Sprache verstehen, auf den neuesten Stand gebracht.

Eines der bekannteren Beispiele für NLP ist Generative Pre-Trained Transformer 3 (besser bekannt als GPT-3). GPT-3, das im Mai 2020 eingeführt wurde, verwendet Deep Learning, um Text zu generieren, der menschengemachtem Text sehr ähnlich ist. Es sind bereits interessante Anwendungen für GPT-3 aufgetaucht, wie das Verfassen von Artikeln (z. B. beauftragte The Guardian GPT-3 mit dem Verfassen eines Artikels über die Harmlosigkeit von Robotern) und das Erstellen von Computerprogrammen.

Die Anwendungen von NLP gehen über GPT-3 hinaus. NLP kann verwendet werden, um Text aus Sprache zu erstellen, die Bedeutung eines Textabschnitts automatisch zusammenzufassen, Text sprachübergreifend zu übersetzen und vieles mehr.

Obwohl NLP oft auf dem neuesten Stand ist, hat es auch seinen Weg in unsere Häuser gefunden. Virtuelle Assistenten wie Alexa und Google können beispielsweise Anfragen in natürlicher Sprache verarbeiten und in ausführbare Befehle übersetzen. Mit einer einfachen Sprachanfrage können diese KI-Assistenten nach Informationen suchen; Befehle an intelligente Geräte wie Lampen oder Schlösser weiterleiten; und mehr.

Die Zukunft der KI:Ein Wendepunkt für Unternehmen

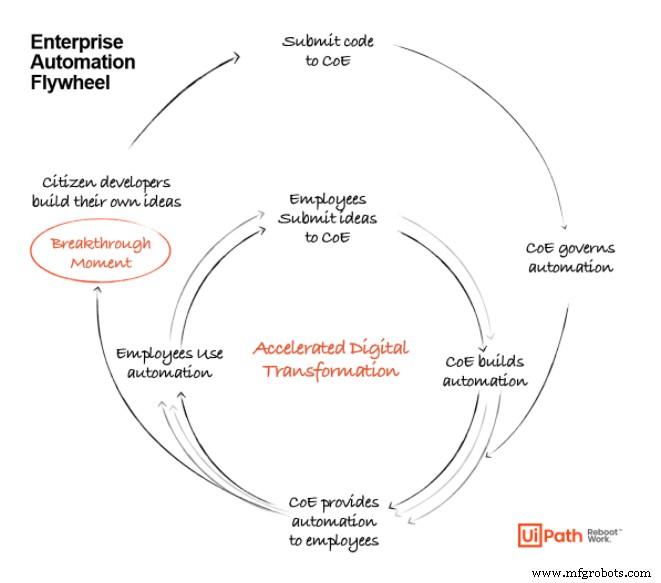

Während wir in das nächste Jahrzehnt der Technologiereife eintreten, werden die Anwendungsfälle für KI in Unternehmen weiter zunehmen. Frühere Tools haben den Grundstein dafür gelegt, was mit KI möglich ist, aber es gibt noch viel zu tun, wenn diese Tools skaliert werden.

Da die KI noch weiter voranschreitet, werden wir sehen, dass Unternehmen RPA, maschinelles Lernen, Process Mining und Datenanalyse nutzen, um eine leistungsstarke End-to-End-Suite der Automatisierung zu schaffen, da diese Technologien für Unternehmen in allen Reifestadien immer zugänglicher werden . KI wird nicht länger die ausschließliche Domäne von Forschern und Entwicklern sein; Alltagsnutzer werden mithilfe moderner Tools in der Lage sein, KI-basierte Lösungen für die von ihnen identifizierten Probleme zu entwickeln.

Da die Technologie für Geschäftsanwender zugänglicher wird, werden wir sehen, wie sich das Schwungrad der Automatisierung dreht, um Unternehmen immer mehr Ideen und Möglichkeiten für KI-Anwendungen zu bieten. Diese Möglichkeiten werden durch hochmoderne Automatisierungsplattformen und Tools unterstützt, die unsere Arbeitsweise neu starten und revolutionieren werden.

UiPath AI Fabric macht es Benutzern leicht, ein Modell zu starten, Daten hineinzupumpen, Einblicke zu erhalten und die Nützlichkeit zu bewerten.

Anmerkung der Redaktion: Da sich der Automatisierungsmarkt weiter entwickelt, wird auch die UiPath-Plattform aktualisiert, um die Automatisierungsanforderungen unserer Kunden bestmöglich zu erfüllen. Daher hat sich der Produktname AI Fabric seit der ursprünglichen Veröffentlichung des Artikels weiterentwickelt. Aktuelle Informationen erhalten Sie Besuchen Sie unsere KI-Center-Seite .

KI heute:Der richtige Moment zum Einstieg

Es ist Zeit zu automatisieren. Wir haben ein Stadium in der KI-Entwicklung erreicht, in dem sie nicht mehr theoretisch ist, sondern zwingend erforderlich ist und Unternehmen, die sich darauf einlassen, voraussichtlich Hunderte von Milliarden Dollar an Wert freisetzen wird.

Finden Sie heraus, wie führende Unternehmen Automatisierung und KI nutzen, um die Vision eines vollständig automatisierten Unternehmens™ Wirklichkeit werden zu lassen:

Automatisierungssteuerung System

- Die Geschichte und Zukunft der Aluminiumextrusion

- Boston Dynamics &Trimble:Die Zukunft des Bauens

- Fabriken der Zukunft:Industrielle Fertigung 1.0 bis 4.0

- Nokias „bewusste“ Fabrik der Zukunft

- Die Zukunft der Instandhaltungstechnik

- Automatisierung und die Zukunft der digitalen Fertigung?

- Der Ursprung des Sägekonzepts:Geschichte und Zukunft

- Was ist in Zukunft vom CNC-Fräsen zu erwarten?

- Willkommen in der Zukunft der 3D-Vision

- Cobots vs. Roboter – Die Zukunft der Fertigung