Mikrocontroller-Architekturen entwickeln sich für KI

Was erhalten Sie, wenn Sie KI mit dem IoT kreuzen? AIoT ist die einfache Antwort, aber Sie erhalten auch einen riesigen neuen Anwendungsbereich für Mikrocontroller, der durch Fortschritte bei neuronalen Netzwerktechniken ermöglicht wird, die bedeuten, dass maschinelles Lernen nicht mehr auf die Welt der Supercomputer beschränkt ist. Heutzutage können (und werden) Smartphone-Anwendungsprozessoren KI-Inferenzen für die Bildverarbeitung, Empfehlungsmaschinen und andere komplexe Funktionen durchführen.

Ein Ökosystem aus Milliarden von IoT-Geräten wird in den nächsten Jahren maschinelle Lernfähigkeiten erhalten (Bild:NXP)

Diese Art von Fähigkeiten in den bescheidenen Mikrocontroller zu bringen, stellt eine große Chance dar. Stellen Sie sich ein Hörgerät vor, das mithilfe von KI Hintergrundgeräusche aus Gesprächen filtern kann, intelligente Haushaltsgeräte, die das Gesicht des Benutzers erkennen und zu seinen personalisierten Einstellungen wechseln können, und KI-fähige Sensorknoten, die mit kleinsten Batterien jahrelang betrieben werden können. Die Verarbeitung der Daten am Endpunkt bietet Latenz-, Sicherheits- und Datenschutzvorteile, die nicht ignoriert werden können.

Ein sinnvolles maschinelles Lernen mit Geräten auf Mikrocontroller-Ebene zu erreichen, ist jedoch keine leichte Aufgabe. So ist beispielsweise der Speicher, ein wichtiges Kriterium für KI-Berechnungen, oft stark eingeschränkt. Aber die Datenwissenschaft schreitet schnell voran, um die Modellgröße zu reduzieren, und Geräte- und IP-Anbieter reagieren darauf, indem sie Tools entwickeln und Funktionen integrieren, die auf die Anforderungen des modernen maschinellen Lernens zugeschnitten sind.

TinyML startet durch

Als Zeichen für das schnelle Wachstum dieses Sektors wird der TinyML Summit (eine neue Branchenveranstaltung, die Anfang dieses Monats im Silicon Valley stattfindet) immer stärker. Der erste Gipfel, der letztes Jahr stattfand, hatte 11 Sponsoring-Unternehmen, während die diesjährige Veranstaltung 27 hatte, wobei die Slots viel früher ausverkauft waren, so die Organisatoren, die auch sagten, dass die Mitgliederzahl für ihre globalen monatlichen Treffen für Designer dramatisch gestiegen ist.

„Wir sehen eine neue Welt mit Billionen intelligenter Geräte, die durch TinyML-Technologien ermöglicht werden, die erkennen, analysieren und autonom agieren, um eine gesündere und nachhaltigere Umgebung für alle zu schaffen“, sagte Evgeni Gousev, Co-Vorsitzender des TinyML-Komitees, in seinem Eröffnungsrede bei der Show.

Gousev führte dieses Wachstum auf die Entwicklung energieeffizienterer Hardware und Algorithmen in Kombination mit ausgereifteren Softwaretools zurück. Unternehmens- und Risikokapitalinvestitionen nehmen ebenso zu wie Startup- und M&A-Aktivitäten, stellte er fest.

Heute ist das TinyML-Komitee der Ansicht, dass die Technologie validiert wurde und dass erste Produkte, die maschinelles Lernen in Mikrocontrollern verwenden, in 2-3 Jahren auf den Markt kommen sollten. "Killer-Apps" werden in 3-5 Jahren erwartet.

Ein großer Teil der technischen Validierung erfolgte im vergangenen Frühjahr, als Google zum ersten Mal eine Version seines TensorFlow-Frameworks für Mikrocontroller vorstellte. TensorFlow Lite für Mikrocontroller wurde für die Ausführung auf Geräten mit nur Kilobyte Arbeitsspeicher entwickelt (die Kernlaufzeit passt in 16 KB auf einem Arm Cortex M3 und mit genügend Operatoren, um ein Modell zur Erkennung von Sprachschlüsselwörtern auszuführen, nimmt es insgesamt 22 KB ein). Es unterstützt nur Inferenz (kein Training).

Große Spieler

Die großen Mikrocontroller-Hersteller beobachten die Entwicklungen in der TinyML-Community natürlich mit Interesse. Da die Forschung es ermöglicht, neuronale Netzwerkmodelle zu verkleinern, werden ihre Möglichkeiten größer.

Die meisten bieten eine Art Unterstützung für Machine-Learning-Anwendungen. STMicroelectronics hat beispielsweise ein Erweiterungspaket, STM32Cube.AI, das die Abbildung und den Betrieb neuronaler Netze auf seiner STM32-Familie von Arm Cortex-M-basierten Mikrocontrollern ermöglicht.

Renesas verfügt über seine e-AI-Entwicklungsumgebung, die es ermöglicht, KI-Inferenz auf Mikrocontrollern zu implementieren. Es übersetzt das Modell effektiv in eine Form, die in seiner e 2 . verwendbar ist studio, kompatibel mit C/C++-Projekten.

NXP hat nach eigenen Angaben Kunden, die seine Kinetis- und LPC-MCUs der unteren Preisklasse für Anwendungen des maschinellen Lernens verwenden. Das Unternehmen setzt auf KI mit Hardware- und Softwarelösungen, wenn auch hauptsächlich auf seine größeren Anwendungsprozessoren und Crossover-Prozessoren (zwischen Anwendungsprozessoren und Mikrocontrollern) ausgerichtet.

Stark bewaffnet

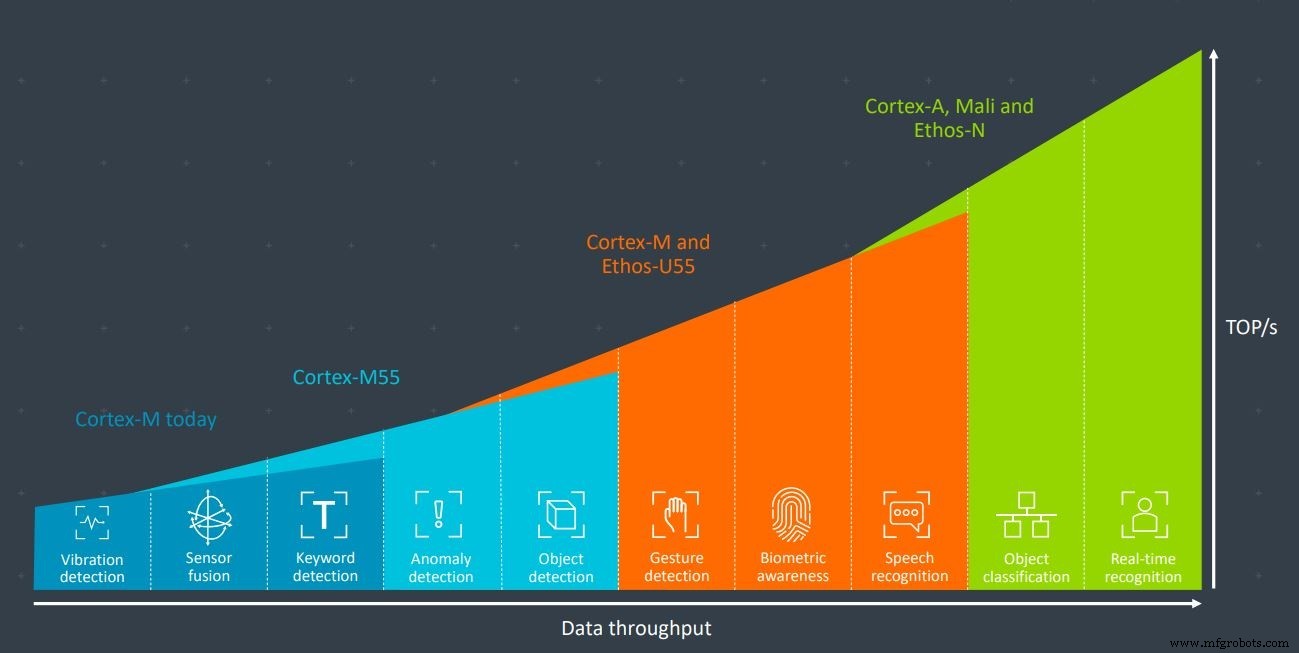

Die meisten etablierten Unternehmen im Mikrocontroller-Bereich haben eines gemeinsam:Arm. Der Embedded-Prozessor-Core-Riese dominiert mit seiner Cortex-M-Serie den Mikrocontroller-Markt. Das Unternehmen hat kürzlich den brandneuen Cortex-M55-Kern angekündigt, der speziell für maschinelle Lernanwendungen entwickelt wurde, insbesondere in Kombination mit dem Ethos-U55-KI-Beschleuniger. Beide sind für Umgebungen mit eingeschränkten Ressourcen konzipiert.

Cortex-M55 und Ethos-U55 von Arm verfügen über genügend Rechenleistung für Anwendungen wie Gestenerkennung, Biometrie und Spracherkennung (Bild:Arm)

Aber wie können Startups und kleinere Unternehmen mit den Big Playern in diesem Markt konkurrieren?

„Nicht durch den Bau von Arm-basierten SoCs! Weil sie das wirklich gut machen“, lachte Mark Lippett, CEO von XMOS. „Die einzige Möglichkeit, gegen diese Jungs anzutreten, besteht darin, einen architektonischen Vorsprung zu haben … [das bedeutet] die intrinsischen Fähigkeiten des Xcore in Bezug auf die Leistung, aber auch die Flexibilität.“

Obwohl der Xcore.ai von XMOS, sein neu veröffentlichter Crossover-Prozessor für Sprachschnittstellen, nicht direkt mit Mikrocontrollern konkurrieren wird, gilt die Meinung immer noch. Jedes Unternehmen, das einen ARM-basierten SoC herstellt, um mit den Großen zu konkurrieren, hat besser etwas ganz Besonderes in seiner geheimen Sauce.

Skalierung von Spannung und Frequenz

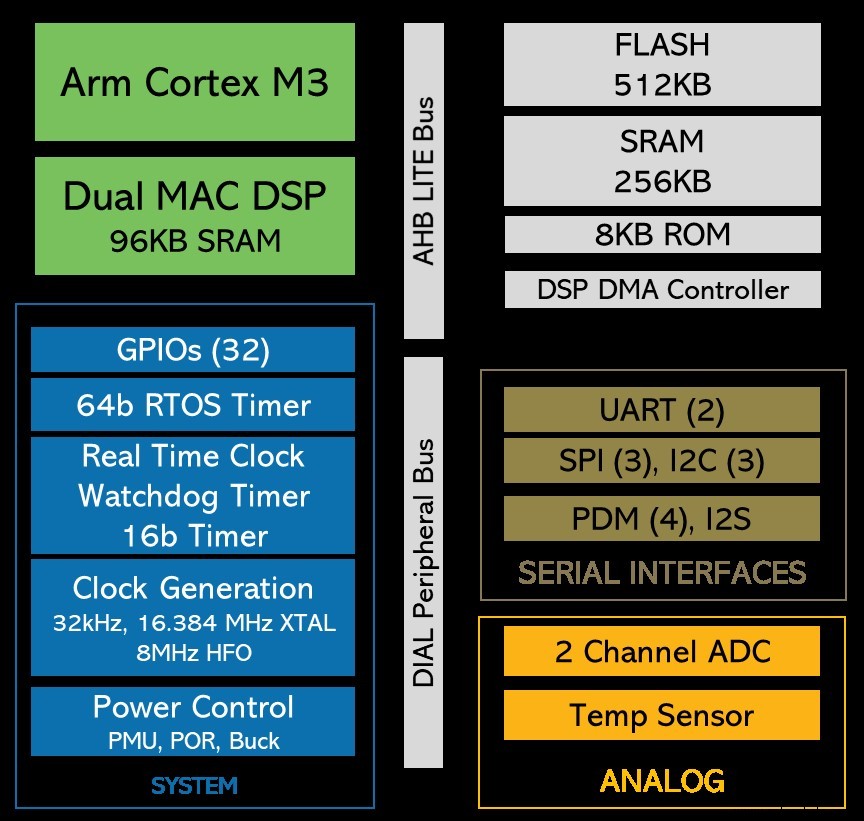

Das Startup Eta Compute hat während der TinyML-Show sein mit Spannung erwartetes Ultra-Low-Power-Gerät veröffentlicht. Es kann für maschinelles Lernen in Always-on-Bildverarbeitungs- und Sensorfusionsanwendungen mit einem Leistungsbudget von 100 µW verwendet werden. Der Chip verwendet einen Arm Cortex-M3-Kern plus einen NXP-DSP-Kern – einer oder beide Kerne können für ML-Workloads verwendet werden. Die geheime Sauce des Unternehmens besteht aus mehreren Zutaten, aber entscheidend ist die Art und Weise, wie sowohl die Taktfrequenz als auch die Spannung für beide Kerne kontinuierlich skaliert werden. Das spart viel Strom, zumal es ohne PLL (Phase Locked Loop) erreicht wird.

Der ECM3532 von Eta Compute verwendet einen Arm Cortex-M3-Kern plus einen NXP CoolFlux DSP-Kern. Die Arbeitslast des maschinellen Lernens kann von einem oder beiden verarbeitet werden (Bild:Eta Compute)

Warum hat sich Eta Compute für die Verwendung eines Arm-Kerns für die Beschleunigung des maschinellen Lernens mit extrem niedrigem Stromverbrauch entschieden, da es jetzt lebensfähige Konkurrenten für Arm gibt, einschließlich der aufstrebenden Befehlssatzarchitektur, die von der RISC-V-Stiftung angeboten wird?

„Die einfache Antwort ist, dass das Ökosystem für Arm einfach so gut entwickelt ist“, sagte Tewksbury gegenüber EETimes . „Es ist im Moment einfach viel einfacher, mit Arm in die Produktion zu gehen als mit RISC-V. Diese Situation könnte sich in Zukunft ändern… RISC-V hat seine eigenen Vorteile; sicherlich ist es gut für den chinesischen Markt, aber wir schauen derzeit hauptsächlich auf die heimischen und europäischen Märkte mit dem Ökosystem für [unser Gerät].“

Tewksbury stellte fest, dass die größte Herausforderung für das AIoT die Breite und Vielfalt der Anwendungen ist. Der Markt ist ziemlich fragmentiert, mit vielen relativ Nischenanwendungen, die nur geringe Volumina aufweisen. Insgesamt erstreckt sich dieser Sektor jedoch potenziell auf Milliarden von Geräten.

„Die Herausforderung für Entwickler besteht darin, dass sie es sich nicht leisten können, Zeit und Geld in die Entwicklung maßgeschneiderter Lösungen für jeden dieser Anwendungsfälle zu investieren“, sagte Tewksbury. „Hier stehen Flexibilität und Benutzerfreundlichkeit im Vordergrund. Und das ist ein weiterer Grund, warum wir uns für Arm entschieden haben – weil das Ökosystem vorhanden ist, die Tools vorhanden sind und es für Kunden einfach ist, Produkte schnell zu entwickeln und sie ohne viel Anpassung schnell auf den Markt zu bringen.“

Nachdem Arm seine ISA jahrzehntelang unter Verschluss gehalten hatte, kündigte Arm schließlich im vergangenen Oktober an, dass es seinen Kunden ermöglichen wird, ihre eigenen benutzerdefinierten Anweisungen für den Umgang mit speziellen Workloads wie maschinellem Lernen zu erstellen. Diese Fähigkeit kann in den richtigen Händen auch die Möglichkeit bieten, den Stromverbrauch weiter zu senken.

Eta Compute kann dies noch nicht nutzen, da es nicht rückwirkend für vorhandene ARM-Kerne gilt, also nicht für den M3-Kern, den Eta verwendet. Aber könnte Tewksbury sehen, dass Eta Compute in zukünftigen Produktgenerationen benutzerdefinierte Anweisungen von Arm verwendet, um den Stromverbrauch weiter zu senken?

„Absolut, ja“, sagte er.

Alternative ISAs

RISC-V hat dieses Jahr viel Aufmerksamkeit erregt. Die Open-Source-ISA ermöglicht das Design von Prozessoren ohne Lizenzgebühr, während Designs, die auf der RISC-V-ISA basieren, wie bei jeder anderen Art von IP geschützt werden können. Designer können auswählen, welche Erweiterungen hinzugefügt werden sollen, und können ihre eigenen benutzerdefinierten Erweiterungen hinzufügen.

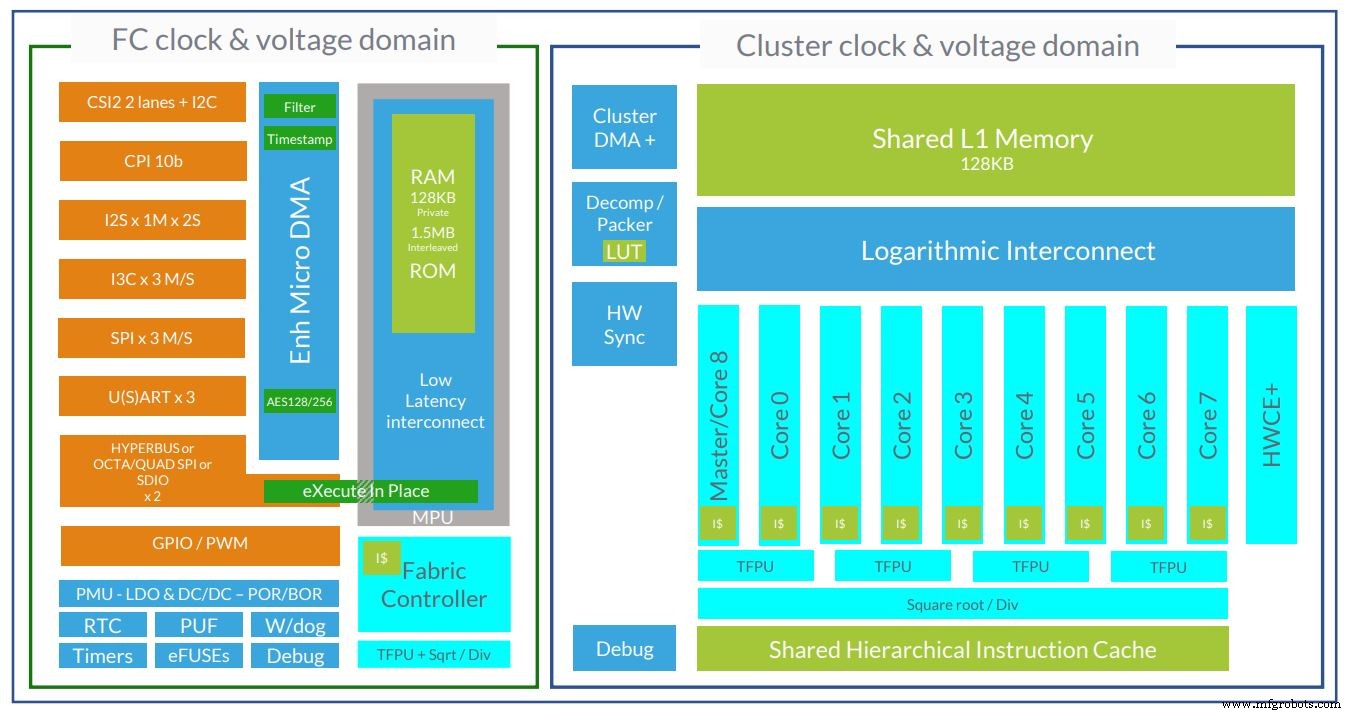

Das französische Startup GreenWaves ist eines von mehreren Unternehmen, die RISC-V-Kerne verwenden, um den Bereich des maschinellen Lernens mit extrem geringem Stromverbrauch anzusprechen. Die Geräte GAP8 und GAP9 verwenden 8- bzw. 9-Kern-Rechencluster.

Die Architektur des GAP9 Ultra-Low-Power-KI-Chips von GreenWaves verwendet jetzt 10 RISC-V-Kerne (Bild:GreenWaves)

Martin Croome, Vice President of Business Development bei GreenWaves, erklärte gegenüber EETimes warum das Unternehmen RISC-V-Kerne verwendet.

„Der erste Grund ist, dass RISC-V uns die Möglichkeit gibt, die Kerne auf Befehlssatzebene anzupassen, die wir häufig verwenden“, sagte Croome und erklärte, dass die benutzerdefinierten Erweiterungen verwendet werden, um die Leistung sowohl des maschinellen Lernens als auch der Signalverarbeitungs-Workloads zu reduzieren . „Als das Unternehmen gegründet wurde, war es entweder unmöglich, dies mit einer anderen Prozessorarchitektur zu erreichen, oder es würde Sie ein Vermögen kosten. Und das Vermögen, das es Sie kosten würde, war im Wesentlichen das Geld Ihres Investors, das an ein anderes Unternehmen ging, und das ist sehr schwer zu rechtfertigen.“

Allein die benutzerdefinierten Erweiterungen von GreenWaves verleihen seinen Kernen eine 3,6-fache Verbesserung des Energieverbrauchs im Vergleich zu nicht modifizierten RISC-V-Kernen. Croome sagte jedoch auch, dass RISC-V grundlegende technische Vorteile hat, einfach weil es neu ist.

„Es ist ein sehr sauberer, moderner Befehlssatz. Es hat kein Gepäck. Aus Implementierungssicht ist der RISC-V-Kern also eigentlich eine einfachere Struktur, und einfach bedeutet weniger Strom“, sagte er.

Croome nannte auch die Kontrolle als einen wichtigen Faktor. Das GAP8-Gerät hat 8 Kerne in seinem Rechencluster, und GreenWaves benötigt eine sehr feine, detaillierte Kontrolle über die Kernausführung, um eine maximale Energieeffizienz zu ermöglichen. RISC-V ermöglicht das, sagte er.

„Am Ende, wenn wir all das mit Arm hätten machen können, hätten wir das alles mit Arm gemacht, es wäre eine viel logischere Entscheidung gewesen… Weil niemand jemals gefeuert wurde, weil er Arm gekauft hat“, scherzte er . „Die Softwaretools haben einen Reifegrad, der weit über dem von RISC-V liegt… aber das heißt, der Fokus liegt jetzt so stark auf RISC-V, dass diese Tools sehr schnell an Reife gewinnen.“

Zusammenfassend lässt sich sagen, dass Arms Einfluss auf den Mikroprozessormarkt von einigen als schwächer empfunden wird, teilweise aufgrund des verstärkten Wettbewerbs durch RISC-V, das Unternehmen reagiert jedoch, indem es einige kundenspezifische Erweiterungen zulässt und von Anfang an neue Kerne entwickelt, die für maschinelles Lernen ausgelegt sind.

Tatsächlich kommen sowohl Arm- als auch Nicht-Arm-Geräte für Machine-Learning-Anwendungen mit extrem geringem Stromverbrauch auf den Markt. Während die TinyML-Community weiterhin daran arbeitet, die Größe des neuronalen Netzwerkmodells zu reduzieren und dedizierte Frameworks und Tools zu entwickeln, wird dieser Sektor zu einem gesunden Anwendungsbereich, der eine Vielzahl verschiedener Gerätetypen unterstützt.

Eingebettet

- Schneidlösung für die Teppichindustrie – Digitale Schneidemaschine

- Eine Checkliste für Ausrichtung und Weichfuß

- Ein Leitfaden für den Kauf gebrauchter CNC-Maschinen

- 4 Tipps für Anfänger von CNC-Fräsmaschinen

- Kaufanleitung für gebrauchte CNC-Drehmaschinen

- Sicherheitstipps am Arbeitsplatz für CNC-Maschinisten

- Kaufanleitung für gebrauchte CNC-Maschinen

- Tipps zur Auswahl der richtigen CNC-Maschine

- Beste Metall-CNC-Maschine für Metallunternehmen im Jahr 2022

- 2090 CNC-Holzmaschine für einen australischen Kunden