Neuromorphic Computing Dev Kits Debüt

BrainChip, der Anbieter von neuromorphem Computing-IP, hat während der jüngsten Linley Fall Processor Conference zwei Entwicklungskits für seinen neuromorphen Akida-Prozessor vorgestellt. Beide Kits enthalten den neuromorphen Akida-SoC des Unternehmens:ein x86-Shuttle-PC-Entwicklungskit und ein Arm-basiertes Raspberry Pi-Kit. BrainChip bietet die Tools Entwicklern an, die mit seinem Spiking-Neural-Network-Prozessor arbeiten, in der Hoffnung, sein geistiges Eigentum zu lizenzieren. Akida-Silizium ist ebenfalls erhältlich.

Die neuromorphen Technologien von BrainChip ermöglichen KI mit extrem geringem Stromverbrauch für die Analyse von Daten in Edge-Systemen, bei denen eine extrem stromsparende Echtzeitverarbeitung von Sensordaten angestrebt wird. Das Unternehmen hat eine neuronale Verarbeitungseinheit (NPU) entwickelt, die entwickelt wurde, um Spiking Neural Networks (SNNs) zu verarbeiten, ein vom Gehirn inspiriertes neuronales Netzwerk, das sich von herkömmlichen Deep-Learning-Ansätzen unterscheidet. Wie das Gehirn beruht ein SNN auf „Spikes“, die Informationen räumlich und zeitlich übermitteln. Das heißt, das Gehirn erkennt sowohl Sequenzen als auch das Timing von Spikes. Als „Ereignisdomäne“ bezeichnete Spitzen resultieren normalerweise aus Änderungen der Sensordaten (z. B. Änderungen der Pixelfarben in einer ereignisbasierten Kamera).

Zusammen mit SNNs können die NPUs von BrainChip auch Convolutional Neural Networks (CNNs) verarbeiten, wie sie typischerweise in Computer Vision und Keyword-Spotting-Algorithmen mit geringerer Leistung als andere Edge-Implementierungen verwendet werden. Dies erfolgt durch Konvertieren von CNNs in SNNs und Ausführen der Inferenz in der Ereignisdomäne. Der Ansatz ermöglicht auch On-Chip-Lernen am Edge, eine Qualität von SNNs, die auf konvertierte CNNs ausgeweitet werden würde.

Die Entwicklungsboards von BrainChip sind für x86-Shuttle-PCs oder Raspberry Pi erhältlich. (Quelle:BrainChip)

Akida „ist bereit für die neuromorphe Technologie von morgen, aber sie löst das heutige Problem, neuronale Netzinferenz auf Edge- und IoT-Geräten zu ermöglichen“, sagte Anil Mankar, Mitbegründer und Chief Development Officer von BrainChip, gegenüber EE Times .

Die Konvertierung von CNN in die Ereignisdomäne erfolgt durch den Software-Tool-Flow von BrainChip, MetaTF. Daten können in Spitzen umgewandelt werden und trainierte Modelle können so umgewandelt werden, dass sie auf der NPU von BrainChip ausgeführt werden.

„Unsere Laufzeitsoftware nimmt die Angst vor ‚Was ist eine SNN?‘ und ‚Was ist die Ereignisdomäne?‘“, sagte Mankar. „Wir tun alles, um das zu verbergen.

„Leute, die mit der TensorFlow- oder Keras-API vertraut sind … können die Anwendung, die sie auf [anderer Hardware], demselben Netzwerk, demselben Datensatz ausführen, mit unserem quantisierungsbewussten Training auf unserer Hardware ausführen und die Leistung selbst messen und sehen Sie, wie die Genauigkeit sein wird.“

CNNs eignen sich besonders gut zum Extrahieren von Funktionen aus großen Datensätzen, erklärte Mankar, und die Konvertierung in die Ereignisdomäne bewahrt diesen Vorteil. Die Faltungsoperation wird für die meisten Schichten in der Ereignisdomäne erreicht, aber die letzte Schicht wird ersetzt. Das Ersetzen durch eine Schicht, die eingehende Spikes erkennt, gibt dem sonst üblichen CNN die Möglichkeit, über die Spike-Timing-abhängige Plastizität am Rand zu lernen, wodurch ein erneutes Training in der Cloud vermieden wird.

Während native SNNs (die für die Ereignisdomäne von Grund auf neu geschrieben wurden) eine 1-Bit-Präzision verwenden können, erfordern konvertierte CNNs 1-, 2- oder 4-Bit-Spitzen. Das Quantisierungstool von BrainChip hilft Designern bei der Entscheidung, wie aggressiv die Quantisierung auf Schicht-für-Schicht-Basis erfolgen soll. Brainchip hat MobileNet V1 für die 10-Objekt-Klassifizierung mit einer Vorhersagegenauigkeit von 93,1 Prozent nach der Quantisierung auf 4 Bit quantisiert.

Ein Nebenprodukt der Konvertierung in die Ereignisdomäne sind erhebliche Energieeinsparungen aufgrund von Sparsity. Aktivierungs-Map-Werte ungleich Null werden als 1- bis 4-Bit-Ereignisse dargestellt, und die NPU führt nur Berechnungen für Ereignisse durch und nicht die gesamte Aktivierungs-Map.

Entwickler "können sich die Gewichte ansehen und Gewichte ungleich Null sehen und versuchen, eine Multiplikation mit Nullgewichten zu vermeiden", sagte Mankar. "Aber das bedeutet, dass Sie wissen müssen, wo die Nullen sind, und es sind Berechnungen erforderlich" für diese Operationen.

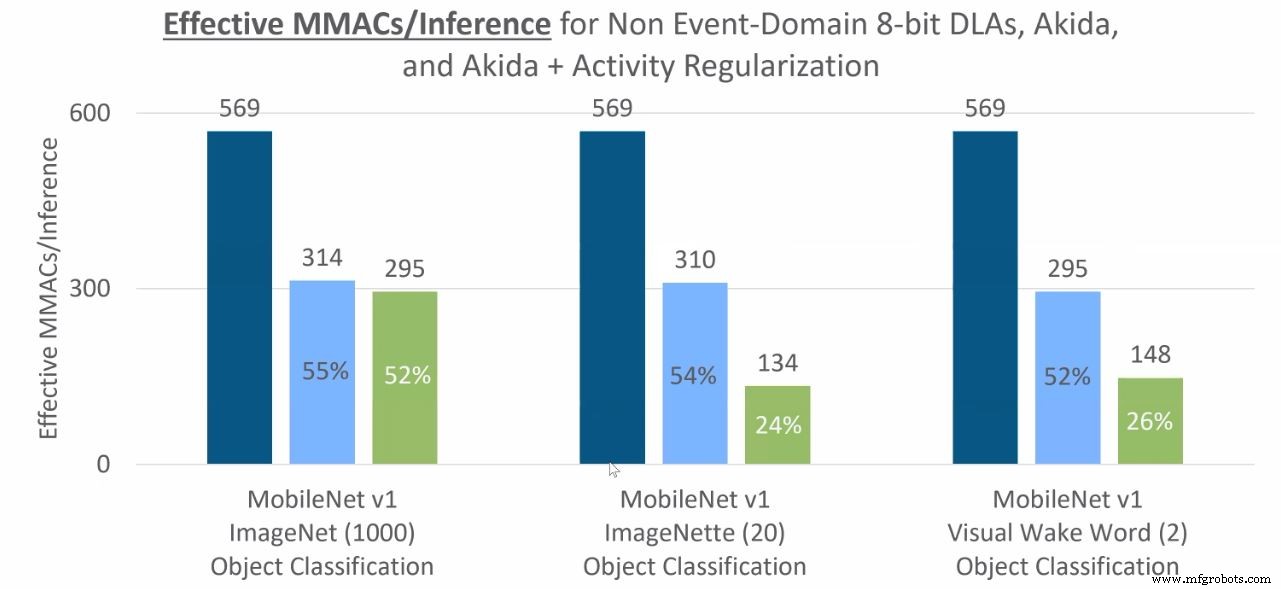

Für ein typisches CNN würde sich die Aktivierungskarte mit jedem Videoframe ändern, da die ReLU-Funktionen um Null herum zentriert sind – normalerweise ist die Hälfte der Aktivierungen Null. Indem aus diesen Nullen keine Spitzen gemacht werden, ist die Berechnung in der Ereignisdomäne auf Aktivierungen ungleich Null beschränkt. Die Konvertierung von CNNs zur Ausführung in der Ereignisdomäne kann Sparsity nutzen und die Anzahl der MAC-Operationen, die für die Inferenz erforderlich sind, und damit den Stromverbrauch schnell reduzieren.

Zu den Funktionen, die in die Ereignisdomäne konvertiert werden können, gehören Faltung, punktweise Faltung, tiefenweise Faltung, maximales Pooling und globales Durchschnitts-Pooling.

MAC-Operationen, die für die Objektklassifizierungsinferenz erforderlich sind (dunkelblau ist CNN in der Nicht-Ereignisdomäne, hellblau ist Ereignisdomäne/Akida, Grün ist Ereignisdomäne mit weiterer Aktivitätsregularisierung). (Quelle:BrainChip)

In einem Beispiel verbrauchte ein Keyword-Spotting-Modell, das auf dem Akida-Entwicklungsboard nach 4-Bit-Quantisierung ausgeführt wurde, nur 37 µJ pro Inferenz (oder 27.336 Inferenzen pro Sekunde pro Watt). Die Vorhersagegenauigkeit betrug 91,3 Prozent und der Chip wurde auf 5 MHz verlangsamt, um die beobachtete Leistung zu erreichen. (siehe Grafik unten).

Sensorunabhängig

Die NPU IP von BrainChip und der Akida-Chip sind unabhängig vom Netzwerktyp und können zusammen mit den meisten Sensoren verwendet werden. Dieselbe Hardware kann Bild- und Audiodaten mithilfe der CNN-Konvertierung oder der SNNs von BrainChip für olfaktorische, gustatorische und Vibrations-/taktile Wahrnehmung verarbeiten.

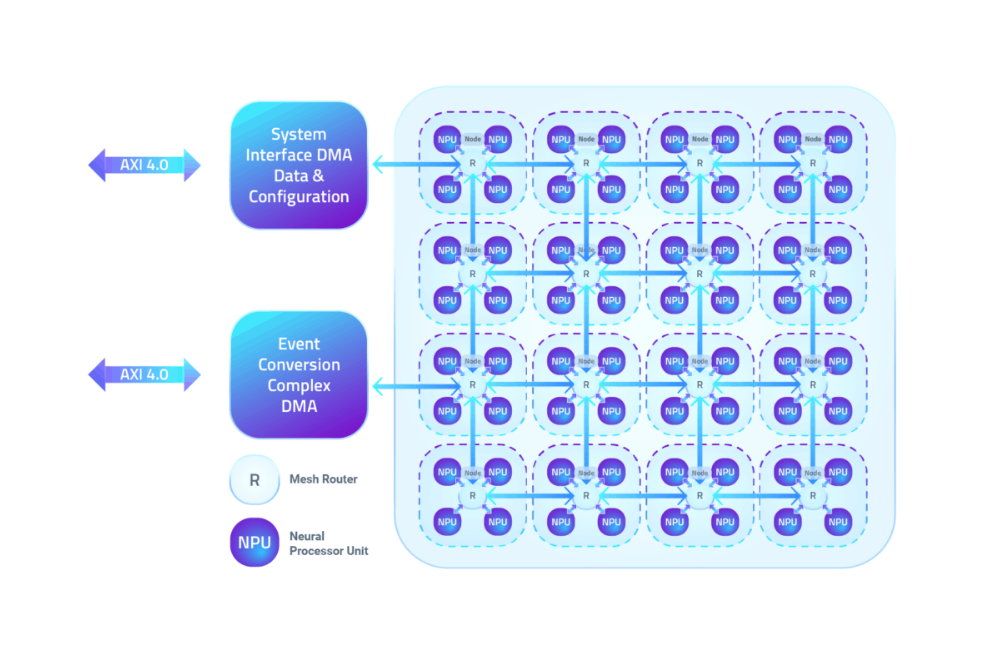

NPUs sind zu vier Knoten zusammengefasst, die über ein Mesh-Netzwerk kommunizieren. Jede NPU umfasst Verarbeitung und 100 kB lokalen SRAM für Parameter, Aktivierungen und interne Ereignispuffer. CNN- oder SNN-Netzwerkschichten werden einer Kombination mehrerer NPUs zugewiesen, die Ereignisse zwischen Schichten ohne CPU-Unterstützung weiterleiten. (Während andere Netzwerke als CNNs in die Ereignisdomäne umgewandelt werden können, sagte Mankar, dass sie eine CPU benötigen, um auf Akida zu laufen.)

Die NPU IP von BrainChip kann für bis zu 20 Knoten konfiguriert werden, und größere Netzwerke können in mehreren Durchgängen auf Designs mit weniger Knoten betrieben werden.

Knoten von vier BrainChip NPUs sind durch ein Mesh-Netzwerk verbunden. (Quelle:BrainChip)

Ein BrainChip-Video zeigte einen Akida-Chip, der in einem Fahrzeuginnenraumsystem eingesetzt wird, wobei ein Chip verwendet wird, um einen Fahrer zu erkennen, das Gesicht des Fahrers zu erkennen und gleichzeitig seine Stimme zu identifizieren. Die Schlüsselworterkennung erforderte 600 µW, die Gesichtserkennung 22 mW und die visuelle Wake-Word-Inferenz, die zur Erkennung des Fahrers verwendet wurde, betrug 6-8 mW.

Der niedrige Stromverbrauch solcher Automobilplattformen bietet Autoherstellern in anderen Bereichen Flexibilität, sagte Rob Telson, Vice President für den weltweiten Vertrieb von BrainChips, und fügte hinzu, dass der Akida-Chip auf der 28-nm-Prozesstechnologie von Taiwan Semiconductor Manufacturing Co. basiert. IP-Kunden können zu feineren Prozessknoten wechseln, um mehr Energie zu sparen, fügte Telson hinzu.

In der Zwischenzeit können Gesichtserkennungssysteme neue Gesichter auf dem Chip lernen, ohne in die Cloud zu wechseln. Eine intelligente Türklingel könnte zum Beispiel das Gesicht einer Person durch einmaliges Lernen lokal identifizieren. Vorausgesetzt, der letzten Schicht des Netzwerks wird eine ausreichende Anzahl von Neuronen zugewiesen, könnte die Gesamtzahl der erkannten Gesichter von 10 auf über 50 erhöht werden, bemerkte Mankar.

Early Access-Kunden

BrainChip beschäftigt 55 Mitarbeiter in seinem Hauptsitz in Aliso Viejo, Kalifornien, sowie seinen Konstruktionsbüros in Toulouse, Frankreich, Hyderabad, Indien, und Perth, Australien. Das Unternehmen besitzt 14 Patente und wird an der australischen Börse und der US-Over-the-Counter-Börse gehandelt.

Etwa 15 Early-Access-Kunden, darunter die NASA, sagte Telson. Andere umfassen Automobil-, Militär-, Luft- und Raumfahrt-, Medizin- (olfaktorische Covid-19-Erkennung) und Unterhaltungselektronikunternehmen. BrainChip zielt auf Verbraucheranwendungen wie Smart Health, Smart City, Smart Home und Smart Transportation ab.

Ein weiterer früher Kunde ist der Mikrocontroller-Spezialist Renesas, der laut Telson eine 2-Knoten-Akida-NPU-IP für die Integration in eine zukünftige MCU zur Sensordatenanalyse in IoT-Implementierungen lizenziert hat.

Akida IP und Silizium sind jetzt verfügbar.

>> Dieser Artikel wurde ursprünglich auf unserer Schwesterseite EE Times veröffentlicht.

Verwandte Inhalte:

- Startup packt 1000 RISC-V-Kerne in den KI-Beschleunigerchip

- KI-Chip zielt auf Edge-Geräte mit geringem Stromverbrauch ab

- KI-fähige SoCs verarbeiten mehrere Videostreams

- Integrieren von Sicherheit in einen KI-SoC mithilfe von CPU-Funktionen mit Erweiterungen

- Mikrocontroller-Architekturen entwickeln sich für KI

Für mehr Embedded, abonnieren Sie den wöchentlichen E-Mail-Newsletter von Embedded.

Eingebettet

- Ein Leitfaden für Cloud Computing unter Linux

- 10 Vorteile von Cloud Computing im Jahr 2020

- Cloud Computing vs. On-Premise

- Ereignisflaggengruppen:Einführung und grundlegende Dienste

- Plädoyer für neuromorphe Chips für KI-Computing

- Kontron:neuer Embedded Computing Standard COM HPC

- Kostengünstige Entwicklungskits beschleunigen die LoRaWAN-Entwicklung

- Entwicklungskit vereinfacht BLE-Mesh-Networking

- Entwicklungskits verwenden 1 x 1-mm-Bildsensor

- C# - Ereignisse