KI-Chip verarbeitet gleichzeitige Arbeitslasten

Das Unternehmen wird Entwicklern auch seine KI-Modelle für autonome Fahrzeuge zur Verfügung stellen.

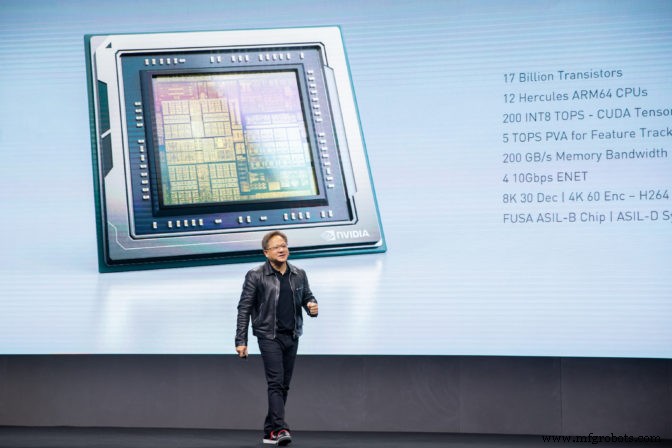

Auf der GPU Technology Conference (GTC) des Unternehmens in Suzhou, China, betrat der CEO von Nvidia Jensen Huang die Bühne, um Drive AGX Orin vorzustellen, den SoC der nächsten Generation im Automobilportfolio des Unternehmens.

Orin folgt auf Drive AGX Xavier, das vor knapp 2 Jahren auf der CES 2018 vorgestellt wurde. Xavier ist Nvidias aktuelles Flaggschiff-SoC für die KI-Beschleunigung in Fahrzeugen.

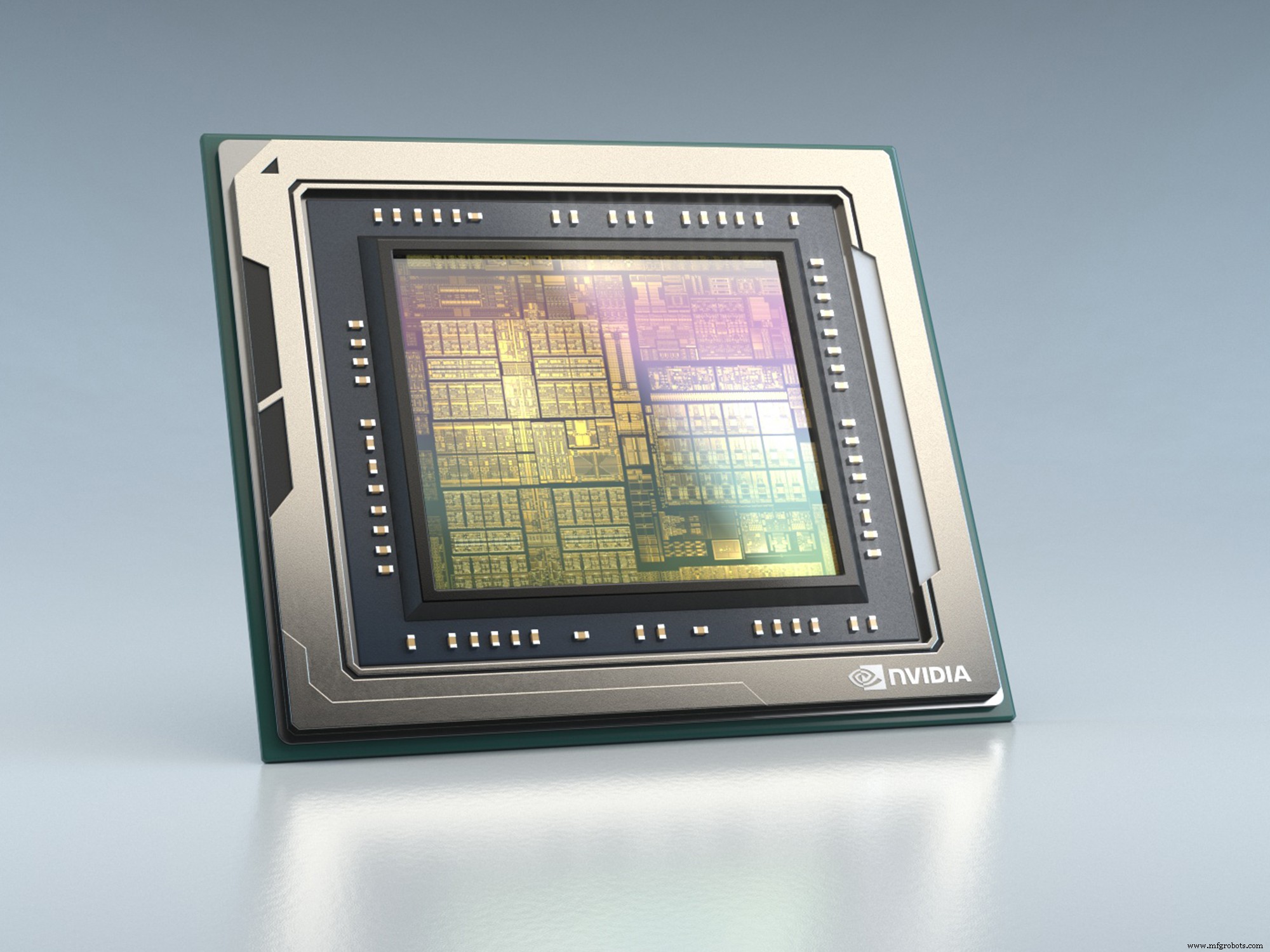

Orin ist mit 17 Milliarden Transistoren fast doppelt so groß wie Xavier mit 9 Milliarden und bietet fast die 7-fache Leistung (200 TOPS für INT8-Daten). Trotz seiner Größe bietet Orin auch die dreifache Energieeffizienz von Xavier, so das Unternehmen.

„[Dies ist] eine enorme Steigerung [in der Leistung], aber es geht nicht nur um die TOPS, es geht darum, dass die Architektur für sehr komplexe Workloads ausgelegt ist, sehr unterschiedliche und redundante Algorithmen, die in einem autonomen Fahrzeug ausgeführt werden müssen heute von Xavier und in Zukunft von Orin gehandhabt“, sagte Danny Shapiro, Senior Director Automotive bei Nvidia.

Jensen Huang, CEO von Nvidia, präsentiert Orin dem Publikum auf der GPU-Technologiekonferenz des Unternehmens in China (Bild:Nvidia)

Orin wird 12 Hercules ARM64-CPUs zusammen mit Nvidia-GPU-Kernen der nächsten Generation und neuen Deep-Learning- und Computer-Vision-Beschleunigern verwenden, die das Unternehmen nicht bekannt gab.

Es wird in autonomen Fahrzeugen (über Designs von Level 2 bis Level 5) und in der Robotik eingesetzt, wo viele neuronale Netze und andere Anwendungen gleichzeitig laufen müssen, während die Sicherheitsstufen ISO 26262 ASIL-D erreicht werden. Durch die Nutzung der Nvidia Drive-Plattform wird Orin softwarekompatibel mit Xavier.

Die Orin-Familie wird eine Reihe von Konfigurationen umfassen, die auf einer einzigen Architektur basieren und 2022 für Kundenproduktionsläufe verfügbar sein werden.

Föderiertes Lernen

Nvidia hat außerdem eine Partnerschaft mit Didi angekündigt. Didi ist ein App-basierter Transportanbieter (ähnlich Uber), der in Asien, Lateinamerika und Australien aktiv ist.

Didi wird in seinem Rechenzentrum Nvidia-GPUs zum Trainieren von Algorithmen für maschinelles Lernen und die Nvidia Drive-Plattform für Inferenz in seinen autonomen Fahrzeugen der Stufe 4 verwenden. Das Unternehmen hat seinen Geschäftsbereich Autonomes Fahren im August in eine eigene Gesellschaft ausgegliedert. Außerdem werden virtuelle GPU-Cloud-Dienste für Kunden eingeführt, die auf Nvidia-GPUs basieren.

In einer separaten Ankündigung gab Nvidia bekannt, dass es vortrainierte Modelle für die tiefen neuronalen Netze (DNNs), die es für Nvidia Drive entwickelt hat, für Entwickler autonomer Fahrzeuge frei zur Verfügung stellen wird. Dazu gehören Modelle zur Detektion von Ampeln und Schildern sowie anderen Objekten wie Fahrzeugen, Fußgängern und Fahrrädern. Dazu gehören auch Pfadwahrnehmung, Blickerkennung und Gestenerkennungsalgorithmen.

Orin bietet 200 TOPS, die 7-fache Leistung von Xavier bei 3-facher Energieeffizienz (Bild:Nvidia)

Wichtig ist, dass diese Modelle mithilfe der vom Unternehmen bereitgestellten Tools angepasst und mithilfe von föderiertem Lernen aktualisiert werden können. Federated Learning ist eine Technik, bei der das Training lokal am Edge durchgeführt wird, um den Datenschutz zu wahren, bevor ein zentrales Modell mit Trainingsergebnissen aus mehreren Quellen aktualisiert wird.

„Das autonome KI-Fahrzeug ist ein softwaredefiniertes Fahrzeug, das für den weltweiten Betrieb mit einer Vielzahl von Datensätzen erforderlich ist“, sagte Jensen Huang, CEO von Nvidia. „Indem wir AV-Entwicklern Zugriff auf unsere DNNs und die fortschrittlichen Lerntools bieten, um sie für mehrere Datensätze zu optimieren, ermöglichen wir ein gemeinsames Lernen über Unternehmen und Länder hinweg, während wir das Eigentum an Daten und den Datenschutz wahren. Letztendlich beschleunigen wir die Realität globaler autonomer Fahrzeuge.“

Eingebettet

- Entwerfen mit Bluetooth Mesh:Chip oder Modul?

- Kleines Bluetooth 5.0-Modul integriert Chipantenne

- Forscher bauen winzige Authentifizierungs-ID-Tags

- Spezialisierte Prozessoren beschleunigen Endpoint-KI-Workloads

- Debüts des bildgebenden Radarprozessors für die Automobilindustrie mit 30 fps

- Low-Power-Radarchip verwendet neuronale Spiking-Netzwerke

- Referenzdesign unterstützt speicherintensive KI-Workloads

- Miniatur-Lunge-Herz-Sensor auf einem Chip

- Was sind Späneförderer?

- Eine Einführung in Späneförderer