Testen von 800G Direct Modulated Optical Signaling

Optische Kommunikationssysteme waren ein Schlüsselfaktor für den Ausbau unserer Informationsinfrastruktur. Viele Rechenzentren, die zum Speichern und Übertragen von Informationen verwendet werden, verfügen über kilometerlange Glasfasern und Tausende von Laser-/Fotodetektorempfängern, um Informationen über die Glasfaser zu senden und zu empfangen. Es gibt einen unerbittlichen kommerziellen Druck, die Kapazität zu erhöhen, und der Prozess zur Entwicklung neuer Systeme, die mit höheren Datenraten arbeiten, geht weiter. Dabei geht es nicht einfach darum, Systeme zu entwerfen, die mehr Informationen übertragen. Die Kosten dieser Systeme müssen sinken. Rechenzentren werden manchmal in Hektar und Megawatt angegeben, was darauf hinweist, dass die zum Betrieb des Rechenzentrums erforderliche Energie enorm ist. Es gibt eine starke Motivation, Wege zu finden, nicht nur mit höheren Kapazitäten zu arbeiten, sondern dies auch bei geringerem Energieverbrauch zu tun.

Das grundlegende optische Kommunikationssystem hat einen Lasersender, der elektrische Daten in moduliertes Licht umwandelt, eine optische Faser und einen Photodiodenempfänger, um das modulierte Licht zurück in ein elektrisches Signal umzuwandeln. Das Entwerfen des optischen Kommunikationssystems wird durch die Tatsache erschwert, dass es in der Rechenzentrumsumgebung selten erforderlich ist, dass die optische Verbindung von einem einzigen Anbieter hergestellt wird. Der Sender, die Faser und der Empfänger werden wahrscheinlich von drei verschiedenen Unternehmen hergestellt. Dieses Konzept, das als Interoperabilität bekannt ist, gibt dem Entwickler von Rechenzentren Flexibilität und erleichtert den Wettbewerb zwischen den Anbietern, was zu mehr Innovation und niedrigeren Kosten führt. Der Nachteil dabei ist, dass das Entwerfen des Systems und das Spezifizieren der Komponenten innerhalb dieses Systems komplexer wird.

Eine Normungsorganisation wie IEEE 802.3 bietet ein öffentliches Forum zum Definieren von Kommunikationssystemen. Die Treffen stehen allen offen und werden von Rechenzentrumsdesignern sowie Herstellern von Netzwerkausrüstung, Transceivern und Glasfasern besucht. Da die Norm die Leistung und deren Verifizierung definiert, beteiligen sich auch Prüf- und Messunternehmen. Eines der wesentlichen Ergebnisse der Normengruppe ist ein Satz von Spezifikationen für die Sender und ein Satz von Spezifikationen für die Empfänger. Auch hier existieren die beiden Sätze, um die Interoperabilität zu fördern. Kürzlich hat die IEEE 802.3cu-Arbeitsgruppe das Entwurfsdokument für 100 Gbit/s pro Wellenlänge veröffentlicht, das die Schlüsselspezifikation für zukünftige glasfaserbasierte Verbindungen sein wird.

Die Spezifikationen beginnen normalerweise mit dem Empfänger, wo die Grenzen der Signalstärke bestimmen, wie zuverlässig ein Fotodetektor das optische Signal in elektrische Daten umwandeln kann. Wenn der Signalpegel unter eine empfohlene Empfindlichkeit fällt, macht der Empfänger zu viele Fehler, die typischerweise als Bitfehler angesehen werden. Dieser Schwellenwert wird als Empfindlichkeitsgrenze des Empfängers bezeichnet.

Normalerweise gibt es ein Ziel für die Entfernung, die das Signal zurücklegen muss, vielleicht so kurz wie 100 Meter oder so lang wie 40 Kilometer. Die durch die Faser verursachte Dämpfung ist gut bekannt, so dass die Rückwärtsbewegung vom Empfänger unter Berücksichtigung des erwarteten Verlusts der Faser dann den minimalen Signalleistungspegel definiert, den ein Sender erzeugen muss. In Wirklichkeit ist es komplizierter, da es eine Vielzahl von Mechanismen gibt, die dazu führen können, dass ein System Bitfehler generiert, die über einen einfachen Leistungsabfall unter die Empfindlichkeitsgrenze des Empfängers hinausgehen.

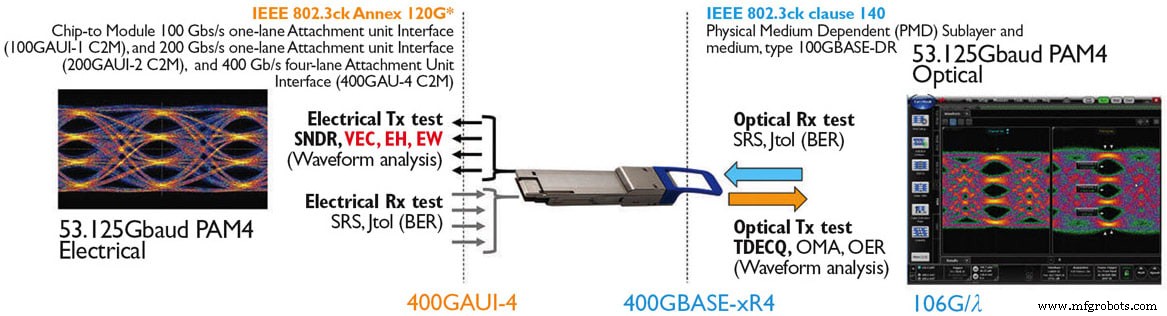

Aus der Perspektive eines Empfängers können zwei Laser, die mit demselben Leistungspegel arbeiten, sehr unterschiedliche Signale erzeugen. Moderne Systeme arbeiten heute mit über 50 GBaud (PAM4). Das heißt, das Licht muss am Sender mit einer Rate von bis zu 50 Milliarden Mal pro Sekunde ein- und ausgeschaltet werden. Der Empfänger muss erkennen, ob das Licht ein- oder ausgeschaltet ist, und ein Sender mit geringerer Qualität kann langsam sein. Der Laser kann ein Signal erzeugen, das nicht stabil ist, wenn der Empfänger eine Entscheidung trifft. Daher muss die Qualität des Lasersignals einem Mindestniveau entsprechen. Ebenso können wir nicht erwarten, perfekte Sender zu haben, daher müssen Empfänger eine gewisse Toleranz für nicht ideale Eingangssignale haben. Daraus ergeben sich einige wichtige Anforderungen an Sender und Empfänger:

Optische Senderauswertung

-

Optische Modulationsamplitude (OMA):Die Differenz zwischen den Senderlogikpegeln.

-

Relatives Intensitätsrauschen (RIN):Ein Maß für die Menge an Rauschen, die ein Sender erzeugt.

-

Senderstreuung und Augenschluss:TDEC oder TDECQ (für PAM4-Modulation) ist ein statistisches Maß der Signalqualität, das die Wahrscheinlichkeit angibt, dass das Signal Fehler im Empfänger erzeugt (Abbildung 1).

-

Overshoot/Undershoot:Neue Metriken, die kürzlich in IEEE 802.3cu definiert wurden, um Empfänger vor starken Transienten des Eingangssignals zu schützen.

Beeinträchtigte Signale des optischen Empfängers

Stressed Receiver Sensitivity (SRS):Das Bitfehlerverhältnis oder das erwartete Frame-Loss-Verhältnis unter dem erwarteten Pegel, wenn das in den Empfänger eingehende Signal das im schlimmsten Fall erwartete Signal vom Sender (und Kanal) ist.

Testinstrumente wurden entwickelt, um optische Beeinträchtigungen in Instrumentenqualität (für bestimmte TDECQ-, ER- und OMA-Ziele) für das Testen von Empfängern unter Stress zu bieten. Abbildung 2 zeigt ein typisches optisches SRS-Signal, das zu Testzwecken erzeugt wird.

Sender werden im Allgemeinen mit einem spezialisierten Oszilloskop für digitale Kommunikationsanalysen getestet. Diese Instrumente verfügen über integrierte optische Referenzempfänger und Firmware, um die von diesen Standards geforderten Messungen durchzuführen. In ähnlicher Weise sind für Empfänger SRS-Testsysteme (Abbildung 3), einschließlich eines kalibrierten „beeinträchtigten“ Signals und eines Bit-Error-Ratio-Testers (BERT), verfügbar, um die Standardkonformität zu überprüfen.

Die Verbindungsleistung bei 100 Gbit/s – sei es elektrisch oder optisch – beide arbeiten mit höheren Bitfehlerraten als ihre Gegenstücke mit 25 oder 50 Gbit/s mit geringerer Geschwindigkeit. Aktuelle 100-Gbit/s-Schnittstellen arbeiten mit nativen Verbindungsfehlerraten von bis zu 2E-4 BER und verlassen sich auf moderne Reed-Solomon-Forward-Error-Correction-Techniken (RS-FEC), um zufällige und isolierte Bitfehler zu korrigieren, die natürlicherweise bei der Übertragung auftreten.

Die Vorwärtsfehlercodierung ist ein Prozess, der mit Daten auf der Physical Coding Sublayer (PCS) beginnt, bevor die Daten in das Physical Media Attachment (PMA) übergehen. Diese PCS/PMA-Schnittstelle verwaltet Datenfehlercodierung, Verschachtelung, Verwürfelung und Ausrichtungsbeiträge. Dieses PCS/PMA-Codiersystem stellt die Fehlerratenanalyse vor Herausforderungen, da der Prozess des Beobachtens der physikalischen Bitfehler erzeugenden Grundursache nun durch eine beträchtliche Menge digitaler Fehlerkorrektur- und Verschachtelungsschaltungen verdeckt wird. Der Wunsch, die physikalischen Fehler in einer optischen Übertragung zu untersuchen, die zu nicht wiederherstellbaren Datenrahmen führt, ist ein komplexer Prozess, den Anbieter von Testinstrumenten heute aktiv vorantreiben. Spezialisierte Tools wie Layer1 BERT und KP4 FEC Multiport-Analysesysteme spielen jetzt eine wesentliche Rolle bei der Empfängertoleranz und allgemeinen FEC-fähigen Debug-Tools (Abbildung 4).

Die PCS/PMA-Lücke, die zwischen einem FEC-korrigierten optischen Signal und seiner tatsächlichen physikalischen Rohübertragung besteht, kann mit dem 400G-FEC-fähigen Empfängertestsystem von Keysight überbrückt werden, das FEC-codierte Datenströme analysiert und ein Oszilloskop anweisen kann, das physikalische Signal zu lokalisieren (auszulösen). optische Schnittstelle an Stellen, an denen Fehler auftreten und bietet Systemdesignern erstmals ein Werkzeug, das die Post-FEC-Fehleranalyse mit der Analyse und Visualisierung der physikalischen Übertragung Seite an Seite verbindet.

Zusammenfassung

Gegenwärtig arbeiten die direkt modulierten Datenkommunikationssysteme mit der höchsten Kapazität mit 400 Gbps. Diese Systeme haben mehrere Spuren von 100 Gbps, entweder mit vier Sendern und vier Fasern oder mit vier Wellenlängensendern und einer einzigen Faser. 800-Gbit/s-Verbindungen der ersten Generation werden 400-Gbit/s-Systeme mit doppelter Skalierung durch Konnektoren mit höherer Dichte wie QSFP-DD- und OSFP-Verbindungen sein. In diesem Szenario mit nur mehr Lanes von 100 Gbit/s, die auf 800 Gbit/s aggregiert werden, bleiben die Spezifikationen und Testmethoden ähnlich wie bei 400-Gbit/s-Systemen. Native x4-Spur-breite 800-Gbit / s-Verbindungen hängen von Fortschritten sowohl bei den elektrischen als auch bei den optischen Spezifikationen ab, die derzeit im Gange sind. Diese nächste Geschwindigkeitsklasse mit 800 Gbit/s wird höchstwahrscheinlich sowohl elektrisch als auch optisch auf eine native Geschwindigkeit von 200 Gbit/s pro Spur vorrücken, während gleichzeitig die starken Marktanforderungen zur Reduzierung des Gesamtstromverbrauchs und der Kosten eingehalten werden.

Wenn eine einspurige Übertragung mit 200 Gbit/s erreicht ist, werden die Testmethoden und -techniken von 100 Gbit/s wahrscheinlich stark genutzt werden, aber das 200-Gbit/s-Feld wird wahrscheinlich Fortschritte bei den Modulationsverfahren einsetzen, da der Schwerpunkt auf einer erhöhten Übertragungseffizienz liegt und die Verwaltung bekannter Bandbreitenengpässe wichtige Druckpunkte sind diese Branche. Die Messpartner von Keysight leisten einen wesentlichen Beitrag zu diesen hochmodernen Standardbemühungen, um sicherzustellen, dass effektive Testlösungen weiterhin verfügbar sind, wenn sich diese Technologien auf 800 Gbit/s und 1,6 Tbit/s für Rechenzentrumsarchitekturen der nächsten Generation weiterentwickeln.

Dieser Artikel wurde verfasst von Greg D. Le Cheminant, Spezialist für Messanwendungen, Digital Communications Analysis, Internet Infrastructure Solutions; und John Calvin, Strategischer Planer und Datacom Technology Lead, IP Wireline Solutions; Keysight Technologies (Santa Rosa, CA). Weitere Informationen finden Sie unter hier .

Sensor

- Was ist ein Radarsensor:Funktionsweise und Anwendungen

- Signalintegrität &PCB

- Testen von Sensoren im Nebel, um zukünftige Transporte sicherer zu machen

- Optischer Biosensor erkennt Toxine

- Ein einzigartiger Verstärker könnte die optische Kommunikation verändern

- Spektroskopie mit einem optischen Mikroskop

- Atombasierte Funkkommunikation

- Gemultiplexte optische Antennen

- Radharter CMOS-Kristalloszillator

- Fragen und Antworten:Plattform konvertiert Kopfhörer von Dumb zu Smart