Time-of-Flight-Technologie verspricht verbesserte Genauigkeit

Analog Devices (ADI) und Microsoft haben sich zusammengetan, um Time-of-Flight (ToF) 3D-Bildgebungslösungen mit dem Ziel zu entwickeln, unabhängig von den Szenenbedingungen eine höhere Genauigkeit zu bieten. ADI wird die Azure Kinect 3D ToF-Technologie von Microsoft nutzen und sein technisches IC- und System-Know-how einbringen, um Lösungen zu entwickeln, die einfacher zu übernehmen sind. Ziel ist es, ein breites Publikum in Branchen wie Industrie 4.0, Automotive, Gaming, Augmented Reality sowie Computational Photography and Videography zu erreichen.

Branchenanalysten schätzen ein starkes Wachstum für 3D-Bildgebungssysteme, die in anspruchsvollen Umgebungen eingesetzt werden und in denen hochmoderne Anwendungen wie menschliche Kollaborationsroboter, Raumkartierung und Bestandsverwaltungssysteme erforderlich sind, um Industrie 4.0 zum Leben zu erwecken. ToF-Anwendungen werden auch benötigt, um sicherere Fahrumgebungen im Automobilbereich mit Belegungserkennungs- und Fahrerüberwachungsfunktionen zu schaffen.

In einem Interview mit der EE Times haben Tony Zarola, Senior Director of Enhanced Imaging and Interpretation, und Carlos Calvo, Strategic Marketing Manager bei Analog Devices, die Grundlagen dieser Zusammenarbeit hervorgehoben . Zarola sagte:“ Microsoft hat sich bei allen Bildsensorherstellern zum Maßstab für die 3D-ToF-Leistung entwickelt und stellt ADI die Kernpixeltechnologie zur Verfügung, die die Grundlage der von ADI entwickelten Sensoren und Lösungen bildet. Über Jahrzehnte haben sie das Know-how entwickelt, das für die beste Datenerfassung und revolutionäre Algorithmen erforderlich ist, die sie am Intelligent Edge oder in der Intelligent Cloud ausführen. Wir freuen uns darauf, die besten Fähigkeiten von Microsoft und ADI in den Bereichen Silizium, Systeme, Software und Optik zu kombinieren.“

3D-ToF-Design

Die Erkennung von Gesten ist die Fähigkeit eines Geräts, eine Reihe von Bewegungen des menschlichen Körpers zu erkennen. Die elektronische Technologie basiert auf der Hilfe einer Kamera und eines ICs zum Identifizieren und Scannen der Szene in einem 2D- oder 3D-Profil. Die Time-of-Flight-Technik besteht darin, einen Laserstrahl zum Ziel zu senden und die Reflexion des Signals zu analysieren.

3D-Flugzeit oder 3D-ToF ist eine Art von LIDAR (Light Detection and Ranging) ohne Scanner, die optische Hochleistungspulse in Nanosekunden verwendet, um Tiefeninformationen (normalerweise über kurze Distanzen) von einer Szene zu erfassen. Die verschiedenen IC-Lösungen erstellen mit Hilfe von Softwarealgorithmen zur Gestenerkennung eine Tiefenkarte der empfangenen Bilder und reagieren in Echtzeit auf Körperbewegungen. Der Hauptvorteil der Gestenerkennungstechnologie besteht darin, dass kein physischer Kontakt zwischen der Person und dem Steuerungssystem erforderlich ist.

Eine ToF-Kamera misst die Entfernung, indem sie ein Objekt durch moduliertes Laserlicht und einen laserwellenlängenempfindlichen Sensor beleuchtet, um reflektiertes Licht zu erfassen. Der Sensor misst die Zeitverzögerung zwischen dem Moment, in dem das Licht ausgesendet wird, und dem Moment, in dem das reflektierte Licht von der Kamera empfangen wird. Es gibt verschiedene Methoden zur Messung der Zeitverzögerung, von denen zwei sich durchgesetzt haben:das Dauerstrichverfahren (CW) und das Pulsverfahren. Die überwiegende Mehrheit der ToF-Sensoren sind CW-Sensoren und verwenden CMOS-Sensoren.

Es gibt viele Störfaktoren, die die Messung der Laufzeit (ToF) erschweren:störendes Umgebungslicht, Mehrwegeeffekte, die durch Lichtreflexionen von Objekten in der Szene verursacht werden, die die wahre Entfernung verfälschen, Temperatureffekte, Mehrdeutigkeit der Reichweite. „Die Herausforderungen reichen von der Siliziumentwicklung bis hin zur Erstellung eines vollständigen Systems, das in Übereinstimmung mit der theoretischen Summe der Teile funktioniert“, sagte Calvo. „Es ist unmöglich, jede Komponente isoliert zu betrachten. Beispielsweise hat eine ToF-Kamera mit dem besten Sensor, die jedoch mit einem nicht optimierten Objektiv ausgestattet ist, eine schlechte Gesamtsystemleistung.“

„An der Oberfläche haben ToF-Kameras Ähnlichkeiten mit RGB-Kameras. Ein wesentlicher Unterschied besteht darin, dass die Bildqualität der RGB-Kamera je nach Anwendung subjektiv beurteilt wird; andere Anwendungen werden nur durch erweiterte Nachbearbeitung aktiviert. Eine ToF-Kamera misst eine objektive physikalische Größe (Entfernung), auf die sich ein Benutzer je nach Anwendung stark auf die Genauigkeit des Bildes verlassen kann. Einige optische Unvollkommenheiten in RGB-Kameras wie Linsenreflexionen können Artefakte erzeugen, die manchmal als künstlerisch angesehen werden (z. B. Sonnenlichtreflexion). In einem ToF-System kann Lens Flare, wenn es nicht drastisch minimiert wird, die Leistung des gesamten Systems bei starken Reflexionen von Objekten lahmlegen, fügte Calvo hinzu.“

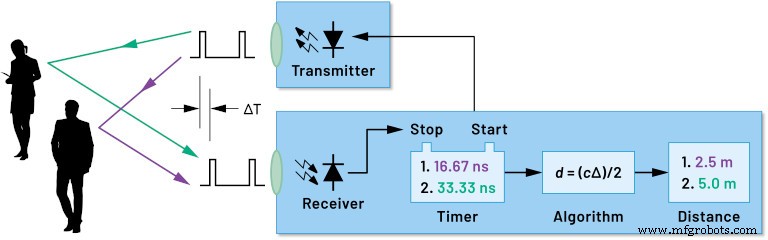

Der für die Laufzeit verwendete CMOS-Sensor besteht aus einem Sender und einem Empfänger; es ermöglicht Berechnungen der Entfernung von Objekten auf Einzelpixel-Ebene mit einer Leistung von fast 160 fps.

„Auf Siliziumebene muss man die Schlüsselelemente der Signalkette berücksichtigen:den Lasertreiber, den ToF-Bildsensor mit integrierter Auslesung und schließlich die Depth Compute Engine. Die Herausforderung beginnt mit dem Design eines Pixels mit hoher Empfindlichkeit und hohem Modulationskontrast im Bildsensor selbst und endet mit der Bildung einer 3D-Punktewolke, die von der nächsten Anwendungsschicht interpretiert werden kann.

„Abgesehen von den Komponenten ergeben sich die wichtigsten Herausforderungen aus dem Design und der Produktion einer Tiefenkamera, da das optomechanische Design, die Kalibrierung, das elektrische Design und die Softwareimplementierung zeitaufwändig und herausfordernd sind. Analog Devices (ADI) nimmt diese Herausforderungen für unsere Kunden an, um ihren Designprozess zu vereinfachen“, sagte Calvo.

Abbildung 1. ToF-Blockdiagramm. (Quelle:ADI)

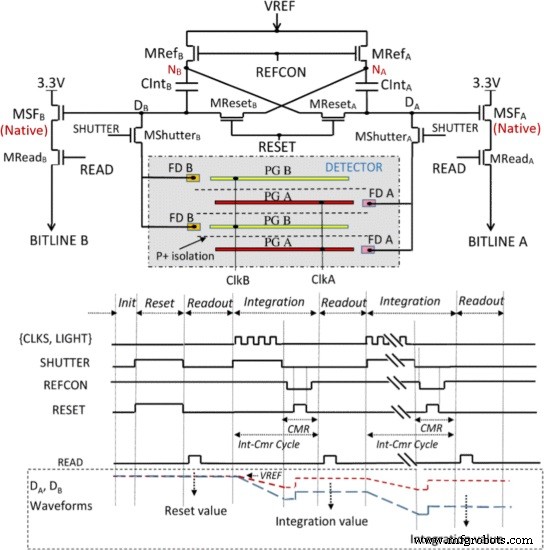

Die Pixel sammeln Licht von unterschiedlichen Teilen der Szene, und ihre Rekombination bildet das rekonstruierte Bild. Alle Sensorpixel werden durch eine Korrelation zwischen Demodulations- und Modulationsblöcken gesteuert. Jedes Pixel kann durch das in Abbildung 2 gezeigte Modell angenähert werden.

Der Strom wird während der Integrationszeit durch Aktivieren der entsprechenden Steuersignale zum Node-A (Da) oder Node-B (Db) geleitet. Das Lesen erfolgt bei gestoppter Demodulation, damit das System die gesamte Bitfolge lesen kann. ClkA und ClkB werden für die Zeit tInt1 bei der ausgewählten Modulationsfrequenz um 180 Grad phasenverschoben moduliert. Die Phase des empfangenen Lichts bezüglich des ClkA- und CLkB-Takts bestimmt die DA- und DB-Signale. Am Ende der Integration werden ClkA &ClkB abgeschaltet und die Lesephase erfolgt durch Abtasten des integrierten Signals (BitlineAInt1-BitlineBInt1).

Die Umwandlung von Photonen in elektrischen Strom wird durch einen Quantenprozess mit Poisson-Verteilung gesteuert. Der Parameter, der uns eine Vorstellung von der Güte des Systems gibt, ist die Quanteneffizienz, also das Verhältnis zwischen der Anzahl der erzeugten Elektronen und der Zahl der Photonen, die die entsprechenden Pixel aktivieren. Die Anzahl der Elektronen hängt sowohl vom tatsächlich modulierten Licht als auch vom Umgebungslicht ab, das dem Rauscheffekt entspricht. Ein zu wählender Parameter beim Entwurf eines Time-of-Flight-Systems ist FoV (Field of View). FoV muss entsprechend den Abdeckungsanforderungen der Szene entsprechend ausgewählt werden.

Abbildung 2. Elektrische Schaltung und Timing für ein Pixel. (Quelle:https://ieeexplore.ieee.org/document/6964815 )

Um eine hohe Effizienz bei hohen Frequenzen zu erreichen, kann der Chip unter Verwendung eines 0,13 μm Mixed-Signal-CMOS-Prozesses mit geringem Stromverbrauch mit geringfügigen Modifikationen hergestellt werden, um einen effizienten Flugzeitbetrieb zu unterstützen.

ADI und Microsoft

Die Zusammenarbeit zwischen Microsoft und ADI zielt darauf ab, die ToF-Technologie zu verbessern:ADI entwickelt eine neue Serie von ToF-3D-Bildsensoren, die eine Genauigkeit von weniger als einem Millimeter bieten und mit dem Redmond-Riesen-Ökosystem basierend auf der Microsoft-Tiefe Intelligent Cloud . kompatibel sind und Intelligent Edge-Plattformen.

„Wir sind fest davon überzeugt, dass sich diese Zusammenarbeit auf alle wichtigen Branchen auswirken wird – Konsumgüter, Industrie, Gesundheitswesen und Automobil. Bisher war die von Microsoft entwickelte Technologie für skalierte kommerzielle Anwendungen nicht flächendeckend verfügbar. Wir glauben, dass die ADI-Lösungen, die auf der Imager-Technologie von Microsoft basieren, auf ganzer Linie bahnbrechend sein werden“, sagte Zarola.

Es gibt offensichtliche Anwendungen von Sicherheitssystemen für eine verbesserte Gesichtserkennung sowie fortschrittliche Sicherheitsmaßnahmen für eine effizientere Fabrikautomatisierung. Industrie 4.0 wird mit kollaborativen Robotern, die sicher neben dem Menschen arbeiten, ohne in einem „No-Human“-Bereich eingezäunt zu sein, transformiert und eine weitere Optimierung der Logistik wird durch die ToF-Genauigkeit für die Karton- und Palettendimensionierung ermöglicht.

Zarola fügte hinzu:„Eine ausgefeiltere Belegungserkennung wird zu verbesserter Energieeffizienz, Sicherheitssystemen und Mensch-Maschine-Interaktionen führen. Vom Zuhause bis zum Auto wird unsere ToF-Zusammenarbeit mit Microsoft neuen Spielerlebnissen die Möglichkeit geben, virtuelle Objekte in der realen Welt zu platzieren und mit ihnen zu interagieren, die Art und Weise, wie wir mit unseren Autos interagieren, zu verändern und die Sicherheit durch die Überwachung des Fahrers und der Passagiere gleichermaßen zu erhöhen. Die potenziellen Anwendungsfälle für die ToF-Technologie sind breit gefächert und entwickeln sich weiter, sodass erwartet wird, dass die Hauptanwendungen von heute morgen durch neue Ideen ersetzt werden.“

Zarola und Calvo haben erklärt, wie ihre Kunden Millimetertiefenauflösung und feine räumliche Auflösung über einen weiten Temperaturbereich wünschen. Um diese Art von Leistung zu erreichen, ist ein extremes Maß an Zeitsynchronisation erforderlich, das sowohl auf Hardware- als auch auf Softwareebene erreicht wird. „Eine Fehlausrichtung von 10 ps zwischen den Signalen, die den Laser steuern, und den Pixeln im Sensor führt zu einem Fehler von 1,5 mm bei der endgültigen Entfernungsschätzung. Als ob das nicht schon schwierig genug wäre, kommt noch die Notwendigkeit hinzu, ein Time-of-Flight-System über einen weiten Temperaturbereich genau zu halten, was fortschrittliche Verarbeitungs- und Kalibrierungsalgorithmen erfordert, die gemeinsam entwickelt werden müssen“, sagte Calvo.

Ein besonderer Kritikpunkt an ToF-Systemen ist die Modulationsfrequenz, bei der sie arbeiten können und wo ADI am stärksten konzentriert ist. Die meisten Quellen von Tiefenschätzungsfehlern neigen dazu, durch die Modulationsfrequenz „geteilt“ zu werden. „Unser Ziel ist es, die durchschnittliche Modulationsfrequenz eines ToF-Systems zu erhöhen, um Messungen mit geringerem Tiefenrauschen zu ermöglichen und die nachteiligen Auswirkungen von Mehrwege- oder Umgebungslicht-Schrotrauschen zu reduzieren“, sagte Zarola.

Zarola fügte hinzu:„ADI möchte auch wichtige Herausforderungen lösen, die das Design und die Produktion von Tiefenkameras zeitaufwändig und schwierig machen. Wir übernehmen die mechanische Ausrichtung, das optische Design, die Kalibrierung, das elektrische Design und die Softwareimplementierung zusammen mit den traditionellen Hindernissen bei der Bilderfassung.“

Die Kombination der Time-of-Flight (ToF) 3D-Technologie von Microsoft, die in HoloLens-Mixed-Reality-Geräten verwendet wird, und des Azure Kinect-Entwicklungskits mit den benutzerdefinierten Lösungen von ADI ermöglicht die Implementierung und Skalierbarkeit der neuen Generation von Hochleistungsanwendungen währenddessen Optimierung der Markteinführungszeit.

>> Dieser Artikel wurde ursprünglich veröffentlicht am unsere Schwesterseite EE Times.

Eingebettet

- ams vereinfacht die Implementierung der optischen 3D-Sensortechnologie

- GNSS-Plattform verbessert die Positionsgenauigkeit

- Verbesserte Technologien beschleunigen die Akzeptanz von Sprachassistenten

- Lichtschranken verlängern die Laufzeit-Erkennungsdistanz

- Automotive-Bildsensoren bieten einen verbesserten Dynamikbereich

- Kleiner 3D-Bildsensor nutzt Time-of-Flight-Technologie

- Luftdrucksensor bietet erhöhte Genauigkeit

- DUAGON-MEN-GROUP integriert OEM Technology Solutions Australia

- Wie Technologie verspricht, die Agrar- und Lebensmittelindustrie zu verändern

- Linearbewegungstechnologie