Laufzeitsystemdesign:Systemübersicht

Dauerstrich-Kameras (CW-Laufzeitkameras (ToF) sind a leistungsstarke Lösung mit hoher Tiefenpräzision für Anwendungen, die hochwertige 3D-Informationen erfordern, aber Entwickler müssen mehrere Faktoren berücksichtigen, um die beste Leistung zu erzielen.

Dies ist der erste Artikel unserer Time-of-Flight (ToF)-Reihe, der einen Überblick über die CMOS-ToF-Kamerasystemtechnologie mit kontinuierlicher Welle (CW) und ihre Vorteile gegenüber herkömmlichen 3D-Bildgebungslösungen für Machine Vision-Anwendungen bietet. In den folgenden Artikeln werden einige der in diesem Artikel vorgestellten Komponenten auf Systemebene eingehender behandelt, einschließlich des Beleuchtungssubsystems, der Optik, der Energieverwaltung und der Tiefenverarbeitung.

Einleitung

Viele Bildverarbeitungsanwendungen erfordern jetzt hochauflösende 3D-Tiefenbilder, um die standardmäßige 2D-Bildgebung zu ersetzen oder zu erweitern. Diese Lösungen verlassen sich darauf, dass die 3D-Kamera zuverlässige Tiefeninformationen liefert, um die Sicherheit zu gewährleisten, insbesondere wenn Maschinen in unmittelbarer Nähe von Menschen arbeiten. Die Kameras müssen auch in schwierigen Umgebungen, wie in großen Räumen mit stark reflektierenden Oberflächen und in Gegenwart anderer sich bewegender Objekte, zuverlässige Tiefeninformationen liefern.

Bei vielen Produkten wurden bisher Entfernungsmesser-Lösungen mit niedriger Auflösung verwendet, um Tiefeninformationen zur Verbesserung der 2D-Bildgebung bereitzustellen. Dieser Ansatz hat jedoch viele Einschränkungen. Für Anwendungen, die von 3D-Tiefeninformationen mit höherer Auflösung profitieren, bieten CW CMOS ToF-Kameras die leistungsstärksten Lösungen auf dem Markt. Einige der Systemfunktionen, die durch die hochauflösende CW-ToF-Sensortechnologie ermöglicht werden, werden in Tabelle 1 ausführlicher beschrieben. Diese Systemfunktionen lassen sich auch auf Verbraucheranwendungsfälle wie Video-Bokeh, Gesichtsauthentifizierung und Messanwendungen sowie auf Automobilanwendungsfälle wie z B. die Aufmerksamkeitsüberwachung des Fahrers und die automatische Konfiguration in der Kabine.

Tabelle 1. Funktionen des Dauerwellen-Flugzeitsystems

Systemfunktion Enabler Tiefenpräzision und Genauigkeit• Modulationsfrequenz• Modulationsschemata und TiefenverarbeitungDynamischer Bereich• Ausleserauschen

• Rohbildrate Benutzerfreundlich• Kalibrierungsverfahren

• Temperaturkompensation

• Überwachung der Augensicherheit Betrieb im Freien• Empfindlichkeit bei 940 nm

• Beleuchtungsstärke und -effizienz2D/3D-Fusion• Pixelgröße

• Tiefen- und 2D-IR-BilderMehrsystembetrieb• In-Pixel-Unterdrückung von Störlicht

• Kamerasynchronisation

Continuous Wave CMOS Time of Flight Kameraübersicht

Eine Tiefenkamera ist eine Kamera, bei der jedes Pixel die Entfernung zwischen der Kamera und der Szene ausgibt. Eine Technik zum Messen der Tiefe besteht darin, die Zeit zu berechnen, die das Licht benötigt, um von einer Lichtquelle an der Kamera zu einer reflektierenden Oberfläche und zurück zur Kamera zu wandern. Diese Reisezeit wird allgemein als Flugzeit (ToF) bezeichnet.

klicken Sie für das Bild in voller Größe

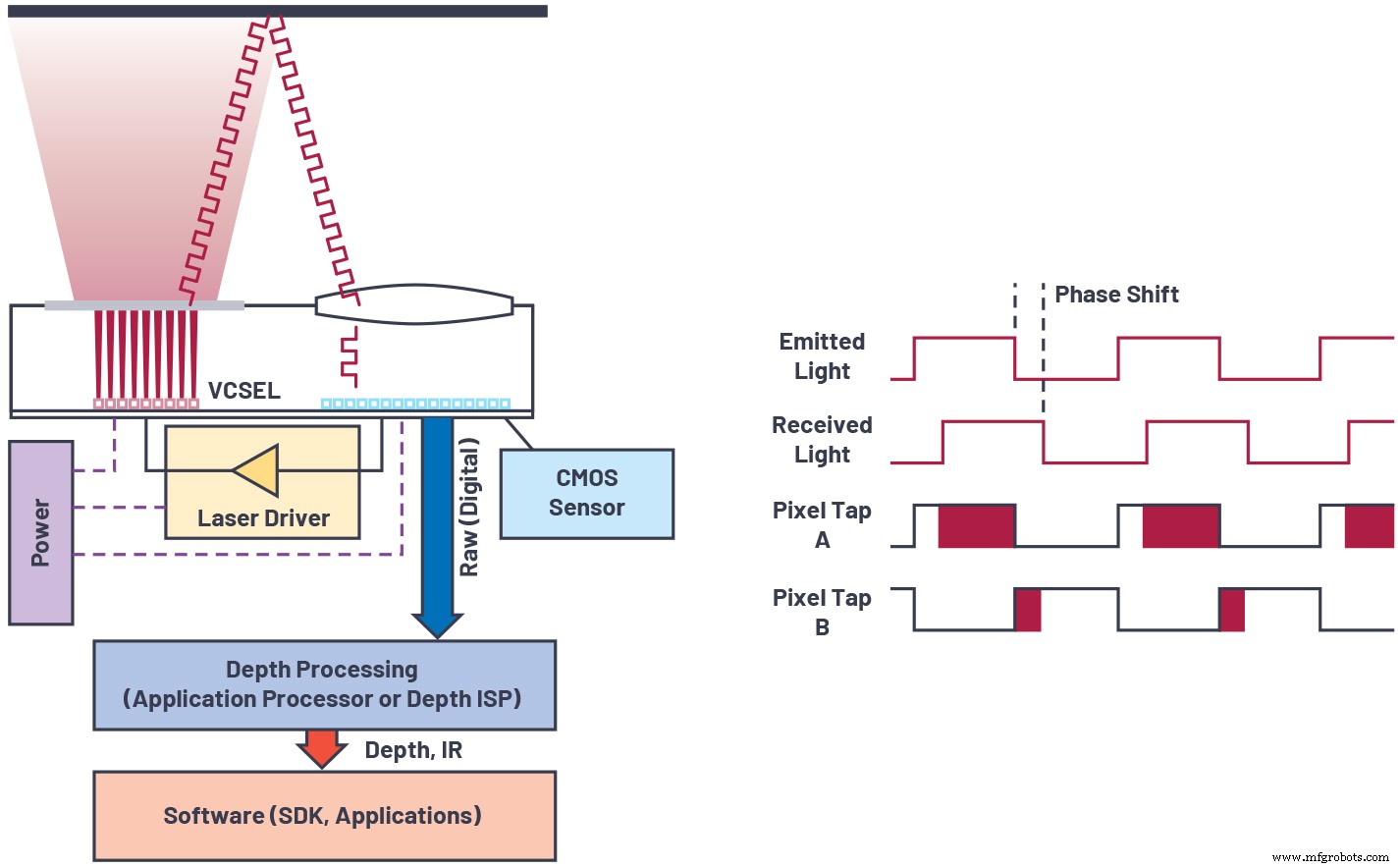

Abbildung 1. Übersicht über die Dauerstrich-Flugzeitsensortechnologie. (Quelle:Analog Devices)

Eine ToF-Kamera besteht aus mehreren Elementen (siehe Abbildung 1), darunter:

- eine Lichtquelle – wie ein oberflächenemittierender Laser mit vertikaler Kavität (VCSEL) oder eine kantenemittierende Laserdiode – die Licht im nahen Infrarotbereich emittiert. Die am häufigsten verwendeten Wellenlängen sind 850 nm und 940 nm. Die Lichtquelle ist normalerweise eine diffuse Lichtquelle (Flutlicht), die einen Lichtstrahl mit einer bestimmten Divergenz (auch bekannt als Beleuchtungsfeld oder FOI) aussendet, um die Szene vor der Kamera zu beleuchten.

- ein Lasertreiber, der die Intensität des von der Lichtquelle emittierten Lichts moduliert.

- ein Sensor mit einem Pixel-Array, der das zurückkehrende Licht von der Szene sammelt und Werte für jedes Pixel ausgibt.

- eine Linse, die das zurückkehrende Licht auf das Sensorarray fokussiert.

- ein Bandpassfilter, der zusammen mit der Linse angeordnet ist und Licht außerhalb einer schmalen Bandbreite um die Wellenlänge der Lichtquelle herausfiltert.

- ein Verarbeitungsalgorithmus, der vom Sensor ausgegebene Rohbilder in Tiefenbilder oder Punktwolken umwandelt.

Man kann mehrere Ansätze verwenden, um das Licht in einer ToF-Kamera zu modulieren. Ein einfacher Ansatz besteht darin, eine kontinuierliche Wellenmodulation zu verwenden, beispielsweise eine Rechteckwellenmodulation mit 50 % Tastverhältnis. In der Praxis ist die Laserwellenform selten eine perfekte Rechteckwelle und kann einer Sinuswelle ähnlicher sein. Eine rechteckige Laserwellenform liefert ein besseres Signal-Rausch-Verhältnis für eine gegebene optische Leistung, führt aber auch Tiefen-Nichtlinearitätsfehler aufgrund des Vorhandenseins hochfrequenter Harmonischer ein.

Eine CW ToF-Kamera misst die Zeitdifferenz td zwischen dem ausgesendeten Signal und dem Rücksignal durch Abschätzen des Phasenversatzes ϕ =2πftd zwischen den Grundlagen dieser beiden Signale. Die Tiefe kann aus dem Phasenversatz (ϕ) und der Lichtgeschwindigkeit (c) abgeschätzt werden mit:

wobei fmod ist die Modulationsfrequenz.

Eine Takterzeugungsschaltung im Sensor steuert die komplementären Pixeltakte, die jeweils die Akkumulation von Photoladungen in den beiden Ladungsspeicherelementen (Tap A und Tap B) sowie das Lasermodulationssignal zum Lasertreiber steuern. Die Phase des zurückkehrenden modulierten Lichts kann relativ zur Phase der Pixeltakte gemessen werden (siehe rechte Seite von Abbildung 1). Die Differenzladung zwischen Tap A und Tap B im Pixel ist proportional zur Intensität des zurückkehrenden modulierten Lichts und zur Phase des zurückkehrenden modulierten Lichts relativ zum Pixeltakt.

Unter Verwendung der Prinzipien der Homodyn-Erkennung wird eine Messung mit mehreren relativen Phasen zwischen Pixeltakt und Lasermodulationssignal durchgeführt. Diese Messungen werden kombiniert, um die Phase der Grundwelle im zurückkehrenden modulierten Lichtsignal zu bestimmen. Wenn Sie diese Phase kennen, können Sie die Zeit berechnen, die das Licht benötigt, um von der Lichtquelle zum beobachteten Objekt und zurück zum Sensorpixel zu wandern.

Vorteile hoher Modulationsfrequenzen

In der Praxis gibt es Nichtidealitäten wie Photonenschussrauschen, Auslesekreisrauschen und Mehrwegestörungen, die Fehler bei der Phasenmessung verursachen können. Eine hohe Modulationsfrequenz reduziert die Auswirkungen dieser Fehler auf die Tiefenschätzung.

Dies ist leicht zu verstehen, wenn man ein einfaches Beispiel nimmt, bei dem ein Phasenfehler vorliegt ϵϕ —d. h. die vom Sensor gemessene Phase ist ϕ =ϕ + ϵϕ . Der Tiefenfehler ist dann:

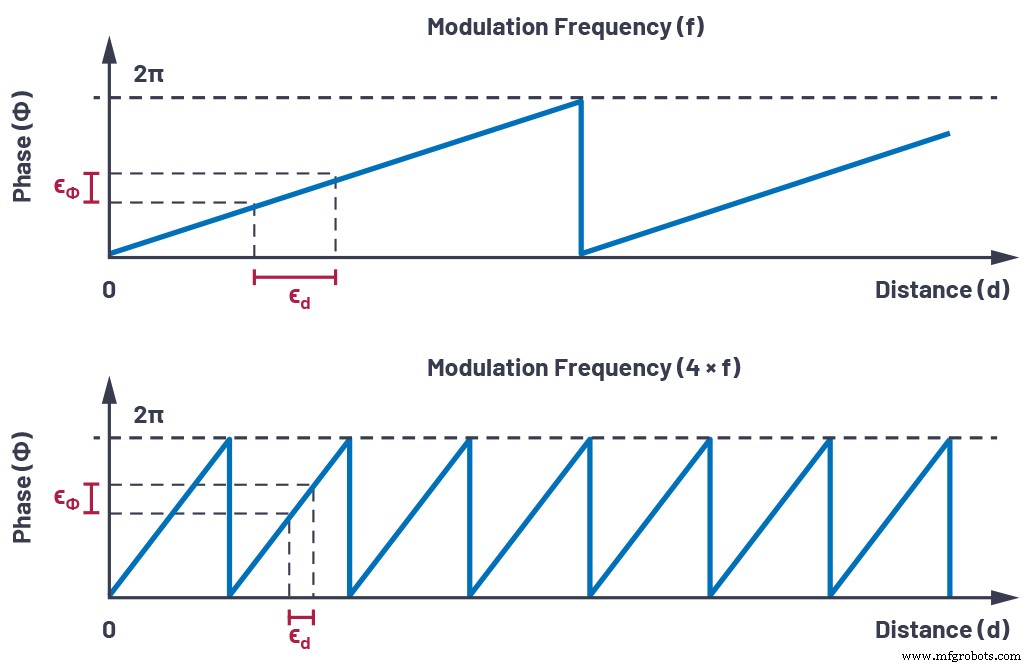

Daher ist der Tiefenfehler umgekehrt proportional zur Modulationsfrequenz, fmod . Dies ist in Abbildung 2 grafisch dargestellt.

klicken Sie für das Bild in voller Größe

Abbildung 2. Die Auswirkung des Phasenfehlers auf die Entfernungsschätzung. (Quelle:Analog Devices)

Diese einfache Formel erklärt zum großen Teil, warum ToF-Kameras mit hoher Modulationsfrequenz ein geringeres Tiefenrauschen und kleinere Tiefenfehler aufweisen als ToF-Kameras mit niedrigerer Modulationsfrequenz.

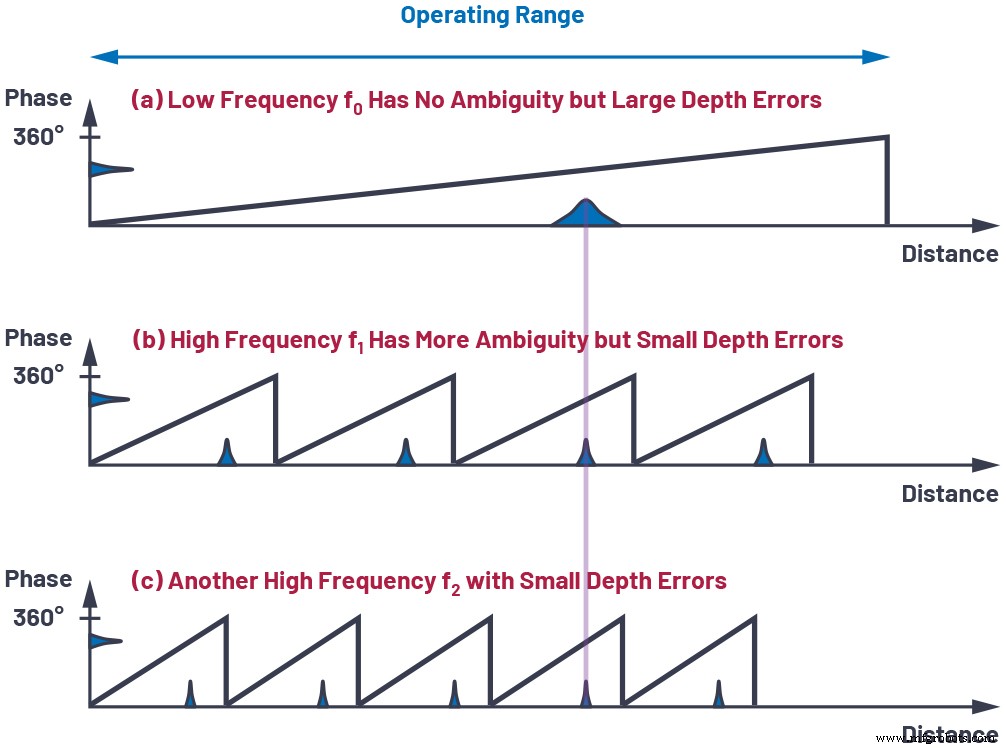

Ein Nachteil der Verwendung einer hohen Modulationsfrequenz besteht darin, dass die Phase schneller umläuft, was bedeutet, dass der Bereich, der eindeutig gemessen werden kann, kürzer ist. Der übliche Weg, diese Einschränkung zu umgehen, besteht darin, mehrere Modulationsfrequenzen zu verwenden, die mit unterschiedlichen Raten umlaufen. Die niedrigste Modulationsfrequenz bietet einen großen Bereich ohne Mehrdeutigkeit, aber größere Tiefenfehler (Rauschen, Mehrwegeinterferenz usw.), während höhere Modulationsfrequenzen gleichzeitig verwendet werden, um Tiefenfehler zu reduzieren. Ein Beispiel für dieses Schema mit drei verschiedenen Modulationsfrequenzen ist in Abbildung 3 gezeigt. Die endgültige Tiefenschätzung wird berechnet, indem die ungewickelten Phasenschätzungen für die verschiedenen Modulationsfrequenzen gewichtet werden, wobei den höheren Modulationsfrequenzen höhere Gewichtungen zugewiesen werden.

Klicken für Bild in voller Größe

Abbildung 3. Mehrfrequenz-Phasen-Unwrapping. (Quelle:Analog Devices)

Wenn die Gewichte für jede Frequenz optimal gewählt werden, ist das Tiefenrauschen umgekehrt proportional zum quadratischen Mittelwert (rms) der im System gewählten Modulationsfrequenzen. Für ein konstantes Tiefenrauschbudget ermöglicht eine Erhöhung der Modulationsfrequenzen eine Reduzierung der Integrationszeit oder der Beleuchtungsleistung.

Andere leistungskritische Aspekte des Systems

Bei der Entwicklung einer Hochleistungs-ToF-Kamera sind zahlreiche Systemfunktionen zu berücksichtigen, von denen einige hier kurz behandelt werden.

Bildsensor

Der Bildsensor ist eine Schlüsselkomponente in einer ToF-Kamera. Die Auswirkungen der meisten Nichtidealitäten der Tiefenschätzung (beispielsweise Bias, Tiefenrauschen und Mehrwegeartefakte) werden reduziert, wenn die durchschnittliche Modulationsfrequenz des Systems ansteigt. Es ist daher wichtig, dass der Sensor einen hohen Demodulationskontrast (die Fähigkeit, Photoelektronen zwischen Tap A und Tap B zu trennen) bei hoher Modulationsfrequenz (Hunderte von MHz) aufweist. Außerdem muss der Sensor eine hohe Quanteneffizienz (QE) im nahen Infrarot (z. B. 850 nm und 940 nm) aufweisen, damit weniger optische Leistung benötigt wird, um Photoelektronen im Pixel zu erzeugen. Schließlich hilft ein niedriges Ausleserauschen beim dynamischen Bereich der Kamera, indem es ermöglicht, schwache Rücksignale (ferne oder Objekte mit geringem Reflexionsvermögen) zu erkennen.

Beleuchtung

Der Lasertreiber moduliert die Lichtquelle (zB VCSEL) mit hoher Modulationsfrequenz. Um die Menge des Nutzsignals am Pixel für eine gegebene optische Leistung zu maximieren, muss die optische Wellenform schnelle Anstiegs- und Abfallzeiten mit sauberen Flanken aufweisen. Die Kombination aus Laser, Lasertreiber und PCB-Layout im Beleuchtungs-Subsystem ist dafür entscheidend. Es ist auch eine gewisse Charakterisierung erforderlich, um die optimalen Einstellungen für optische Leistung und Arbeitszyklus zu finden, um die Amplitude der Grundwelle in der Fourier-Transformation der Modulationswellenform zu maximieren. Schließlich muss die optische Leistung auch auf sichere Weise mit einigen Sicherheitsmechanismen geliefert werden, die auf Lasertreiber- und Systemebene eingebaut sind, um sicherzustellen, dass die Augensicherheitsgrenzen der Klasse 1 jederzeit eingehalten werden.

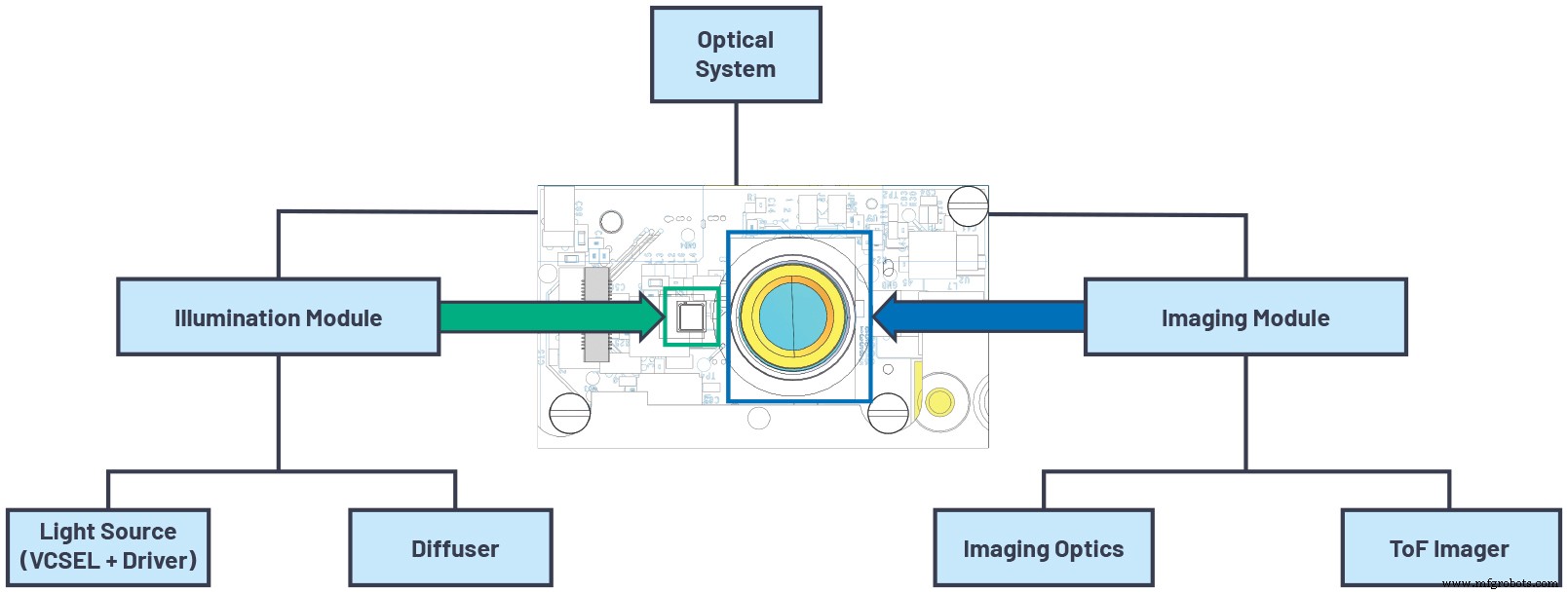

Optik

Die Optik spielt bei ToF-Kameras eine Schlüsselrolle. ToF-Kameras haben bestimmte charakteristische Eigenschaften, die besondere optische Anforderungen erfüllen. Erstens sollte das Beleuchtungsfeld der Lichtquelle für eine optimale Effizienz mit dem Sichtfeld der Linse übereinstimmen. Es ist auch wichtig, dass das Objektiv selbst eine hohe Blendenöffnung (niedrige f/#) für eine bessere Lichtsammeleffizienz hat. Große Blendenöffnungen können zu anderen Kompromissen in Bezug auf Vignettierung, geringe Schärfentiefe und Komplexität des Objektivdesigns führen. Ein Linsendesign mit niedrigem Hauptstrahlwinkel kann auch dazu beitragen, die Bandbreite des Bandpassfilters zu reduzieren, was die Unterdrückung von Umgebungslicht und damit die Leistung im Freien verbessert. Das optische Subsystem sollte auch für die gewünschte Betriebswellenlänge optimiert werden (z. B. Antireflexbeschichtungen, Bandpassfilterdesign, Linsendesign), um die Durchsatzeffizienz zu maximieren und Streulicht zu minimieren. Es gibt auch viele mechanische Anforderungen, um sicherzustellen, dass die optische Ausrichtung innerhalb der gewünschten Toleranzen für die Endanwendung liegt.

Energieverwaltung

Die Energieverwaltung ist auch bei einem Hochleistungs-3D-ToF-Kameramoduldesign von entscheidender Bedeutung. Die Lasermodulation und Pixelmodulation erzeugen kurze Bursts mit hohen Spitzenströmen, was der Power-Management-Lösung einige Beschränkungen auferlegt. Es gibt einige Funktionen auf der Ebene der integrierten Sensorschaltung (IC), die dazu beitragen können, den Spitzenstromverbrauch des Imagers zu reduzieren. Es gibt auch Energieverwaltungstechniken, die auf Systemebene angewendet werden können, um die Anforderungen an die Stromquelle (z. B. Batterie oder USB) zu verringern. Die wichtigsten analogen Versorgungen für einen ToF-Imager erfordern normalerweise einen Regler mit gutem Einschwingverhalten und geringem Rauschen.

Klicken für Bild in voller Größe

Abbildung 4. Optische Systemarchitektur. (Quelle:Analog Devices)

Depth Processing Algorithmus

Schließlich ist ein weiterer großer Teil des Designs auf Systemebene der Tiefenverarbeitungsalgorithmus. Der ToF-Bildsensor gibt rohe Pixeldaten aus, aus denen die Phaseninformationen extrahiert werden müssen. Dieser Vorgang erfordert unterschiedliche Schritte, die Rauschfilterung und Phasenunwrapping umfassen. Die Ausgabe des Phase-Unwrapping-Blocks ist eine Messung der Entfernung, die das Licht vom Laser zur Szene und zurück zum Pixel zurücklegt, oft als Entfernung oder radiale Entfernung bezeichnet.

Der radiale Abstand wird im Allgemeinen in Punktwolkeninformationen umgewandelt, die die Informationen für ein bestimmtes Pixel durch seine realen Koordinaten (X, Y, Z) darstellen. Endanwendungen verwenden oft nur die Z-Imagemap (Tiefenkarte) anstelle der vollständigen Punktwolke. Um den radialen Abstand in eine Punktwolke umzuwandeln, müssen die Linseneigenschaften und die Verzerrungsparameter bekannt sein. Diese Parameter werden während der geometrischen Kalibrierung des Kameramoduls geschätzt. Der Tiefenverarbeitungsalgorithmus kann auch andere Informationen wie aktive Helligkeitsbilder (Amplitude des zurückkommenden Lasersignals), passive 2D-IR-Bilder und Konfidenzniveaus ausgeben, die alle in Endanwendungen verwendet werden können. Die Tiefenverarbeitung kann auf dem Kameramodul selbst oder in einem Host-Prozessor an anderer Stelle im System erfolgen.

Tabelle 2 zeigt einen Überblick über die verschiedenen Komponenten auf Systemebene, die in diesem Artikel behandelt werden. Diese Themen werden in zukünftigen Artikeln ausführlicher behandelt.

Tabelle 2. Komponenten auf Systemebene von 3D-Flugzeitkameras

Komponente auf Systemebene Hauptfunktionen ToF ImagerResolution, hoher Demodulationskontrast, hohe Quanteneffizienz, hohe Modulationsfrequenz,geringes AusleserauschenBeleuchtungsquelleHohe optische Leistung, hohe Modulationsfrequenz,

AugensicherheitsfunktionenOptikHohe Lichtsammeleffizienz, minimales Streulicht, schmale BandbreitePower ManagementLow Noise , gutes Einschwingverhalten,

hoher Wirkungsgrad, liefert hohe Spitzenleistung TiefenverarbeitungGeringe Leistung, unterstützt verschiedene Ausgabearten

Tiefeninformationen

Schlussfolgerung

Continuous-Wave-Flugzeitkameras sind eine leistungsstarke Lösung mit hoher Tiefenpräzision für Anwendungen, die hochwertige 3D-Informationen erfordern. Es gibt viele Faktoren, die berücksichtigt werden müssen, um sicherzustellen, dass das beste Leistungsniveau erreicht wird. Faktoren wie Modulationsfrequenz, Demodulationskontrast, Quanteneffizienz und Ausleserauschen bestimmen die Leistung auf Bildsensorebene. Andere Faktoren sind Überlegungen auf Systemebene, zu denen das Beleuchtungssubsystem, das optische Design, die Leistungsverwaltung und die Tiefenverarbeitungsalgorithmen gehören. Alle diese Komponenten auf Systemebene sind entscheidend, um ein 3D-ToF-Kamerasystem mit höchster Präzision zu erreichen. Diese Themen auf Systemebene werden in nachfolgenden Artikeln ausführlicher behandelt. Weitere Informationen zu den ToF-Produktangeboten von ADI finden Sie unter analog.com/tof.

Paul O’Sullivan ist Systemingenieur bei Analog Devices in Santa Clara, Kalifornien. Er kam 2004 zu Analog Devices in Irland, wo er in verschiedenen Funktionen in der Testentwicklung und Anwendungstechnik tätig war, bevor er 2016 nach Kalifornien wechselte, um an fortschrittlichen Technologieprojekten für Verbraucheranwendungen zu arbeiten. Er arbeitet seit 2019 an der Entwicklung und Kalibrierung von 3D-ToF-Kameramodulen. Er hat einen B.E. Abschluss vom University College Cork und M.Eng. von der University of Limerick, Irland. Er ist unter paul.osullivan@analog.com erreichbar.

Paul O’Sullivan ist Systemingenieur bei Analog Devices in Santa Clara, Kalifornien. Er kam 2004 zu Analog Devices in Irland, wo er in verschiedenen Funktionen in der Testentwicklung und Anwendungstechnik tätig war, bevor er 2016 nach Kalifornien wechselte, um an fortschrittlichen Technologieprojekten für Verbraucheranwendungen zu arbeiten. Er arbeitet seit 2019 an der Entwicklung und Kalibrierung von 3D-ToF-Kameramodulen. Er hat einen B.E. Abschluss vom University College Cork und M.Eng. von der University of Limerick, Irland. Er ist unter paul.osullivan@analog.com erreichbar.  Nicolas Le Dortz ist System Engineering Manager in der Time of Flight (ToF) Technology Group bei Analog Devices. In dieser Funktion beaufsichtigt er die Entwicklung des ToF-Technologieangebots von ADI, verbindet funktionsübergreifende Teams, die an der Bereitstellung von ToF-Kamerasystemen beteiligt sind, und bietet den Kunden von Analog Devices herausragende Leistung. Er erhielt einen M.S. in Elektrotechnik von der Ecole Polytechnique, Frankreich, im Jahr 2010 einen M.S. in Mikroelektronik von der KTH, Schweden, im Jahr 2012 und einen Ph.D. in Elektrotechnik an der Ecole Centrale-Supelec, Frankreich, im Jahr 2015, und er war von 2013 bis 2014 Gastwissenschaftler an der UC Berkeley. Er arbeitet leidenschaftlich daran, mit Kunden zusammenzuarbeiten, um Innovationen rund um die Tiefensensorik zu schaffen, indem er Disziplinen wie Computer Vision, Signalverarbeitung, Design integrierter Schaltungen, Softwareentwicklung und optisches Design. Er ist erreichbar unter nicolas.ledorfz@analog.com.

Nicolas Le Dortz ist System Engineering Manager in der Time of Flight (ToF) Technology Group bei Analog Devices. In dieser Funktion beaufsichtigt er die Entwicklung des ToF-Technologieangebots von ADI, verbindet funktionsübergreifende Teams, die an der Bereitstellung von ToF-Kamerasystemen beteiligt sind, und bietet den Kunden von Analog Devices herausragende Leistung. Er erhielt einen M.S. in Elektrotechnik von der Ecole Polytechnique, Frankreich, im Jahr 2010 einen M.S. in Mikroelektronik von der KTH, Schweden, im Jahr 2012 und einen Ph.D. in Elektrotechnik an der Ecole Centrale-Supelec, Frankreich, im Jahr 2015, und er war von 2013 bis 2014 Gastwissenschaftler an der UC Berkeley. Er arbeitet leidenschaftlich daran, mit Kunden zusammenzuarbeiten, um Innovationen rund um die Tiefensensorik zu schaffen, indem er Disziplinen wie Computer Vision, Signalverarbeitung, Design integrierter Schaltungen, Softwareentwicklung und optisches Design. Er ist erreichbar unter nicolas.ledorfz@analog.com. Verwandte Inhalte:

- Tools Steigen Sie in der Wertschöpfungskette auf, um das Mysterium der Vision AI zu beseitigen

- Aufbau effektiver IoT-Anwendungen mit tinyML und automatisiertem maschinellem Lernen

- Time-of-Flight-Technologie verspricht verbesserte Genauigkeit

- Der Nahinfrarot-Laufzeitsensor reduziert Störungen durch Sonnenlicht

- Lidar-Plattform unterstützt Belegungserkennung, soziale Distanzierung

- ToF-Sensor bietet schnelle 3D-Erkennung

- Ultraschall-Laufzeitsensor bietet 1 Meter Reichweite

Für mehr Embedded, abonnieren Sie den wöchentlichen E-Mail-Newsletter von Embedded.

Sensor

- Wahrscheinliche Fehler in unbewiesenen Systemen

- Kleiner 3D-Bildsensor nutzt Time-of-Flight-Technologie

- Blog:Mikrofluidik-Kartuschendesign für ein IVD-System

- Single Point of Failure | Ein einfacher Überblick

- Design des Gating-Systems | Gießen | Fertigungswissenschaft

- Palettenwechsler reduzieren Rüstzeit

- Laufzeit im Vergleich zu FMCW-LiDAR-Systemen

- Antriebssystem für Überschallflüge

- Überlegungen zum Beleuchtungsdesign für robotergestützte Chirurgie-Sichtsysteme

- Photorezeptorsystem für die Melatoninregulierung und Phototherapie