Edge AI fordert die Speichertechnologie heraus

Mit dem Aufkommen von KI an der Edge kommen eine ganze Reihe neuer Anforderungen an Speichersysteme. Können die heutigen Speichertechnologien den hohen Anforderungen dieser anspruchsvollen neuen Anwendung gerecht werden und was versprechen neue Speichertechnologien langfristig für Edge-KI?

Als erstes muss man feststellen, dass es keine Standardanwendung für „Edge-KI“ gibt. the edge in seiner weitesten Auslegung umfasst alle KI-fähigen elektronischen Systeme außerhalb der Cloud. Dazu kann „Near Edge“ gehören, das im Allgemeinen Rechenzentren von Unternehmen und Server vor Ort abdeckt.

Weiter draußen sind Anwendungen wie Computer Vision für autonomes Fahren. Gateway-Ausrüstung für die Fertigung führt eine KI-Inferenz durch, um auf Fehler in Produkten in der Produktionslinie zu prüfen. 5G-Edge-Boxen an Strommasten analysieren Videostreams für Smart-City-Anwendungen wie das Verkehrsmanagement. Und die 5G-Infrastruktur nutzt KI am Edge für komplexe, aber effiziente Beamforming-Algorithmen.

An der „fernen Kante“ wird KI in Geräten wie Mobiltelefonen unterstützt – denken Sie an Snapchat-Filter – Sprachsteuerung von Geräten und IoT-Sensorknoten in Fabriken, die eine Sensorfusion durchführen, bevor die Ergebnisse an ein anderes Gateway-Gerät gesendet werden.

Die Rolle des Speichers in Edge-KI-Systemen – zum Speichern von neuronalen Netzwerkgewichten, Modellcode, Eingabedaten und Zwischenaktivierungen – ist für die meisten KI-Anwendungen gleich. Workloads müssen beschleunigt werden, um die KI-Rechenkapazität zu maximieren, um effizient zu bleiben, daher sind die Anforderungen an Kapazität und Bandbreite im Allgemeinen hoch. Die anwendungsspezifischen Anforderungen sind jedoch vielfältig und können Größe, Stromverbrauch, Niederspannungsbetrieb, Zuverlässigkeit, Wärme-/Kühlungsüberlegungen und Kosten umfassen.

Edge-Rechenzentren

Edge-Rechenzentren sind ein wichtiger Edge-Markt. Die Anwendungsfälle reichen von medizinischer Bildgebung, Forschung und komplexen Finanzalgorithmen, bei denen der Datenschutz das Hochladen in die Cloud verhindert. Ein anderer sind selbstfahrende Fahrzeuge, bei denen Latenz dies verhindert.

Diese Systeme verwenden dieselben Speicher, die in Servern in anderen Anwendungen zu finden sind.

„Es ist wichtig, DRAM mit niedriger Latenz für schnellen Hauptspeicher auf Byte-Ebene in Anwendungen zu verwenden, in denen KI-Algorithmen entwickelt und trainiert werden“, sagte Pekon Gupta, Lösungsarchitekt bei Smart Modular Technologies, einem Designer und Entwickler von Speicherprodukten. „Für große Datensätze werden RDIMMs oder LRDIMMs mit hoher Kapazität benötigt. NVDIMMs werden für die Systembeschleunigung benötigt – wir verwenden sie für Schreib-Caching und Checkpointing anstelle von langsameren SSDs.“

Pekon Gupta

Die Lokalisierung von Rechenknoten in der Nähe von Endbenutzern ist der Ansatz von Telekommunikationsanbietern.

„Wir sehen einen Trend, diese [Telco-]Edge-Server fähiger zu machen, komplexe Algorithmen auszuführen“, sagte Gupta. Daher „fügen Dienstanbieter diesen Edge-Servern mehr Speicher und Verarbeitungsleistung hinzu, indem sie Geräte wie RDIMM, LRDIMM und hochverfügbaren persistenten Speicher wie NVDIMM verwenden.“

Gupta sieht in Intel Optane, dem nichtflüchtigen 3D-Xpoint-Speicher des Unternehmens, dessen Eigenschaften zwischen DRAM und Flash liegen, eine gute Lösung für Server-KI-Anwendungen.

„Sowohl Optane DIMMs als auch NVDIMMs werden als KI-Beschleuniger verwendet“, sagte er. „NVDIMMs bieten Tiering-, Caching-, Schreibpuffer- und Metadatenspeicherfunktionen mit sehr geringer Latenz für die Beschleunigung von KI-Anwendungen. Optane-DIMMs für Rechenzentren werden für die In-Memory-Datenbankbeschleunigung verwendet, bei der Hunderte von Gigabyte bis Terabyte an persistentem Speicher in Kombination mit DRAM verwendet werden. Obwohl es sich bei beiden um persistente Speicherlösungen für KI/ML-Beschleunigungsanwendungen handelt, haben sie unterschiedliche und unterschiedliche Anwendungsfälle.“

Kristie Mann, Intels Director of Product Marketing für Optane, sagte gegenüber der EE Times Optane gewinnt Anwendungen im Server-KI-Segment.

Intels Kristie Mann

„Unsere Kunden verwenden bereits heute den persistenten Speicher von Optane, um ihre KI-Anwendungen zu betreiben“, sagte sie. „Sie betreiben erfolgreich E-Commerce, Videoempfehlungs-Engines und Echtzeit-Finanzanalysen. Aufgrund der höheren verfügbaren Kapazität sehen wir eine Verlagerung zu In-Memory-Anwendungen.“

Die hohen Preise von DRAM machen Optane zunehmend zu einer attraktiven Alternative. Ein Server mit zwei skalierbaren Intel Xeon-Prozessoren plus persistentem Optane-Speicher kann bis zu 6 Terabyte Arbeitsspeicher für datenhungrige Anwendungen aufnehmen.

„DRAM ist immer noch das beliebteste, aber es hat seine Grenzen aus Kosten- und Kapazitätsgesichtspunkten“, sagte Mann. „Neue Speicher- und Speichertechnologien wie Optane Persistent Memory und Optane SSD sind aufgrund ihrer Kosten-, Kapazitäts- und Leistungsvorteile eine Alternative zu DRAM. Optane SSDs sind besonders leistungsstark beim Caching von HDD- und NAND-SSD-Daten, um kontinuierlich KI-Anwendungsdaten zuzuführen.“

Optane schneidet auch im Vergleich zu anderen aufkommenden Erinnerungen günstig ab, die heute nicht vollständig ausgereift oder skalierbar sind, fügte sie hinzu.

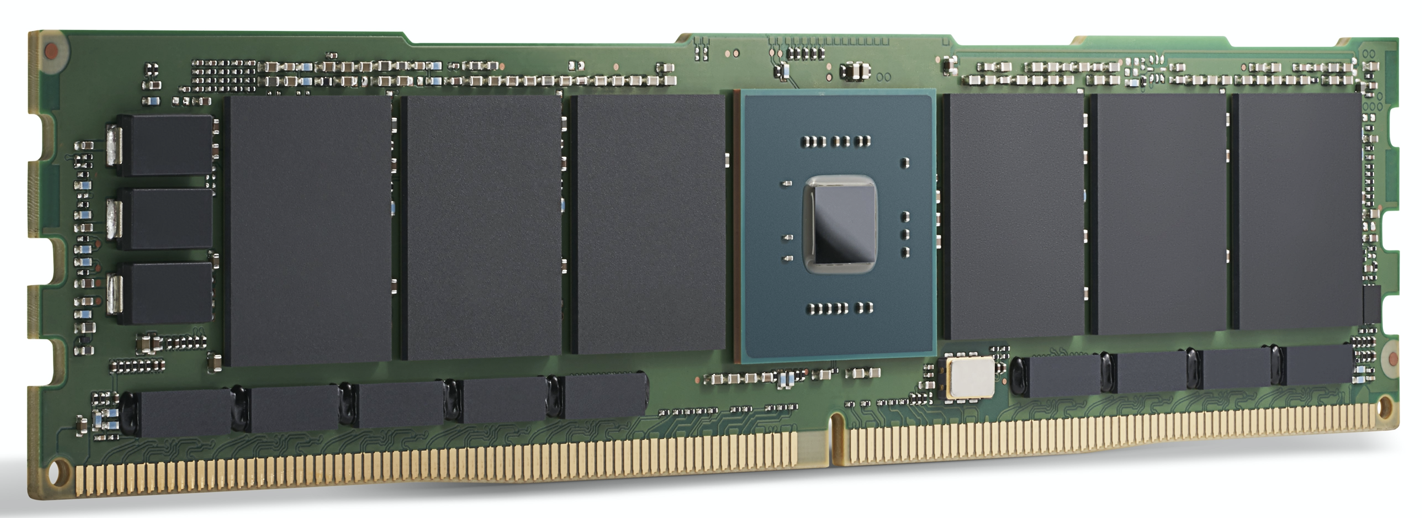

Ein Modul der Intel Optane 200-Serie. Intel sagt, Optane wird

bereits heute verwendet, um KI-Anwendungen zu betreiben. (Quelle:Intel)

GPU-Beschleunigung

Für High-End-Edge-Rechenzentren und Edge-Server-Anwendungen gewinnen KI-Rechenbeschleuniger wie GPUs an Bedeutung. Neben DRAM umfasst die Speicherauswahl hier GDDR, ein spezielles DDR-SDRAM, das entwickelt wurde, um GPUs mit hoher Bandbreite zu versorgen, und HBM, eine relativ neue Die-Stacking-Technologie, die mehrere Speicherchips im selben Gehäuse wie die GPU selbst platziert.

Beide sind für die extrem hohe Speicherbandbreite ausgelegt, die von KI-Anwendungen benötigt wird.

Für das anspruchsvollste KI-Modelltraining bietet HBM2E 3,6 Gbit/s und eine Speicherbandbreite von 460 GB/s (zwei HBM2E-Stacks bieten fast 1 TB/s). Das ist einer der leistungsstärksten verfügbaren Speicher auf kleinstem Raum mit dem niedrigsten Stromverbrauch. HBM wird vom GPU-Führer Nvidia in allen seinen Rechenzentrumsprodukten verwendet.

GDDR6 wird auch für KI-Inferenzanwendungen am Edge verwendet, sagte Frank Ferro, Senior Director of Product Marketing für IP Cores bei Rambus. Ferro sagte, dass GDDR6 die Geschwindigkeits-, Kosten- und Leistungsanforderungen von Edge-KI-Inferenzsystemen erfüllen kann. GDDR6 kann beispielsweise 18 Gbps liefern und bietet 72 GB/s. Die vier GDDR6-DRAMs bieten eine Speicherbandbreite von fast 300 GB/s.

„GDDR6 wird für KI-Inferenz- und ADAS-Anwendungen verwendet“, fügte Ferro hinzu.

Beim Vergleich von GDDR6 mit LPDDR, dem Ansatz von Nvidia für die meisten Edge-Lösungen außerhalb von Rechenzentren, von Jetson AGX Xavier bis Jetson Nano, bestätigte Ferro, dass LPDDR für kostengünstige KI-Inferenz am Edge oder Endpunkt geeignet ist.

„Die Bandbreite von LPDDR ist auf 4,2 Gbit/s für LPDDR4 und 6,4 Gbit/s für LPDDR5 begrenzt“, sagte er. „Wenn die Anforderungen an die Speicherbandbreite steigen, werden wir immer mehr Designs sehen, die GDDR6 verwenden. Diese Lücke bei der Speicherbandbreite trägt dazu bei, die Nachfrage nach GDDR6 zu steigern.“

Frank Ferro von Rambus

Obwohl sie so konzipiert sind, dass sie neben GPUs passen, können andere Verarbeitungsbeschleuniger die Bandbreite von GDDR nutzen. Ferro hob den Achronix Speedster7t hervor, einen FPGA-basierten KI-Beschleuniger, der für Inferenz und einige Low-End-Trainings verwendet wird.

„In Edge-KI-Anwendungen ist sowohl Platz für HBM- als auch GDDR-Speicher“, sagte Ferro. HBM „wird weiterhin in Edge-Anwendungen eingesetzt. Bei allen Vorteilen von HBM sind die Kosten aufgrund der 3D-Technologie und der 2,5D-Fertigung dennoch hoch. Vor diesem Hintergrund ist GDDR6 ein guter Kompromiss zwischen Kosten und Leistung, insbesondere für die KI-Inferenz im Netzwerk.“

HBM wird in Hochleistungs-KI-ASICs für Rechenzentren wie der Graphcore IPU verwendet. Obwohl es eine hervorragende Leistung bietet, kann sein Preis für einige Anwendungen hoch sein.

Qualcomm gehört zu denen, die diesen Ansatz verwenden. Seine Cloud AI 100 zielt auf die Beschleunigung der KI-Inferenz in Edge-Rechenzentren, 5G-Edge-Boxen, ADAS/autonomes Fahren und 5G-Infrastruktur ab.

„Für uns war es wichtig, Standard-DRAM anstelle von HBM zu verwenden, weil wir die Stückliste niedrig halten wollen“, sagte Keith Kressin, General Manager der Computing and Edge Cloud-Einheit von Qualcomm. „Wir wollten Standardkomponenten verwenden, die Sie von mehreren Lieferanten beziehen können. Wir haben Kunden, die alles auf dem Chip machen wollen, und wir haben Kunden, die Cross-Card betreiben wollen. Aber sie alle wollten die Kosten im Rahmen halten und nicht auf HBM oder einen exotischeren Speicher setzen.

„Im Training“, fuhr er fort, „hat man wirklich große Modelle, die über [mehrere Chips] gehen würden, aber zum Schluss [der Markt von Cloud AI 100], viele der Modelle sind stärker lokalisiert.“

Der andere Rand

Außerhalb des Rechenzentrums konzentrieren sich Edge-KI-Systeme im Allgemeinen auf Inferenz, mit einigen bemerkenswerten Ausnahmen wie föderiertem Lernen und anderen inkrementellen Trainingstechniken.

Einige KI-Beschleuniger für stromempfindliche Anwendungen verwenden Speicher für die KI-Verarbeitung. Inferenz, die auf multidimensionaler Matrixmultiplikation basiert, eignet sich für analoge Rechentechniken mit einem Array von Speicherzellen, die zum Durchführen von Berechnungen verwendet werden. Mit dieser Technik wurden die Geräte von Syntiant für die Sprachsteuerung von Unterhaltungselektronik entwickelt, und die Geräte von Gyrfalcon wurden zu einem Smartphone entwickelt, wo sie Rückschlüsse auf Kameraeffekte verarbeiten.

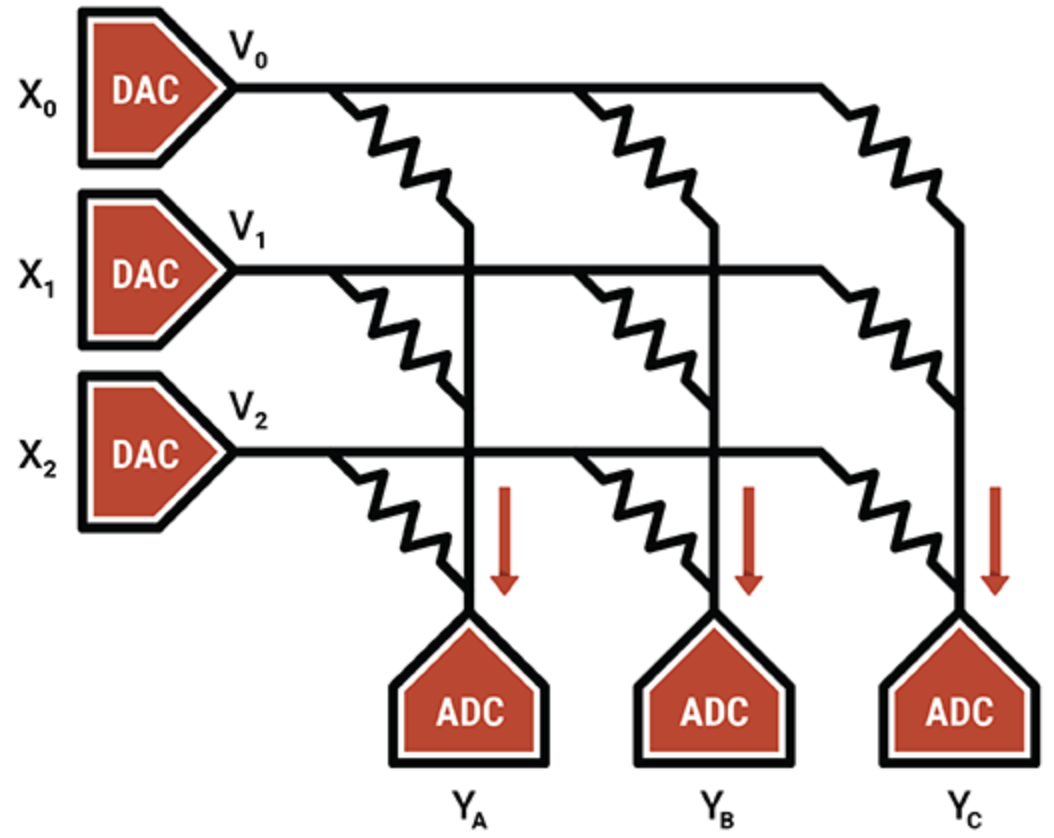

In einem anderen Beispiel verwendet der Spezialist für intelligente Verarbeitungseinheiten Mythic den analogen Betrieb von Flash-Speicherzellen, um einen 8-Bit-Ganzzahlwert (einen Gewichtsparameter) auf einem einzelnen Flash-Transistor zu speichern, wodurch dieser viel dichter ist als andere Compute-in-Memory-Technologien. Der programmierte Blitztransistor fungiert als variabler Widerstand; Eingänge werden als Spannungen geliefert und Ausgänge als Ströme gesammelt. In Kombination mit ADCs und DACs ist das Ergebnis eine effiziente Matrix-Multiply-Engine.

Die IP von Mythic liegt in den Kompensations- und Kalibrierungstechniken, die Rauschen unterdrücken und eine zuverlässige 8-Bit-Berechnung ermöglichen.

Mythic verwendet ein Array von Flash-Speichertransistoren, um dichte, mehrfach akkumulierende Engines herzustellen (Quelle:Mythic)

Abgesehen von Compute-in-Memory-Geräten sind ASICs für bestimmte Edge-Nischen beliebt, insbesondere für Systeme mit niedrigem und extrem niedrigem Stromverbrauch. Speichersysteme für ASICs verwenden eine Kombination mehrerer Speichertypen. Verteilter lokaler SRAM ist der schnellste und energieeffizienteste, aber nicht sehr flächeneffizient. Ein einzelner SRAM auf dem Chip ist flächeneffizienter, führt jedoch zu Leistungsengpässen. Off-Chip-DRAM ist billiger, verbraucht aber viel mehr Strom.

Geoff Tate, CEO von Flex Logix, sagte, dass das Finden der richtigen Balance zwischen verteiltem SRAM, Bulk-SRAM und Off-Chip-DRAM für seinen InferX X1 eine Reihe von Leistungssimulationen erforderte. Das Ziel bestand darin, den Inferenzdurchsatz pro Dollar zu maximieren – eine Funktion der Chipgröße, der Gehäusekosten und der Anzahl der verwendeten DRAMs.

„Der optimale Punkt war ein einzelner x32-LPDDR4-DRAM; 4K-MACs (7,5 TOPS bei 933 MHz); und etwa 10 MB SRAM“, sagte er. „SRAM ist schnell, aber im Vergleich zu DRAM teuer. Mit der 16-nm-Prozesstechnologie von TSMC benötigt 1 MB SRAM etwa 1,1 mm 2 . „Unser InferX X1 ist nur 54 mm 2 und aufgrund unserer Architektur überlappen sich DRAM-Zugriffe weitgehend mit der Berechnung, so dass es keine Leistungseinbußen gibt. Für große Modelle mit einem einzigen DRAM ist zumindest bei unserer Architektur der richtige Kompromiss“, sagte Tate.

Der Flex Logix-Chip wird in Edge-KI-Inferenzanwendungen verwendet, die einen Echtzeitbetrieb erfordern, einschließlich der Analyse von Streaming-Video mit geringer Latenz. Dazu gehören ADAS-Systeme, die Analyse von Sicherheitsmaterial, medizinische Bildgebung und Anwendungen zur Qualitätssicherung/Inspektion.

Welche Art von DRAM wird in diesen Anwendungen neben dem InferX X1 eingesetzt?

„Wir glauben, dass LPDDR am beliebtesten sein wird:Ein einzelner DRAM bietet mehr als 10 GB/s Bandbreite … und hat dennoch genügend Bits, um die Gewichtungen/Zwischenaktivierungen zu speichern“, sagte Tate. „Jeder andere DRAM würde mehr Chips und Schnittstellen erfordern und es müssten mehr Bits gekauft werden, die nicht verwendet werden.“

Gibt es hier Platz für neue Speichertechnologien?

„Die Waferkosten steigen dramatisch, wenn ein neuer Speicher verwendet wird, während SRAM ‚kostenlos‘ ist, mit Ausnahme des Siliziumbereichs“, fügte er hinzu. „Wenn sich die Wirtschaft ändert, könnte sich auch der Wendepunkt ändern, aber es wird noch weiter gehen.“

Neue Erinnerungen

Trotz der Größenvorteile bieten andere Speichertypen zukünftige Möglichkeiten für KI-Anwendungen.

MRAM (magnetoresistiver RAM) speichert jedes Datenbit über die Ausrichtung von Magneten, die durch eine angelegte elektrische Spannung gesteuert werden. Wenn die Spannung niedriger ist als zum Flippen des Bits erforderlich, besteht nur eine Wahrscheinlichkeit, dass ein Bit umkippt. Diese Zufälligkeit ist unerwünscht, daher wird der MRAM mit höheren Spannungen betrieben, um dies zu verhindern. Dennoch können einige KI-Anwendungen diese inhärente Stochasität nutzen (die man sich als den Prozess der zufälligen Auswahl oder Generierung von Daten vorstellen kann).

Experimente haben die Stochasitätsfähigkeiten seines MRAMs auf die Geräte von Gyrfalcon angewendet, eine Technik, bei der die Präzision aller Gewichtungen und Aktivierungen auf 1 Bit reduziert wird. Dies wird verwendet, um den Rechen- und Strombedarf für Fern-Edge-Anwendungen drastisch zu reduzieren. Kompromisse bei der Genauigkeit sind wahrscheinlich, je nachdem, wie das Netzwerk neu trainiert wird. Im Allgemeinen können neuronale Netze trotz der reduzierten Präzision zuverlässig funktionieren.

„Binarisierte neuronale Netze sind insofern einzigartig, als sie zuverlässig funktionieren können, selbst wenn die Gewissheit, dass eine Zahl -1 oder +1 ist, verringert wird“, sagte Andy Walker, Product Vice President bei Spin Memory. „Wir haben festgestellt, dass solche BNNs immer noch mit hoher Genauigkeit funktionieren können, da diese Gewissheit [durch] die Einführung einer sogenannten „Bitfehlerrate“ der falsch geschriebenen Speicherbits verringert wird.“

Andy Walker von Spin Memory

MRAM kann bei niedrigen Spannungspegeln natürlich Bitfehlerraten auf kontrollierte Weise einführen, die Genauigkeit beibehalten und gleichzeitig den Leistungsbedarf noch weiter senken. Der Schlüssel liegt darin, die optimale Genauigkeit bei der niedrigsten Spannung und der kürzesten Zeit zu bestimmen. Das führt zu höchster Energieeffizienz, sagte Walker.

Obwohl diese Technik auch für neuronale Netze mit höherer Präzision gilt, ist sie besonders für BNNs geeignet, da die MRAM-Zelle zwei Zustände hat, die den binären Zuständen in einem BNN entsprechen.

Laut Walker ist die Verwendung von MRAM am Edge eine weitere potenzielle Anwendung.

„Für Edge-KI kann MRAM bei niedrigeren Spannungen in Anwendungen laufen, bei denen eine hohe Leistungsgenauigkeit nicht erforderlich ist, aber Verbesserungen der Energieeffizienz und Speicherausdauer sehr wichtig sind“, sagte er. „Darüber hinaus ermöglicht die inhärente Nichtflüchtigkeit von MRAM eine Datenerhaltung ohne Strom.

Eine Anwendung ist ein sogenannter vereinheitlichter Speicher, „wo dieser neue Speicher sowohl als eingebetteter Flash- als auch als SRAM-Ersatz fungieren kann, wodurch Platz auf dem Chip eingespart und die dem SRAM inhärente statische Verlustleistung vermieden wird.“

Während der MRAM von Spin Memory kurz vor der kommerziellen Einführung steht, würde eine spezifische Implementierung des BNN am besten mit einer Variante der Basis-MRAM-Zelle funktionieren. Daher bleibt es im Forschungsstadium.

Neuromorphes ReRAM

Ein weiterer aufstrebender Speicher für Edge-KI-Anwendungen ist ReRAM. Jüngste Forschungen des Politecnico Milan mit der Siliziumoxid (SiOx) ReRAM-Technologie von Weebit Nano zeigten vielversprechende Ergebnisse für neuromorphes Computing. ReRAM fügte der neuronalen Netzwerkhardware eine Dimension der Plastizität hinzu; das heißt, es könnte sich weiterentwickeln, wenn sich die Bedingungen ändern – eine nützliche Eigenschaft im neuromorphen Computing.

Aktuelle neuronale Netze können nicht lernen, ohne Aufgaben zu vergessen, auf die sie trainiert wurden, während das Gehirn dies ganz einfach tun kann. In Bezug auf KI ist dies „unüberwachtes Lernen“, bei dem der Algorithmus Rückschlüsse auf Datensätze ohne Labels durchführt und nach seinen eigenen Mustern in den Daten sucht. Das letztendliche Ergebnis könnten ReRAM-fähige Edge-KI-Systeme sein, die neue Aufgaben vor Ort lernen und sich an die Umgebung um sie herum anpassen können.

Insgesamt führen Speicherhersteller Technologien ein, die Geschwindigkeit und Bandbreite bieten, die für KI-Anwendungen erforderlich sind. Für viele Edge-KI-Anwendungen stehen verschiedene Speicher zur Verfügung, sei es auf demselben Chip wie die KI-Rechner, im selben Gehäuse oder auf separaten Modulen.

Während die genaue Beschaffenheit von Speichersystemen für Edge-KI von der Anwendung abhängt, erweisen sich GDDR, HBM und Optane als beliebt für Rechenzentren, während LPDDR mit On-Chip-SRAM für Endpunktanwendungen konkurriert.

Neue Erinnerungen verleihen ihre neuartigen Eigenschaften der Forschung, die darauf abzielt, neuronale Netze über die Fähigkeiten heutiger Hardware hinaus zu entwickeln, um zukünftige energieeffiziente, vom Gehirn inspirierte Systeme zu ermöglichen.

>> Dieser Artikel wurde ursprünglich veröffentlicht am unsere Schwesterseite EE Times.

Eingebettet

- Nur-Lese-Speicher (ROM)

- Mikroprozessoren

- Big Data, nicht ganz einfach:Neue Herausforderungen in der Fabrikwartungstechnologie meistern

- ST-Sampling eingebetteter Phasenwechselspeicher für Automobil-Mikrocontroller

- Edge-Anwendungstechnologie kommt allen Branchen zugute

- 5G und Edge stellen neue Herausforderungen für die Cybersicherheit im Jahr 2021 dar

- 4 Tipps und Herausforderungen für besseres IIoT-Asset-Management

- 3 Paradebeispiele modernster fortschrittlicher Fertigungstechnologie

- Linearbewegungstechnologie

- Wie vernetzte Technologie helfen kann, die Herausforderungen der Lieferkette zu lösen