DSPs für Audio-KI am Edge verwenden

Einst auf Cloud-Server mit praktisch unbegrenzten Ressourcen beschränkt, wandert maschinelles Lernen aus verschiedenen Gründen in Edge-Geräte, einschließlich geringerer Latenz, geringerer Kosten, Energieeffizienz und verbesserter Privatsphäre. Die Zeit, die benötigt wird, um Daten zur Interpretation an die Cloud zu senden, könnte unerschwinglich sein, wie beispielsweise die Fußgängererkennung in einem selbstfahrenden Auto. Die zum Senden von Daten an die Cloud erforderliche Bandbreite kann kostspielig sein, ganz zu schweigen von den Kosten für den Cloud-Dienst selbst, wie etwa die Spracherkennung für Sprachbefehle.

Energie ist ein Kompromiss zwischen dem Senden von Daten hin und her zum Server und der lokalisierten Verarbeitung. Machine-Learning-Berechnungen sind komplex und können den Akku eines Edge-Geräts leicht entladen, wenn sie nicht effizient ausgeführt werden. Edge-Entscheidungen behalten auch die Daten auf dem Gerät, was für die Privatsphäre der Benutzer wichtig ist, wie z. B. sensible E-Mails, die per Sprache auf einem Smartphone diktiert werden. Audio-KI ist ein reichhaltiges Beispiel für Inferenz am Rande; und ein neuer Typ eines digitalen Signalprozessors (DSP), der auf Anwendungsfälle für maschinelles Lernen im Audiobereich spezialisiert ist, kann eine bessere Leistung und neue Funktionen am Rand des Netzwerks ermöglichen.

Always-on-Sprachwecker ist eines der frühesten Beispiele für maschinelles Lernen am Edge:Hören Sie auf ein Schlüsselwort wie „Hey Siri“ oder „OK Google“, bevor Sie den Rest des Systems aufwecken, um die nächste Aktion zu bestimmen. Wenn diese Schlüsselworterkennung auf einem generischen Anwendungsprozessor ausgeführt wurde, könnte sie weit über 100 mW dauern. Im Laufe eines Tages würde dies den Smartphone-Akku entladen. Daher hatten die ersten Telefone, die diese Funktion implementierten, Algorithmen, die auf einen kleinen DSP portiert wurden, der mit weniger als 5 mW betrieben werden konnte. Heutzutage können dieselben Algorithmen auf einem spezialisierten Audio- und Machine-Learning-DSP in einem intelligenten Mikrofon mit weniger als 0,5 mW ausgeführt werden.

Sobald ein Edge-Gerät für permanentes Audio-Maschinenlernen aktiviert ist, kann es mehr tun als nur Spracherkennung bei geringem Stromverbrauch:Kontextbewusstsein, z. und sogar erkennen, ob jemand in der Nähe schreit oder lacht. Diese Arten von Funktionen ermöglichen neue anspruchsvolle Anwendungsfälle, die das Edge-Gerät verbessern und dem Benutzer zugutekommen könnten.

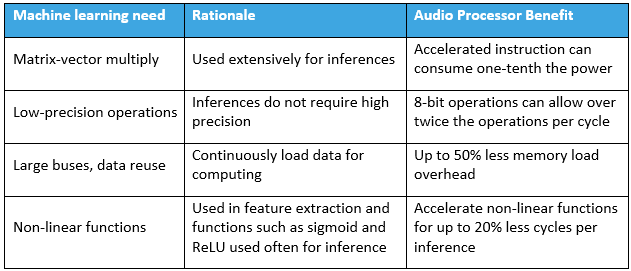

Die beste Leistung und Energieeffizienz für Machine-Learning-Inferenz am Edge erfordert eine umfassende Hardware-Anpassung. Einige der wirkungsvollsten Techniken sind in Tabelle 1 zusammengestellt. Die Implementierung dieser Funktionen verbessert die Effizienz der Edge-Machine-Learning-Inferenz.

Die Mehrheit der arithmetischen Operationen, die für die Inferenz eines neuronalen Netzes benötigt werden, sind Matrix-Vektor-Multiplikationen. Dies liegt daran, dass Modelle für maschinelles Lernen typischerweise als Matrizen dargestellt werden, die auf neue Stimulanzien angewendet werden, die als Vektoren dargestellt werden. Die gebräuchlichste Technik zur Verbesserung der Edge-Machine-Learning-Inferenz besteht darin, die Matrix-Vektor-Multiplikation sehr effizient zu gestalten. Eine fusionierte Multiplikation gefolgt von einer Akkumulation (MAC) ist eine gängige Methode, um dies anzugehen.

Obwohl die Trainingsphase empfindlich auf numerische Genauigkeit reagiert, kann die Inferenzphase mit geringer Genauigkeit (z. B. 8 Bit) nahezu äquivalente Ergebnisse erzielen. Eine Begrenzung der Genauigkeit kann die Komplexität der Kantenberechnung stark reduzieren. Aus diesem Grund haben Prozessorfirmen wie Intel und Texas Instruments MACs mit begrenzter Präzision hinzugefügt. Der TMS320C6745 von Texas Instruments kann 8 MACs mit jeweils 8 Bit pro Zyklus ausführen. Außerdem unterstützt der Audio-DSP von Knowles 16 MACS mit jeweils 8 Bit pro Zyklus.

Sowohl die Trainings- als auch die Inferenzphase setzen das Speichersubsystem unter Druck. Die Prozessorunterstützung für große Wortbreiten wird oft verbessert, um dies zu berücksichtigen. Intels neuere Hochleistungsprozessoren verfügen über AVX-512, das die Übertragung von 512 Bit pro Zyklus in ein Array von 64 Multiplikatoren unterstützt. Der Texas Instruments 6745 verwendet einen 64-Bit-Bus, um die Speicherbandbreite zu erhöhen. Die fortschrittlichen Audioprozessoren von Knowles verwenden einen 128-Bit-Bus, der eine gute Balance zwischen großer Chipfläche und hoher Bandbreite bietet. Darüber hinaus erfordern Audio-Machine-Learning-Architekturen (wie RNN oder LSTM) häufig Feedback. Dies stellt zusätzliche Anforderungen an die Chiparchitektur, da die Datenabhängigkeit stark Pipeline-Architekturen blockieren kann.

Obwohl herkömmliches maschinelles Lernen mit Rohdaten arbeiten kann, führen Algorithmen des maschinellen Lernens in der Regel Spektralanalysen und Merkmalsextraktion durch, um neuronale Netze zu speisen. Die Beschleunigung traditioneller Signalverarbeitungsfunktionen wie FFTs, Audiofilter, trigonometrische Funktionen und Logarithmen ist für die Energieeffizienz erforderlich. Nachfolgende Operationen verwenden oft eine Vielzahl von nichtlinearen Vektoroperationen, wie z. B. ein Sigmoid, implementiert als hyperbolischer Tangens oder gleichgerichtete lineare Einheit (Absolutwertfunktion, bei der alle negativen Zahlen auf Null geändert werden). Diese ausgeklügelten nichtlinearen Operationen benötigen bei herkömmlichen Prozessoren viele Zyklen. Einzelzyklusanweisungen für diese Funktionen verbessern auch die Energieeffizienz von Audio-DSPs mit maschinellem Lernen.

Zusammenfassend lässt sich sagen, dass fortschrittliche Prozessoren, die sowohl auf maschinelles Lernen als auch auf Audioverarbeitung spezialisiert sind, eine Echtzeit-Always-on-Edge-Inferenz zu geringen Kosten bei gleichzeitiger Wahrung der Privatsphäre ermöglichen. Der Energieverbrauch wird durch architektonische Entscheidungen zur Befehlssatzunterstützung niedrig gehalten, um mehrere Operationen pro Zyklus und breitere Speicherbusse zu ermöglichen, um eine hohe Leistung bei niedriger Leistung aufrechtzuerhalten. Da Unternehmen weiterhin Innovationen im Bereich spezialisierter Rechenleistung am Edge entwickeln, werden die Anwendungsfälle für maschinelles Lernen, die es verwenden, nur zunehmen.

Jim Steele ist Vice President of Technology Strategy bei Knowles Corp.

>> Dieser Artikel wurde ursprünglich veröffentlicht am unsere Schwesterseite EE Times:„Machine Learning on DSPs:Enabling Audio AI at the Edge.“

Internet der Dinge-Technologie

- Die Lieferkette und maschinelles Lernen

- Es ist Zeit für Veränderungen:Eine neue Ära am Rande

- NXP verdoppelt maschinelles Lernen am Edge

- Trends treiben die Verarbeitung weiter an den Rand für KI

- Tipps zur Auswahl der richtigen CNC-Maschine

- Richtlinien für die Verwendung von DSP-Handles

- Maschinelles Lernen im Feld

- Intel beauftragt Udacity mit der Vergabe eines Abschlusses für AI on the Edge

- Die Notwendigkeit von Open Source am Edge (eBook)

- Am Rande des Ruhms:Ermöglichung eines neuen Internet-Maschinenzeitalters