Datenstreaming eröffnet neue Möglichkeiten im IoT-Zeitalter

Kelly Herrell von Hazelcast

Kelly Herrell von Hazelcast

In der vordigitalen Ära beherrschten IT-Abteilungen eine Vielzahl von technologischen Ansätzen, um Werte aus Daten zu schöpfen. Data Warehouses, Analyseplattformen und verschiedene Arten von Datenbanken füllten Rechenzentren und griffen auf Speichergeräte zu, auf denen Aufzeichnungen aufgrund ihres historischen Wertes sicher auf der Festplatte aufbewahrt wurden.

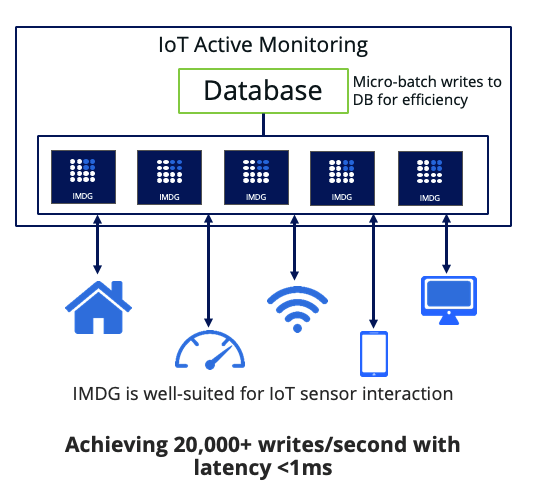

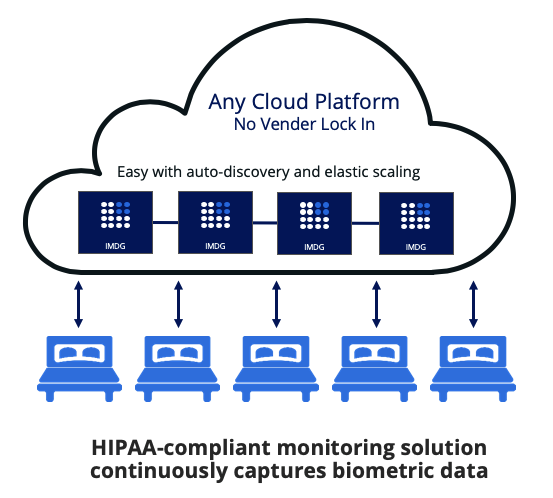

Im Gegensatz dazu sagt Kelly Herrell, CEO von Hazelcast , Daten werden heute von Geräten des Internet der Dinge (IoT) mit einer beispiellosen Geschwindigkeit generiert und gestreamt. Die „Dinge“ im IoT sind unzählig – Sensoren, mobile Apps, vernetzte Fahrzeuge usw. – was an sich schon explosiv ist. Hinzu kommt der „Netzwerkeffekt“, bei dem der Wertgrad direkt mit der Anzahl der verbundenen Benutzer korreliert, und es ist nicht schwer zu erkennen, warum Unternehmen wie IDC wird der IoT-Markt nächstes Jahr 745 Milliarden US-Dollar (665 Milliarden Euro) erreichen und 2022 die Marke von 1 Billion US-Dollar (0,89 Billionen Euro) überschreiten.

Dieser Megatrend stört das Paradigma der Datenverarbeitung. Der historische Wert der gespeicherten Daten wird durch den zeitlichen Wert der Streaming-Daten ersetzt. Im Streaming-Datenparadigma ist der Wert aus zwei Gründen eine direkte Funktion der Unmittelbarkeit:

- Unterschied :Genauso wie die einzigartigen Wassermoleküle, die durch ein Schlauchstück fließen, zu jedem Zeitpunkt unterschiedlich sind, sind auch die einzigartigen Daten, die für jedes Zeitfenster durch das Netzwerk strömen, unterschiedlich.

- Verderblichkeit :Die Möglichkeit, auf Erkenntnisse aus Streaming-Daten zu reagieren, verschwindet oft kurz nach der Generierung der Daten.

Die Konzepte von Unterschied und Verderblichkeit auf dieses Streaming-Data-Paradigma anwenden. Plötzliche Änderungen in Datenströmen erfordern sofortiges Handeln, sei es ein Mustertreffer bei der Echtzeit-Gesichtserkennung oder Vibrationssensoren von Bohrinseln, die plötzlich Anomalien registrieren, die katastrophal sein könnten, wenn nicht sofort vorbeugende Maßnahmen ergriffen werden.

In der heutigen zeitkritischen Ära beschleunigen IoT und Streaming-Daten den Wandel in diesem neuen Datenparadigma. Die Stream-Verarbeitung selbst ändert sich schnell.

Zwei Generationen, gleiche Probleme

Die erste Generation der Stream-Verarbeitung basierte weitgehend auf der Stapelverarbeitung unter Verwendung komplexer Hadoop-basierter Architekturen. Nachdem die Daten geladen wurden – was deutlich nach ihrer Generierung war – wurden sie dann als Stream durch die Datenverarbeitungs-Engine gepusht. Die Kombination aus Komplexität und Verzögerung machte diese Methode weitgehend unzureichend.

Die zweite Generation (immer noch weitgehend im Einsatz) verkleinerte die Chargengrößen auf „Mikrochargen“. Die Komplexität der Implementierung hat sich nicht geändert, und während kleinere Batches weniger Zeit in Anspruch nehmen, gibt es immer noch Verzögerungen beim Einrichten des Batches. Die zweite Generation kann Unterschied erkennen geht aber nicht auf Verderblichkeit ein Wenn es eine Änderung im Stream entdeckt, ist es bereits Geschichte.

Stream-Verarbeitung der dritten Generation

Die ersten beiden Generationen verdeutlichen die Hürden für IT-Organisationen:Wie lässt sich Stream Processing einfacher implementieren, während die Daten im Moment ihrer Entstehung verarbeitet werden? Die Antwort:Software muss vereinfacht sein, nicht chargenorientiert und klein genug sein, um extrem nahe an den Stream-Quellen platziert zu werden.

Die ersten beiden Generationen der Stream-Verarbeitung erfordern die Installation und Integration mehrerer Komponenten, was für die meisten Edge- und IoT-Infrastrukturen zu einem zu großen Platzbedarf führt. Ein leichtgewichtiger Footprint ermöglicht es, die Streaming-Engine nahe am Ursprung der Daten zu installieren oder dort einzubetten. Die unmittelbare Nähe macht es überflüssig, dass der IoT-Stream das Netzwerk zur Verarbeitung durchqueren muss, was zu einer geringeren Latenz führt und dazu beiträgt, die Herausforderung der Verderblichkeit anzugehen.

Die Herausforderung für IT-Organisationen besteht darin, Streaming-Datenquellen in Echtzeit aufzunehmen und zu verarbeiten und die Daten jetzt in verwertbare Informationen zu verfeinern . Verzögerungen bei der Stapelverarbeitung mindern den Wert von Streaming-Daten. Die Stream-Verarbeitung der dritten Generation kann die mit der Stapelverarbeitung verbundenen Latenzprobleme überwinden, indem sie sofort an Live-Rohdaten in jeder Größenordnung arbeitet.

Streaming in der Praxis

Eine Bohrinsel ist eines der bekanntesten Symbole der Energiewirtschaft. Die Betriebskosten einer Bohranlage sind jedoch unglaublich hoch und jede Ausfallzeit während des gesamten Prozesses kann sich erheblich auf das Endergebnis des Betreibers auswirken. Präventive Erkenntnisse bieten neue Möglichkeiten, diese Verluste drastisch zu verbessern.

SigmaStream , spezialisiert auf hochfrequente Datenströme, die im Bohrprozess erzeugt werden, ist ein gutes Beispiel für die Implementierung von Stream Processing im Feld. SigmaStream Kundenbohrgeräte sind mit einer Vielzahl von Sensoren ausgestattet, um kleinste Vibrationen während des Bohrprozesses zu erkennen. Die von diesen Sensoren generierten Daten können 60 bis 70 Kanäle mit Hochfrequenzdaten erreichen, die in das Stream-Verarbeitungssystem eingehen.

Durch die Verarbeitung der Informationen in Echtzeit ermöglicht SigmaStream den Bedienern, diese Datenströme auszuführen und sofort auf die Daten zu reagieren, um Ausfälle und Verzögerungen zu vermeiden. Eine Streaming-Engine der dritten Generation, gepaart mit den richtigen Tools zur Verarbeitung und Analyse der Daten, ermöglicht es den Bedienern, durch Streaming-Analysen der Daten des Bohrturms fast nicht wahrnehmbare Vibrationen zu überwachen. Durch fein abgestimmte Anpassungen haben SigmaStream-Kunden Millionen von Dollar gespart und die Zeit vor Ort um bis zu 20 % reduziert.

In der heutigen digitalen Ära ist Latenz die neue Ausfallzeit. Die Stream-Verarbeitung ist der logische nächste Schritt für Unternehmen, die Informationen schneller verarbeiten, Aktionen schneller ermöglichen und neue Daten in der Geschwindigkeit nutzen möchten, mit der sie ankommen. Durch die Integration von Stream-Processing in Mainstream-Anwendungen können Unternehmen in einer Welt, die von neuen Arten von Ultra-High-Performance-Anwendungen dominiert wird, erfolgreich sein und Informationen zeitsensitiv bereitstellen, um steigende Erwartungen zu erfüllen.

Der Autor ist Kelly Herrell, CEO von Hazelcast

Internet der Dinge-Technologie

- Datenkonform im IoT bleiben

- Wie bekommen wir ein besseres Bild vom IoT?

- Aussichten für die Entwicklung des industriellen IoT

- Die Geheimnisse einer IoT-Infrastruktur mit einer intelligenten Stadt

- IoT läutet eine neue Ära für die High Street ein

- Die 3 wichtigsten Herausforderungen bei der Aufbereitung von IoT-Daten

- Das Internet der Dinge:Den Datenfluss managen

- Das operative Gehirn:Ein neues Paradigma für intelligentes Datenmanagement im industriellen IoT

- Sind IoT und Cloud Computing die Zukunft der Daten?

- Demokratisierung des IoT