Tools Steigen Sie in der Wertschöpfungskette auf, um das Mysterium aus der Vision KI zu entfernen

Die Vorteile des Hinzufügens von Vision zu alltäglichen Produkten haben die Aufmerksamkeit vieler Branchen und Sektoren auf sich gezogen. Aber wie erhält man eigentlich Daten von einer Kamera, betten maschinelles Lernen in das Gerät ein, um den Inferenzalgorithmus auszuführen, und ermöglichen die Verarbeitung von Nützlichem?

Die Antwort ist wie bei jedem Systemdesign die richtige Software, Tools, Bibliotheken, Compiler usw. Es überrascht nicht, dass solche Fähigkeiten im Allgemeinen außerhalb der Reichweite von Nicht-Ingenieuren liegen. Aber selbst unter Entwicklern von eingebetteten Systemen gelten die Kenntnisse und Fähigkeiten, die für das Design von Bildverarbeitungssystemen erforderlich sind, als Mangelware.

Eine der großen Herausforderungen ist das mangelnde Bewusstsein für die Software und Tools, die für die Entwicklung von Embedded-Vision-Systemen verfügbar sind, wie Jeff Bier, Gründer der Edge AI and Vision Alliance, in einem Briefing mit EE Timesa vor dem Embedded Vision Summit 2021 erklärte . Während erhebliche Investitionen und Forschungen in die Algorithmen und das Silizium getätigt wurden, wurden die Softwaretools, die zwischen ihnen vermitteln – Compiler, optimierte Funktionsbibliotheken usw. – etwas vernachlässigt, sagte Bier.

Die Verwendung der richtigen Softwaretools, Compiler und Bibliotheken kann zu einer sehr effizienten Implementierung eines Algorithmus für einen bestimmten Mikrocontroller oder Prozessor führen. Aber „in den letzten 30 Jahren haben Halbleiterunternehmen in der Regel zu wenig in Softwaretools investiert“, sagte Bier, ein Veteran der Embedded-Systems-Branche und insbesondere der Signalverarbeitung. „[Software] wird oft als notwendigerweise Übel angesehen – sie ist eine Kostenstelle in einem sehr kostensensiblen Geschäft – und das zeigt sich. Als Embedded-Software-Entwickler können Sie die verfügbaren Tools mit denen von PC- oder Cloud-Entwicklern vergleichen und sich wie das ungeliebte Stiefkind fühlen.“

Er brachte dieses Argument auf die nächste Ebene und fügte hinzu:„Sie haben vielleicht Erfahrung mit eingebetteten Systemen, aber es besteht die Möglichkeit, dass diese Entwickler noch nie mit Bilddaten oder tiefen neuronalen Netzen gearbeitet haben.“

Fähigkeiten seien eine große Herausforderung, sagte Bier. „Wir haben vielleicht einige Tabellenkalkulationen durchgeführt und gesagt:‚Ja, es ist möglich, diese Art von tiefen neuronalen Netzwerken mit ausreichender Leistung in unserer Anwendung auszuführen.‘ Aber wissen wir, wie das geht? Haben wir die Fähigkeiten? Für die meisten Unternehmen lautet die Antwort nein, da sie diese Technologie in der Vergangenheit nicht nutzen konnten. Da es sich in der kommerziellen Welt um eine relativ neue Technologie handelt, verfügen sie nicht über das Know-how. Sie haben keine Abteilung für maschinelles Lernen oder Computer Vision in ihrem Unternehmen.

„In den letzten Jahren hat sich dies zu einem wirklich großen Engpass in Bezug auf die kommerzielle Anwendung von Computer Vision und tiefen neuronalen Netzen entwickelt – nur das Know-how.“

Die Technologie wird jedoch immer zugänglicher, da Unternehmen in den letzten Jahren versucht haben, die Qualifikationslücke zu schließen. "Die Wissens- und Qualifikationslücke war ziemlich groß, wird aber kleiner", sagte Bier und fügte hinzu, dass "ein paar Unternehmen", ein großes und ein kleines, "die Verantwortung dafür übernommen haben". Das große Unternehmen ist Intel; der kleine ist Edge Impulse.

„Intel hat mich oft als Gegentrend und bereit, in vielerlei Hinsicht große Investitionen in Softwaretools zu tätigen, beeindruckt“, sagte Bier. „Sie haben zum Beispiel die OpenVINO-Toolkette für Edge Computer Vision und Inference und DevCloud for the Edge. Edge Impulse ist auch eine Cloud-basierte Umgebung. Für einen Embedded-Entwickler fühlt sich [die Cloud-Umgebung] seltsam an. Für sie befindet sich oft alles auf ihrem Schreibtisch – das Entwicklungsboard, die Workstation, die Tools – und sie brauchen nicht einmal eine Internetverbindung. Alles ist sehr lokal. Es fühlt sich sehr seltsam an zu sagen:‚Stellen Sie Ihren Code in die Cloud‘ und führen Sie die Tools in der Cloud aus.“

Der Trend befasst sich sowohl mit der Zeit bis zur Bereitstellung als auch mit der Qualifikationslücke. Eine häufige Frustration für Embedded-Entwickler ist der Zugang zu Boards und Tools und deren ordnungsgemäße Installation, sagte Bier. Die Zeitleiste wird „normalerweise in Wochen, manchmal in Monaten gemessen, und das ist schmerzhaft, besonders wenn Sie am Ende feststellen, dass dies nicht das ist, was Sie brauchen, und Sie den Vorgang mit einigen anderen Boards wiederholen müssen.“ Zum Beispiel könnten Sie am Ende des Prozesses feststellen, dass „Sie die nächste mit höherer Leistung oder einem anderen Satz von E/A-Schnittstellen benötigen“.

Aber wenn der Lieferant „alle Entwicklungsboards in der Cloud mit seinen Maschinen verbunden hat und nach Belieben darauf zugreifen kann, bietet das enormen Komfort. Ebenso haben sie die neuesten Versionen der Softwaretools und sie haben alle Abhängigkeiten zwischen ihnen beseitigt.“

Wegbereiten für die Umsetzung von Visionen

Wie können Sie also die Bereitstellung von Embedded Vision beschleunigen, um Funktionen wie Objekterkennung und -analyse zu ermöglichen, sei es für Smart Cities, Fabriken, den Einzelhandel oder andere Anwendungen?

Nachdem die von Bier beschriebenen Pain Points erkannt wurden, gehen Unternehmen diese an. Einige bieten mittlerweile Tools wie Cloud-basierte Entwicklungssysteme an, mit denen Sie Ihren Code oder Ihre Daten füttern und im Handumdrehen Auswertungen erhalten. Andere bieten Referenzdesigns, mit denen Sie einfach Ihre Kameraausgabe anschließen und aus Bibliotheken oder Apps auswählen können, die Inferenzalgorithmen für gängige Anwendungen bereitstellen.

Im ehemaligen Lager bieten Intel DevCloud for the Edge und Edge Impulse Cloud-basierte Plattformen, die die meisten Schwachstellen mit einfachem Zugriff auf die neuesten Tools und Software beseitigen. Im letzteren Fall haben Xilinx und andere damit begonnen, komplette Systems-on-Module mit produktionsreifen Anwendungen anzubieten, die mit Tools auf einer höheren Abstraktionsebene bereitgestellt werden können, wodurch einige der spezielleren Fähigkeiten überflüssig werden.

Prototyp, Benchmark und Test der KI-Inferenz in der Cloud

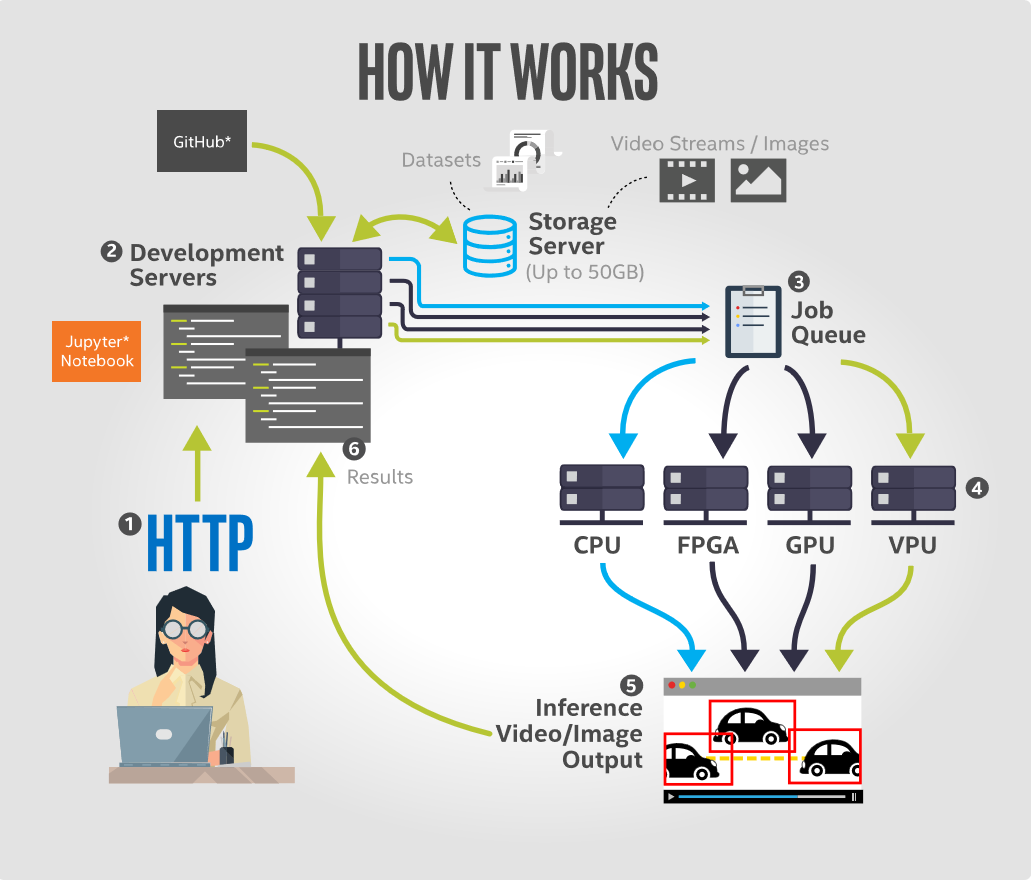

Mit Intel DevCloud for the Edge können Benutzer KI-Inferenzanwendungen auf einer Reihe von Intel-Hardware entwickeln, prototypisieren, vergleichen und testen, darunter CPUs, integrierte GPUs, FPGAs und Bildverarbeitungseinheiten (VPUs). Mit ihrer Jupyter Notebook-Schnittstelle enthält die Plattform Tutorials und Beispiele, die mit allem vorinstalliert sind, was für eine schnelle Inbetriebnahme erforderlich ist. Dazu gehören vortrainierte Modelle, Beispieldaten und ausführbarer Code aus der neuesten Version der Intel-Distribution des OpenVINO-Toolkits sowie andere Tools für Deep Learning. Alle unterstützenden Geräte sind für optimale Leistung konfiguriert und bereit für die Inferenzausführung.

Der größte Vorteil für den Entwickler besteht darin, dass die Plattform keine Hardware-Einrichtung auf der Benutzerseite erfordert. Die browserbasierte Entwicklungsumgebung des Jupyter Notebook ermöglicht es Entwicklern, Code in ihrem Browser auszuführen und die Ergebnisse sofort zu visualisieren. Auf diese Weise können sie Computer-Vision-Lösungen in der Cloud-Umgebung von Intel erstellen und ihren Code auf einer beliebigen Kombination der verfügbaren Hardwareressourcen ausführen.

Dieses cloudbasierte Angebot bietet drei Hauptvorteile. Erstens befasst es sich mit dem Problem der Hardware-Wahllähmung. Entwickler können KI-Anwendungen remote auf einer Vielzahl von Hardware ausführen, um basierend auf Faktoren wie Inferenzausführungszeit, Stromverbrauch und Kosten zu bestimmen, welche für ihre Lösung am besten geeignet ist.

Zweitens bietet es sofortigen Remote-Zugriff auf die neueste Intel Edge-Hardware. Auf der Softwareseite behebt es das Problem des Umgangs mit veralteter Software, da es sofortigen Zugriff auf die neueste Version der Intel Distribution des OpenVINO-Toolkits und kompatible Edge-Hardware bietet.

Und drittens bietet es Zugriff auf anwendungsspezifische Leistungsbenchmarks in einem einfach zu vergleichenden Side-by-Side-Format.

(Ein Tutorial zum Ausführen von Objekterkennungsmodellen mit Intel DevCloud for the Edge ist hier verfügbar.)

Erstellen Sie ein Modell in der Cloud und sehen Sie, was live passiert

Ein anderer Ansatz besteht darin, Daten in eine Cloud-Plattform einzuspeisen, um Trainingsmodelle zu visualisieren und zu erstellen und sie auf eingebetteten Geräten bereitzustellen. Edge Impulse tut genau das und bietet eine Cloud-basierte Entwicklungsumgebung, die darauf abzielt, maschinelles Lernen auf Edge-Geräten einfach hinzuzufügen, ohne dass ein Doktortitel erforderlich ist. beim maschinellen Lernen, so das Unternehmen.

Seine Plattform ermöglicht es Benutzern, vor Ort gesammelte Bilddaten zu importieren, schnell Klassifikatoren zu erstellen, um diese Daten zu interpretieren, und Modelle zurück auf Produktionsgeräte mit geringem Stromverbrauch bereitzustellen. Ein Schlüssel zur Edge Impulse-Webplattform ist die Möglichkeit, alle erfassten Daten anzuzeigen und zu kennzeichnen, Vorverarbeitungsblöcke zu erstellen, um Daten zu erweitern und zu transformieren, den Bilddatensatz zu visualisieren und Modelle auf Trainingsdaten direkt über die Benutzeroberfläche zu klassifizieren und zu validieren.

Da es ziemlich schwierig sein kann, ein Computer-Vision-Modell von Grund auf neu zu erstellen, verwendet Edge Impulse einen Prozess des Transferlernens, um das Trainieren von Modellen einfacher und schneller zu machen. Dabei wird ein gut trainiertes Modell huckepack getragen und nur die oberen Schichten eines neuronalen Netzes neu trainiert, was zu viel zuverlässigeren Modellen führt, die in einem Bruchteil der Zeit trainieren und mit wesentlich kleineren Datensätzen arbeiten. Mit dem entworfenen, trainierten und verifizierten Modell ist es dann möglich, dieses Modell wieder auf dem Gerät bereitzustellen. Das Modell kann dann auf dem Gerät ohne Internetverbindung laufen, mit all seinen inhärenten Vorteilen, wie der Minimierung der Latenz, und läuft mit minimalem Stromverbrauch. Das vollständige Modell ist mit Vorverarbeitungsschritten, neuronalen Netzwerkgewichtungen und Klassifizierungscode in einer einzigen C++-Bibliothek verpackt, die in die eingebettete Software integriert werden kann.

Eine höhere Abstraktionsebene erreichen

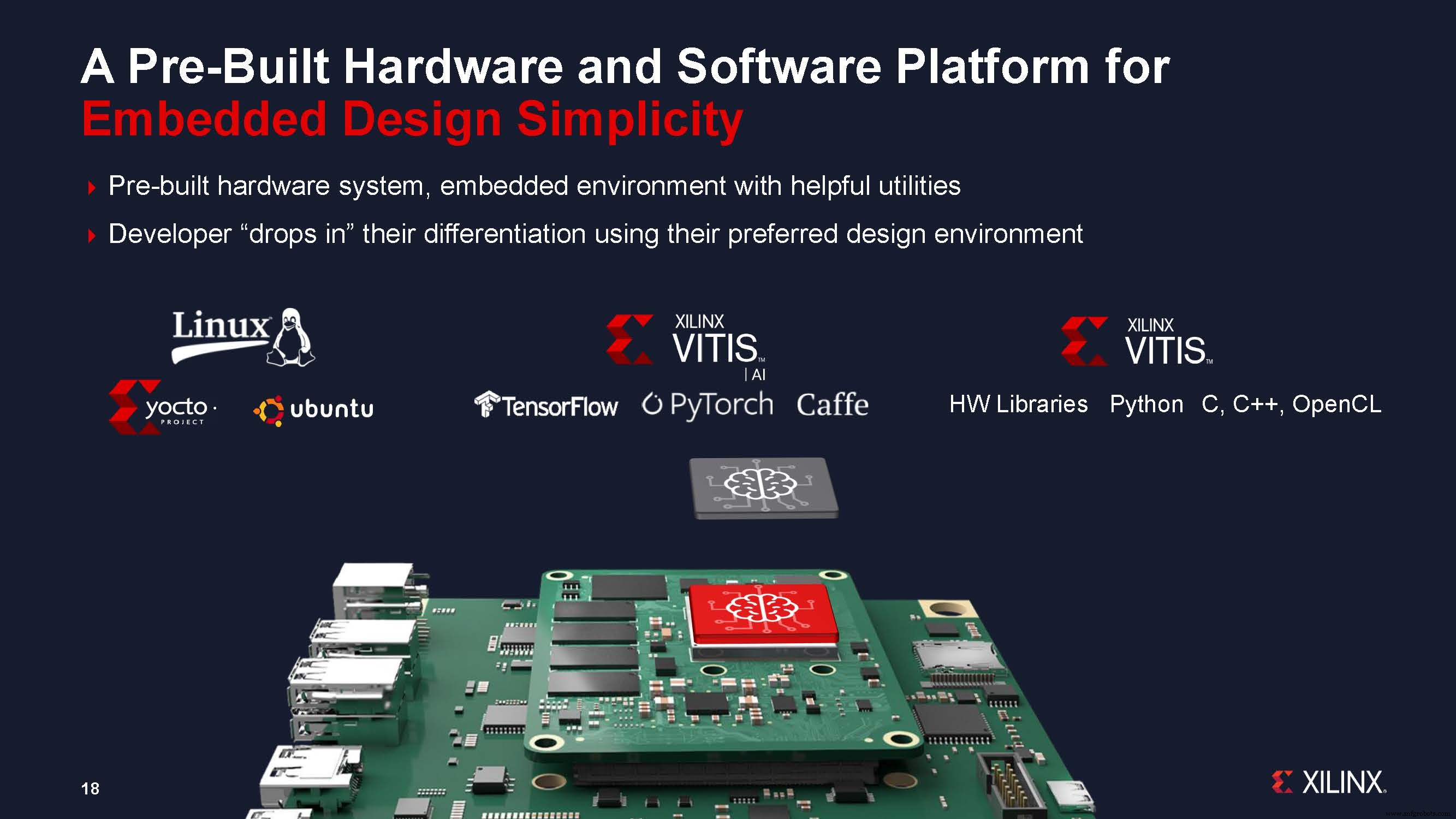

Ein anderer von Anbietern angebotener Ansatz besteht darin, die Entwicklungszeit zu verkürzen, indem sie modulbasierte Systeme anbieten und ein Design auf einer höheren Abstraktionsebene ermöglichen. Xilinx sagte, dass sein neuer Systems-on-Module (SOMs)-Ansatz die Entwicklungszeit für Bildverarbeitungssysteme um bis zu neun Monate verkürzen kann, indem er die steigende Komplexität der Bildverarbeitungs-KI sowie die Herausforderungen bei der Implementierung von KI am Edge angeht.

Xilinx hat kürzlich das erste Produkt in seinem neuen SOM-Portfolio angekündigt:das Kria K26 SOM, das speziell auf Vision-KI-Anwendungen in Smart Cities und Smart Factories ausgerichtet ist, zusammen mit einem sofort einsatzbereiten, kostengünstigen Entwicklungskit, dem Kria KV260 AI Vision Starterkit.

Chetan Khona, Director of Industrial, Vision and Healthcare bei Xilinx, sagte bei der Pressekonferenz zur Einführung der neuen Modulfamilie:„Produktionsreife Systeme sind wichtig für den schnellen Einsatz [von Embedded Vision AI]. Kunden können bis zu neun Monate Entwicklungszeit einsparen, indem sie ein modulbasiertes Design anstelle eines gerätebasierten Designs verwenden.“ Er fügte hinzu, dass Benutzer mit dem Starter-Kit innerhalb einer Stunde loslegen können, „ohne dass FPGA-Erfahrung erforderlich ist“. Benutzer schließen Kamera, Kabel und Monitor an, legen die programmierte microSD-Karte ein, schalten das Board ein und können dann eine beschleunigte Anwendung ihrer Wahl auswählen und ausführen.

Das Kria SOM-Portfolio verbindet die Hardware- und Softwareplattform mit serienreifen Vision-beschleunigten Anwendungen. Diese schlüsselfertigen Anwendungen machen die gesamte FPGA-Hardware-Designarbeit überflüssig; Softwareentwickler müssen nur ihre benutzerdefinierten KI-Modelle und ihren Anwendungscode integrieren und optional die Vision-Pipeline modifizieren – unter Verwendung bekannter Designumgebungen wie TensorFlow-, Pytorch- oder Café-Frameworks sowie der Programmiersprachen C, C++, OpenCL und Python.

Die Kria-SOMs ermöglichen auch die Anpassung und Optimierung für Embedded-Entwickler mit Unterstützung für das standardmäßige Yocto-basierte PetaLinux. Xilinx sagte, dass auch eine Zusammenarbeit mit Canonical im Gange sei, um Ubuntu Linux-Unterstützung bereitzustellen, die sehr beliebte Linux-Distribution, die von KI-Entwicklern verwendet wird. Dies bietet eine breite Vertrautheit mit KI-Entwicklern und Interoperabilität mit bestehenden Anwendungen. Kunden können in beiden Umgebungen entwickeln und beide Herangehensweisen für die Produktion wählen. Beide Umgebungen werden vorgefertigt mit einer Software-Infrastruktur und hilfreichen Dienstprogrammen geliefert.

Wir haben drei der Ansätze hervorgehoben, die Anbieter verfolgen, um die Qualifikations- und Wissenslücke sowie die Bereitstellungszeit für die Entwicklung von Embedded-Vision-Systemen zu schließen. Die Cloud-basierten Ansätze bieten Tools, die die Fähigkeit zum Erstellen und Trainieren von Modellen und zur Evaluierung von Hardware für eine extrem schnelle Bereitstellung auf eingebetteten Geräten „demokratisieren“. Und der Ansatz, der ein Modul oder Referenzdesign mit einer App-Bibliothek bietet, ermöglicht es KI-Entwicklern, vorhandene Tools zu verwenden, um schnell eingebettete Bildverarbeitungssysteme zu erstellen. All dies bewegt uns zu einer anderen Sichtweise auf Entwicklungsboards und -tools. Sie lösen das Mysterium der eingebetteten Vision, indem sie die Wertschöpfungskette nach oben verschieben und die grundlegende Arbeit den Tools und Modulen der Anbieter überlassen.

Ähnliche Inhalte :

- Embedded Vision am Tipping Point

- Fünf Trends bei Embedded Vision und Edge AI

- Werden Maschinen jemals vollständig verstehen, was sie sehen?

- Xilinx SOM zielt auf eine breitere Einführung von Edge-KI und Embedded Vision ab

- Embedded Vision Summit:ML-Wahrnehmung auf winzigen FPGAs

- GWM übernimmt Ambarella AI Vision SoC für neuen SUV

- AImotive zeigt 98% Edge-Vision-Effizienz auf Nextchip Apache5

- Das energiesparende KI-Vision-Board hält mit einer einzigen Batterie "Jahre"

- OmniVision verkleinert den medizinischen Bildsensor für eine tiefere Endoskopie

Eingebettet

- Bildverarbeitungsinspektion:Handwerkszeug

- KI-Anwendungen in der globalen Lieferkette

- Nimm das Rätselraten bei Wartungsentscheidungen ab

- Drew Troyer:Die Wertschöpfungskette der Ausrüstung, Teil 3

- Drew Troyer:Die Wertschöpfungskette der Ausrüstung, Teil 2

- Drew Troyer:Die Wertschöpfungskette der Ausrüstung, Teil 1

- Wird 5G die Vision von 2020 erfüllen?

- Maximierung des Wertes von IoT-Daten

- Der Wert der analogen Messung

- Das Potenzial von KI in der Lieferkette des Gesundheitswesens