Vision und Robotik:Glücklich zusammen

Beim nächsten „dynamischen Duo“ sind möglicherweise überhaupt keine Menschen beteiligt. „Machine Vision und Roboter gehen eine perfekte Verbindung ein“, sagte Klas Bengtsson, Global Product Manager, Vision Systems bei ABB Robotics (Auburn Hills, MI). Das ist nicht neu. Vision und Robotik gehen seit Jahren Hand in Hand. Aber im Gegensatz zu anderen Ehen gedeiht diese, da die maschinelle Bildverarbeitung ihre Fähigkeiten erweitert und neue Anwendungen findet. Die „perfekte“ Ehe der Vergangenheit bestand darin, den Roboter zu führen. Aber neue Anwendungen – wie Kinder aus einer guten Ehe – umfassen jetzt die Inspektion von Teilen, das Lesen von Strich- oder QR-Codes für die Rückverfolgbarkeit und das Finden neuer Wege zum Ein- und Auspacken von Teilen.

Es läuft alles auf die Flexibilität hinaus, die maschinelles Sehen bietet . „Vision hat ABB geholfen, die Fähigkeiten vieler Roboteranwendungen zu verbessern“, sagte er.

Der Bedarf an flexibel geführten Robotern wurde durch die zunehmende Produktvielfalt und die Notwendigkeit, die Vorlaufzeiten in vielen Branchen zu verkürzen, vorangetrieben. Warum ist Flexibilität so wichtig? „Wenn Sie die Roboterautomatisierung fest codieren, müssen Sie in dem Moment, in dem Sie ein Produkt oder etwas in Ihrer Produktionslinie ändern, das Programm ändern“, sagte Bengtsson. Dies bedeutet auch, die Präzisionshalterung oder die Art und Weise, wie ein Teil platziert wird, zu ändern, damit ein fest codiertes Roboterführungsprogramm das Teil zuverlässig aufnehmen, polieren oder anderweitig bearbeiten kann. Die Kosten summieren sich.

Machine Vision hilft, diese Kosten einzudämmen, indem es dem Roboter ermöglicht, Variationen in Teilen und Ausrichtung zu „sehen“. 3-D-Scanning-Sensoren eröffnen noch mehr neue Anwendungen. Bengtsson sagte:„Vor 15 Jahren lautete die Frage ‚Warum maschinelles Sehen?‘ Die Frage heute lautet:‚Warum nicht?‘“

Menschen und Roboter arbeiten zusammen

Rethink Robotics (Boston), gegründet 2008, baut kollaborative Roboter oder Cobots. Sein Hauptprodukt ist Sawyer. „Ein Cobot wie unser Sawyer-Roboter eignet sich am besten für sich wiederholende, alltägliche Aufgaben im menschlichen Maßstab“, sagte Mike Fair, Produktmanager. Das bedeutet, mit Produkten oder Bewegungen zu arbeiten, die das nachahmen, was ein Mensch tut, was auch betäubend repetitiv und banal ist.

„Anwendungen wie diese umfassen Verpackung, Maschinenbeschickung, Linienbe- und -entladung, Inspektion und Prüfung von Leiterplatten“, sagte er. Die Materialhandhabung für CNC-Maschinen ist eine weitere Anwendung, die einen Menschen ersetzt, der eine CNC-Maschine belädt, einschaltet, auf das Ende der Bearbeitungsaufgabe wartet und dann die Maschine entlädt.

Rethink glaubt so sehr an maschinelles Sehen, dass es eingebettet ist eine Kamera im Handgelenk jedes Sawyers. „Das eingebettete Bildverarbeitungssystem [macht] unseren Cobot schneller und einfacher einzusetzen, wodurch der Aufwand und die kostspielige Integrationszeit typischer Bildverarbeitungssysteme entfallen. Wir fügen Software hinzu, um die Bereitstellung [dieser] Bildverarbeitungssysteme zu vereinfachen“, sagte Fair. Auf der Messe ATX West 2018 demonstrierte er, dass selbst ein Journalist eine einfache Aufgabe in wenigen Minuten programmieren kann. In Verbindung mit codierten Aufklebern, die wie QR-Codes aussehen, hilft ihre Software dem Roboter, sich selbst zu positionieren, um sich an die Variabilität in der Arbeitszelle anzupassen. Dies erleichtert auch das Bewegen von Sawyer-Robotern von Aufgabe zu Aufgabe und von Ort zu Ort.

Universal Robots USA Inc. (UR; Ann Arbor, MI) widmet sich ebenfalls kollaborierenden Robotern. Seine drei Roboter mit Traglasten von 3 bis 10 kg arbeiten in einem „Ökosystem“ von Drittanbietern. Es bietet ein kostenloses Entwicklerprogramm namens Universal Robots+ an, mit dem Drittanbieter von Endeffektoren, Bildverarbeitungssystemen und anderen Peripheriegeräten Add-Ons entwickeln können, die mit seinen Cobots Plug-and-Play-fähig sind.

Die Website des Unternehmens zeigt sechs verschiedene Sichtoptionen dieses Ökosystems, die für Pick-and-Place, CNC-Maschinenautomatisierung, Verpackung und Palettierung, Montage, Schrauben und Maschinenbestückung geeignet sind. Es stehen sowohl 2D- als auch 3D-Scanner zur Verfügung. Es sind mehrere Roboter-Bewegungssteuerungs- und Simulationssoftwarepakete verfügbar.

Integration, Benutzerfreundlichkeit

Damit maschinelles Sehen nützlich ist, muss es zugänglich sein, ein wichtiges Element des Ökosystems von UR. Beispielsweise heißt eines ihrer Drittanbieterpakete Universal Metrology Automation, das von 3D Infotech angeboten wird. Es bietet die Integration von Bewegungssteuerungssystemen, 3D-Scannern und Inspektionssoftware, um eine konfigurierbare, automatisierte Messlösung zu erstellen. Andere Programme bieten Online- oder Offline-Programmierung, Robotersimulationssoftware und Überwachungsfunktionen.

„Heute gibt es eine viel bessere Integration mit Robotern und Bildverarbeitungssystemen“, sagte Rob Antonides, Präsident von Apex Motion Control (Surrey, BC). Apex ist ein Integrator, der den Ökosystem-Ansatz von UR voll ausgenutzt hat. „Früher mussten wir Bildverarbeitungssysteme mit Robotersteuerungen zusammenhacken, aber heute sind sie nahtloser Plug-and-Play, über Ethernet IP oder jede Art von Netzwerk. Vor zwanzig Jahren brauchte ich eine Woche, um ein sichtgesteuertes Robotersystem und die Kommunikation einzurichten; heute sind es 15–20 Minuten.“

Machine Vision hat sich für Apex als besonders nützlich erwiesen. Zu den automatisierten Aufgaben gehören eine Vielzahl von Backvorgängen, einschließlich des Dekorierens von Kuchen. „Bildverarbeitungssysteme ermöglichen es Ihnen, mit Inkonsistenzen und nicht ganz perfekter Präsentation und Positionierung des Produkts umzugehen. Wir bilden die Oberfläche eines Kuchens mit einem 3D-Sensor ab, damit wir ihn schnell und einfach dekorieren können“, sagte Antonides.

FANUC betont auch die einfache Integration. „Wir haben Ende letzten Jahres einen brandneuen Controller herausgebracht, der herausragende Funktionen für integriertes Robotic Vision bietet“, erklärt David Dechow, Staff Engineer – Intelligent Robotics/Machine Vision bei FANUC America Corp. (Rochester Hills, MI). „Bei FANUC sind jetzt alle unsere Bildverarbeitungssysteme in die Steuerung eingebettet.“ FANUC war eines der ersten Roboterunternehmen, das Vision für die Führungsrobotik einsetzte und es vor 30 Jahren als Option in seinen Roboterführungssystemen anbot.

Dechow beobachtete auch, dass sich Unternehmen für maschinelles Sehen darauf konzentriert haben, einfachere Schnittstellen mit Robotern zu entwickeln. „Die Vision-Anbieter unterstützen diesen Markt spürbar“, stellte er fest. „Die schwere Arbeit, um die Zusammenarbeit zum Laufen zu bringen, liegt auf der Visionsseite. Der Roboter erwartet einen Punkt. Der Trick besteht darin, mithilfe von Bildverarbeitung den richtigen Punkt zu finden, indem das Koordinatensystem des Bildverarbeitungssystems mit dem Koordinatensystem des Roboters zusammengeführt wird.“ Er war sich mit anderen Interviewpartnern für diesen Artikel einig, dass Bildverarbeitung bei vielen Automatisierungsaufgaben eine unvergleichliche Flexibilität bietet. Heutzutage beginne das Kosten-Nutzen-Verhältnis, Visionen gegenüber Präzisionsbefestigungen und Hardcoding zu bevorzugen, sagte er.

KI:Posing und Diskriminierung

Eine Diskussion über Vision, Daten und Roboter führt natürlich zu der Frage, wie nützlich künstliche Intelligenz (KI) für sehende Roboter wäre. Dechow bemerkte einen Haken:KI ist nicht besonders auf die Roboterführung anwendbar. „KI-Lernen ist außergewöhnlich gut beim Kategorisieren und Differenzieren. Worin es nicht gut ist, ist die diskrete Analyse“, erklärte er. Ein Roboter muss sich zu einem diskreten Punkt bewegen. In Kombination mit Metrologiesystemen misst es diskrete geometrische Größen. „Da gibt es nichts zu lernen“, sagte er.

Aber das ist noch nicht alles. Wenn dies nicht auf die Führung anwendbar ist, gibt es Roboteraufgaben, bei denen KI einen Mehrwert bietet. „Zum Beispiel wäre das Identifizieren und Klassifizieren eines Objekts vor seinem Hintergrund, um das Objekt zu bestimmen, an dem der Roboter arbeiten soll, in Kombination mit einer Roboterführung eine gute Hybridanwendung“, sagte er. Ein weiterer ist die Pick-and-Grip-Optimierung. „Das Finden der idealen Ausrichtung des Arms im Raum und des Annäherungspfads fällt eher in einen Lernbereich als [sei] deterministisch. Es gibt viele Ausrichtungen, die sowohl gut als auch schlecht sind“, erklärte er. „KI ist besonders nützlich, wenn Teile zufällig und in Platzierung und Größe nicht homogen sind.“

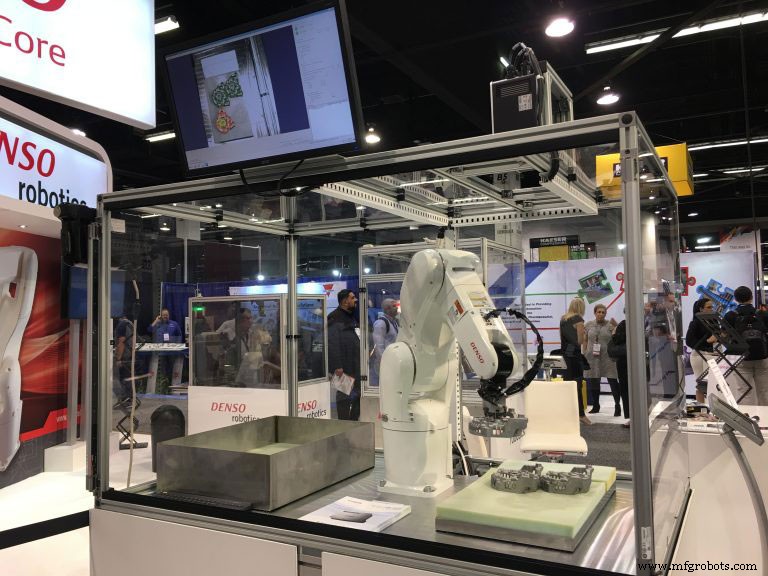

Peter Cavallo von Denso Products and Services Americas Inc. (Long Beach, CA) stimmte zu, dass die erhebliche Steigerung der Leistungsfähigkeit von Bildverarbeitungssystemen real ist und neue Möglichkeiten für Roboteranwendungen eröffnet hat. „In seiner einfachsten Form findet [Vision] ein Teil oder Objekt und bearbeitet es. In seiner komplexesten Form, die wir jetzt sehen, kann es Dinge sehen, interpretieren, erkennen und das Teil als das sehen, was es ist – sogar in verschiedenen Konfigurationen oder Positionen – ohne das Teil oder den Roboter zu bewegen.“

Er sieht das 3D-Scannen als eine besonders wichtige Entwicklung, Erleichtern Sie bisher schwierige Aufgaben wie den Griff in die Kiste. Das neueste System von Denso verwendet ein strukturiertes Licht-Vision-System, um mit einem CMOS-Detektor in 3D zu sehen.

Seine Sicht der Anwendung von KI auf die Robotik basiert auf einem breiteren Systemkontext. „Während wir uns der nächsten Generation von Robotern zuwenden, fangen wir an, uns mit Dingen wie Deep Learning zu befassen, bei denen das Sehen Teil eines ganzen Systems wird“, erklärte er. „Wir haben auf der Robotermesse in Tokio etwas gezeigt, das Deep Learning in einem System mit 28 Freiheitsgraden zeigte, das zwei Roboter mit Händen umfasste, die einen Salat zusammenstellten.“ Warum sollten industrielle Anwender beeindruckt sein? Der Roboter wählte Salat, Obst und Gemüse nur anhand des zuvor bereitgestellten Wissens aus. „Wir haben den Roboter nicht programmiert; Stattdessen haben wir ihm gesagt, was wir wollten“, sagte er. Denken Sie an die Anzahl der unstrukturierten Aufgaben in der Fertigung, die ideal für eine solche Automatisierung wären.

Nicht nur für die Großen

Machine Vision, Integration, Software und sogar KI lassen einen denken, dass dieses Niveau der Roboterautomatisierung nur etwas für Fortune-500-Unternehmen ist. Das ist nicht der Fall. „Es eignet sich sehr gut für kleine und mittelständische Unternehmen, da die Bildverarbeitung heute vertretbar ist. Was früher 50.000 bis 100.000 US-Dollar betrug, ist jetzt weniger als 5000 US-Dollar. Es gibt keinen Grund, schüchtern zu sein“, sagte Cavallo.

Rick Brookshire, Produktmanager bei Epson America Inc. (Carson, CA), stimmte zu, dass Roboterautomatisierung ideal für kleine und mittlere Unternehmen (KMU) ist. „Neben größeren Kunden, die 50, 100 oder sogar 1000 Roboter kaufen, haben wir viele kleinere Kunden, die einen, zwei oder drei Roboter kaufen“, sagte er. Epson ist auf kleinere Roboter spezialisiert, die für Hochpräzisionsaufgaben optimiert sind, und baut sein Robotergeschäft aus eigenem Bedarf beim Bau von Hochpräzisionsuhren aus. „Alle unsere Roboter sind mit integrierter Sichtführung erhältlich, eine Funktion, die zunehmend akzeptiert wird. Es wird auch immer zuverlässiger. Die Leute sind eher bereit, es zu nutzen“, sagte er.

Wie andere, die für diese Geschichte interviewt wurden, glaubt er an Einfachheit ist von entscheidender Bedeutung – insbesondere, um den Bedürfnissen von KMU gerecht zu werden. Das Epson Vision Guide-Programm verwendet eine objektbasierte Point-and-Click-GUI-Schnittstelle, die es Entwicklern ermöglicht, Anwendungen schnell zu entwickeln, so das Unternehmen. Während die ideale Vision-geführte Roboteranwendung etwas ist, bei dem Teile nicht gut innerhalb eines angemessenen Toleranzniveaus positioniert sind oder nicht in einer konsistenten Weise präsentiert werden können, eröffnet die Präzision, die Epson-Roboter bieten, einen weiteren Anwendungsbereich.

Toleranzen werden immer enger. Teile werden kleiner. Die präzise Platzierung wird immer schwieriger. „Hier können Präzisionsroboter wie die von Epson helfen“, sagte er. „Das passiert immer mehr in kleineren Unternehmen. Und diese Roboter sind so einfach zu bedienen, dass viele unserer Kunden die Integration selbst vornehmen.“ Selbst Schrauben mit einem Durchmesser von weniger als 0,7 mm setzen die Roboter ein. Mit zunehmendem Alter der Belegschaft kann dies zu einem kritischen Faktor werden.

James Cooper, Vice President of Sales bei Applied Manufacturing Technologies (AMT; Orion, MI), hat aufgrund seiner Erfahrung in der Automobilindustrie eine einzigartige Perspektive. AMT ist ein Systemintegrator, der sich auf bildverarbeitungsgeführte Robotersysteme spezialisiert hat. Mehrere Teilenummern mit komplexen Systemen, wie beispielsweise in Getriebegehäusen, werden immer häufiger. Ein Getriebegehäuse ist ein großes Objekt mit vielen Löchern und komplexen Oberflächen – ideal für die Sicht, aber teuer für eine präzise Festbefestigung. „Auch die Losgrößen werden durch häufigere Umstellungen kleiner. Deshalb werden robotergeführte Bildverarbeitungssysteme in vielen Anwendungen so wichtig.“ Er beobachtete auch das Wachstum von 3D-Vision-Systemen, insbesondere bei Anwendungen zur Behälter- und Behälterkommissionierung.

Es geht über die Führung hinaus. „Die Qualitätsprüfung ist eine ideale Anwendung, um nach Vorhandensein und Fehlen von Löchern und anderen Merkmalen zu suchen oder festzustellen, ob eine Komponente richtig zusammengebaut wurde“, sagte er. Ein weiteres reichhaltiges Gebiet ist die messtechnische Inspektion. „Wir haben mit unserem Partner Hexagon ein System gebaut, das auf einem kollaborativen Roboter basiert, der das Produkt eines Kunden inspiziert. Früher erfolgte dies auf einem KMG in einem separaten temperierten Raum. Viele Jahre lang wollten die Hersteller dies in der Produktionshalle tun. Es ist jetzt möglich, ein vollständig tragbares System ohne Schutzvorrichtungen zu haben, das sich ideal für Erstmusterprüfungsanwendungen direkt an der Produktionsmaschine eignet“, sagte er.

Er stimmte zu, dass diese Anwendungen in KMU zunehmen. Er merkte auch an, dass diese Betriebe Schwierigkeiten haben, qualifizierte Arbeitskräfte zu finden, was den Bedarf an mehr Automatisierung erhöht.

ABB hat in Zusammenarbeit mit NUB3D (das später übernommen wurde), einem führenden Innovator von digitalen 3D-Inspektions- und Qualitätskontrolllösungen, auch ein Roboterprüfsystem entwickelt. Das schlüsselfertige System besteht aus einem 3D-Weißlicht-Scansensor, der am Arm eines ABB-Roboters montiert ist.

Stäubli Corp. (Duncan, SC) is a robot company that uses a variety of machine vision from third-party vendors to build applications for robot vision guidance. But it also offers another use of vision systems with industrial robots that need human interaction:a virtual safety fence around robots.

As explained by Olivier Cremoux, business development manager, North America robotics for Stäubli, man/robot collaboration can be binned into five different stages. The lowest stage 1, common in most industrial robots, is no direct contact, where any interaction between man and machine is dangerous. “The robot and operator are separated by hard fences,” he said. The highest, stage 5, is where contact is desired and required, for example when a robot is hand guided by an operator to carry out or assemble a heavy tool or other simultaneous motions with a robot. There are stages in-between where some contact is desired at different levels, and where the robot often needs to stop and let the human do something. “This in-between represents 95% of collaborative applications,” he said.

In these intermediate stages, a 3D scanning vision system that scans outwards from the workcell can detect a human approaching. Within a certain distance, it signals the workcell to slow the robot down to prevent contact and possible injury. As the human approaches even closer, it stops the cell entirely. This allows the human to perform an action, such as inspection or placement, then move away, allowing the cell to automatically restart.

HNJ Solutions Inc. (Carson, CA) is an integration company founded to provide vision systems for manufacturing, including with robots, according to President Greg McEntyre. While acknowledging that vision systems are indeed becoming easier to use and install, he says there remains a class of applications where integrators like HNJ are needed. “In complex applications with multiple colors, sizes, orientations, and general uncertainty, it is important to know how cameras work and why they work to install a good system,” he said.

He emphasized how 3D cameras are expanding relevant applications, such as bin picking. “Today we are even importing the CAD model of our objects so that the vision system can understand in 3D the object it needs to pick or operate on,” he said. “Cameras give complete freedom.”

What advice might he offer, as an integrator of complex vision and robotics? “While it may not be easy as it looks, I would say just jump in,” he said. “There is so much useful hardware that vision guidance and vision applications are becoming ever more useful.” In other words, just do it.

Automatisierungssteuerung System

- Vor- und Nachteile einer Drehmaschine

- Fanuc eröffnet neue Robotik- und Automatisierungsanlage

- ABB und B&R bringen „erste vollständig integrierte maschinenzentrierte Robotiklösung“ auf den Markt

- SICK präsentiert Webinar zur kundenspezifischen Bildverarbeitung

- Elementary Robotics sammelt 13 Millionen US-Dollar für seine Angebote für maschinelles Lernen und Computer Vision für die Industrie

- Die Rolle von Robotik und Automatisierung in Industrie 4.0

- Antriebe und Maschinensicherheit

- Sicherheitsvorrichtungen und Überlegungen

- ABB Robotics:Technologieinnovation und Robotik-F&E

- Besser zusammen:Maschinisten und Programmierer