Vision-geführte Robotik

Teil I

Der Treiber der Digitalisierung ist die wachsende Nachfrage nach Genauigkeit, verbesserter Qualität und Zuverlässigkeit. Die Marktdynamik hat die Fertigungsindustrie gezwungen, neue Produkte, modifizierte Designs, um den sich ändernden Verbraucherstimmungen, Anpassungen und schnelleren Lieferungen gerecht zu werden. Roboter sind seit Jahrzehnten die Freunde der Fertigungsindustrie, ebenso wie „Machine Vision“ schlechthin.

Robotik und Bildverarbeitung haben unabhängig voneinander Stabilität und technologische Reife erlangt. Die jüngsten Entwicklungen haben sich eher gegenseitig ergänzt, um Prozesse effizienter zu gestalten. Dieser Artikel erläutert einige Einblicke in die sichtgesteuerte Robotik (VGR) im Fertigungsbereich. Obwohl VGR für andere Robotertypen wie mobile Roboter, Humanoide, kartesische und SCARA-Roboter gleichermaßen relevant ist, werden wir uns auf die Anwendungen und Herausforderungen von Gelenkrobotern konzentrieren .

Bevor wir tief in unser Kernthema einsteigen, ist es wichtig, einige wichtige Konzepte der Bildverarbeitung und Industrieroboter zu verstehen.

Maschinelles Sehen kann als die Atomisierung des menschlichen Sehens definiert werden. Es muss nicht nur ein Bild aufnehmen (die Funktion unserer Augen), sondern diese Bilder auch verarbeiten und Ergebnisse generieren (die Funktion des Gehirns). Bildverarbeitungssysteme verlassen sich auf digitale Sensoren, die in Industriekameras mit speziellen Optiken geschützt sind, um Bilder zu erfassen, sodass Computerhardware und -software verschiedene Merkmale für die Entscheidungsfindung verarbeiten, analysieren und messen können.

Typische Bildverarbeitungsanwendungen können grob in vier Typen eingeteilt werden, nämlich:

- Anleitung

- Identifikation

- Messung

- Inspektion

Während Aufgaben wie Identifikations-, Mess- und Inspektionssysteme ihre eigenen Zwecke haben, bei denen Roboter der Anwendung einen Mehrwert verleihen, liegt unser Fokus in diesem Artikel auf der Roboterführung . Bildverarbeitungssysteme (MV) können ein Teil lokalisieren und sicherstellen, dass es korrekt in einer bestimmten Baugruppe platziert wird. MV-Systeme können auch dabei helfen, die Position einer Komponente im 2D- oder 3D-Raum zu identifizieren, und Roboter dabei unterstützen, die Koordinaten dieser Komponente genau zu verfolgen. MV-Systeme reduzieren die Komplexität der für diesen Zweck erforderlichen Vorrichtungen. Um dies zu verstehen, müssen wir zunächst untersuchen, wie sich ein Roboter positioniert, um die Komponente zu lokalisieren.

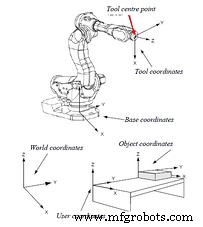

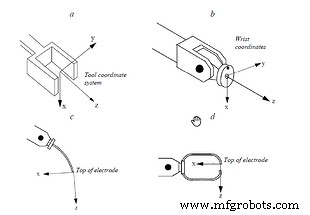

Ein Roboterkoordinatensystem besteht aus verschiedenen Bezugsrahmen. Die wichtigsten Koordinatensysteme, die zur Beschreibung der Bewegung eines Roboters verwendet werden, sind unten in Abbildung 1.1 dargestellt . Die Steuerung des Greifers oder des Werkzeugs steht im Vordergrund und seine Position wird durch koordinierte Bewegungen einer oder aller Roboterachsen erreicht. Da verschiedene Arten von Greifern und Werkzeugen unterschiedliche Abmessungen haben, wird unabhängig vom Werkzeugtyp ein spezieller Punkt ausgewählt, der als Tool Center Point (TCP) bezeichnet wird. Dieser Punkt ist der Ursprungspunkt des Werkzeugkoordinatensystems. Ein ähnlicher Punkt kann verwendet werden, um das Greifer- oder das Handgelenkkoordinatensystem zu beschreiben. Die gegenseitigen Verbindungen eines Werkzeugs, eines Handgelenks und anderer Koordinatensysteme sind in Abbildung 1.2 dargestellt .

Abbildung 1.1

Abbildung 1.2

Bilder:ABB Robotics

Der TCP steht in Beziehung zu den Handgelenkskoordinaten, Basiskoordinaten, Weltkoordinaten und den Objektkoordinatensystemen. Im Idealfall wird erwartet, dass die Koordinaten des Objekts genau übereinstimmen mit den eingestellten Koordinaten des TCP – das heißt, der Nullpunkt des Objekts wird dem Roboter per Programmierung eingelernt und die TCP-Koordinaten erfasst. Um wiederholte Genauigkeit zu erreichen, müssen der Roboter und das Objekt daher jedes Mal am selben Punkt ankommen.

Die Roboterpositionierung wird von Servomechanismen gesteuert und ist daher ziemlich genau. Bei fest angeordneten Komponenten hängt ihre Positioniergenauigkeit von einer Reihe von Faktoren ab, wie z. Daher stimmt der TCP des Roboters aufgrund des Versatzes zwischen seinen gewünschten und tatsächlichen Koordinaten möglicherweise nicht mit den tatsächlichen Koordinaten des Objekts überein, und es kommt zu einem Positionierungsfehler. Wenn erwartet wird, dass der Roboter das Objekt aufnimmt oder irgendeine Operation daran ausführt, während das Objekt zufällig über einem Förderband positioniert wird, dann wird es so gut wie unmöglich, seinen Ursprung zu bestimmen wenn es kein System wie maschinelles Sehen gibt, um es zu führen.

Wenn sie eingesetzt werden, können Bildverarbeitungssysteme die Echtzeitkoordinaten des Objekts identifizieren und sie dem Roboter zuführen, der dann den Versatz im TCP kompensiert. Dadurch wird die Genauigkeit der Werkzeugpositionierung sichergestellt. Dieses Verfahren wird hauptsächlich für Anwendungen wie Schweißen und Klebstoffauftrag, für Vorrichtungskomponenten und für das robotergestützte "Pick and Place" von zufällig verteilten Objekten auf einem sich bewegenden Förderband verwendet. Die obigen Beispiele gelten für Objekte mit Positionierungsungenauigkeiten entlang der 2D-Ebene, also ein 2D-Bildverarbeitungssystem verwendet werden.

Hochgeschwindigkeits-Roboter-"Pick-and-Place" von Objekten mit 2D-Sichtführung. Bild:Cognex Corporation

Für Anwendungen wie das robotergesteuerte „Griff in die Kiste“, bei denen erwartet wird, dass der Roboter zufällig in einem Behälter aufbewahrte Objekte aufnimmt, wird eine räumliche 3D-Analyse erforderlich. Hier sind nicht nur die X-, Y- und Z-Koordinaten wichtig, sondern auch die Orientierungswinkel entlang aller drei Achsen sind entscheidend, damit der Roboter das am einfachsten zu greifende Objekt ohne Kollisionen identifiziert. Es liegt auf der Hand, dass 3D-Bildverarbeitungssysteme werden in dieser Einstellung eingesetzt.

Das beliebteste 3D-Machine-Vision-System ist ein Setup, das Stereovision mit zwei Kameras verwendet, die Koordinaten und die Höhenkarte liefern. Die entscheidende Aufgabe hierbei ist die Kamerakalibrierung und der Bildverarbeitungsalgorithmus, der die Bilder beider Kameras kombiniert und ein 3D-Bild erstellt. Ein Bild des Behälters wird analysiert, um die TCP-Koordinaten der am einfachsten zu entnehmenden Komponente abzuleiten. Einige andere 3D-Techniken sind Lasertriangulation und Flugzeit.

Roboter-Griff in die Kiste mit 3D-Sichtführung. Bild:Yaskawa Robotics

Roboter-Griff in die Kiste mit 3D-Sichtführung. Bild:Yaskawa Robotics

Teil II

Bildaufnahme

Eine gute Bildqualität ist der Schlüssel für eine erfolgreiche VGR. Die drei Hauptkomponenten hier sind Kamera, Optik und Beleuchtung.

Kamera: Bei der Auswahl von Kameras für Roboteranwendungen sind einige wichtige Dinge zu beachten. Obwohl kommerzielle Kameras auf dem Markt Bilder erfassen, können die industriellen Umgebungen, in denen diese Systeme eingesetzt werden, wirklich herausfordernd sein. Hier sind die Kameras rauen Umgebungen ausgesetzt und es wird erwartet, dass sie jedes Mal über Hunderttausende von Zyklen konsistente Bilder in guter Qualität liefern. Hinzu kommen die Erschütterungen und Vibrationen, die durch Roboterbewegungen und die Vibrationen der gesamten Ausrüstung entstehen.

Die Kommunikationsschnittstellen müssen robust sein und diesen harten Bedingungen standhalten, damit es während des Betriebs zu keinen Kommunikationsunterbrechungen kommt. Ethernet-basierte Protokolle bieten eine gute Zuverlässigkeit und längere Kabellängen, die für diese Anwendung erforderlich sind Die Einhaltung des Eindringschutzes wird besonders wichtig, wenn das System in einer staubigen Umgebung eingesetzt wird. PoE ist eine bevorzugte Stromquelle, um mehrere Kabel zu vermeiden. Die Kamerakabel werden daher durch Kabelkanäle und Kabelbäume am Roboterarm einer starken zyklischen Biegung ausgesetzt Es sollten schleppkettentaugliche Kabel verwendet werden.

Bild:Baumer

Bild:Baumer

Bild:Pickit 3D

Bild:Pickit 3D

Die Auflösung der Kamera muss unter Berücksichtigung des gesamten Sichtfelds (FOV) und der gewünschten Positionierungsgenauigkeit berechnet werden.

Optik: Je nach FOV, Arbeitsabstand (WD) und Kamerasensorgröße muss eine geeignete Optik ausgewählt werden. Die beiden wichtigsten zu berücksichtigenden Faktoren sind:

- Die tonnenförmige Verzeichnung sollte so gering wie möglich gehalten werden, und

- Die Robustheit des Objektivs, da es der gleichen Menge an Stößen und Vibrationen ausgesetzt ist wie die Kamera; wichtige Objektiveinstellungen wie Blende und Fokus können beeinträchtigt werden, wenn sie nicht berücksichtigt werden

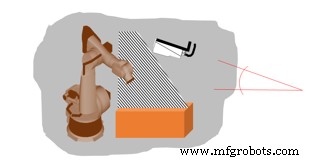

Beleuchtung: Die Beleuchtung des Objekts spielt bei der VGR eine entscheidende Rolle. Die Beleuchtung sollte so sein, dass sie das zu prüfende Merkmal im Bauteil hervorhebt. Das zu programmierende Bauteil bzw. die zu programmierende Kontur muss innerhalb der gewünschten Genauigkeit des Systems genau identifiziert werden. Daher muss basierend auf dem Objekt und der Kontur eine geeignete Beleuchtung ausgewählt werden. Während die Komponentenentnahme oder Schweiß-/Klebstoffauftragsanwendungen meistens einfache diffuse Balkenlichter erfordern, verwenden die Roboteranwendungen zur Aufnahme in die Kiste, die Stereokameras verwenden, häufig strukturierte Musterlichter, die auf die Komponente projiziert werden, um Konturen zu erfassen und Profile abzuleiten.

Strukturierte Beleuchtung beim 3D-Griff in die Kiste. Bild:Solomon 3D

Herausforderungen in der Robotik mit Machine Vision

In einer standardmäßigen 2D-Roboter-Machine-Vision-Anwendung gibt es mehrere Herausforderungen, die angegangen werden müssen:

- Verzerrungen

- Koordinatenkalibrierung

- Z-Kalibrierung

- Koordinatenausrichtung

Verzerrungen: Es gibt zwei Haupttypen von Verzerrungen, die auftreten und korrigiert werden müssen, bevor das Bildverarbeitungssystem für die VGR bereit ist.

- Linsenverzerrungen: Objektive (insbesondere Weitwinkelobjektive) verursachen Verzerrungen im aufgenommenen Bild. Dies wird als „Tonnenverzerrung“ bezeichnet.

Tonnenverzerrung. Bild:Baumer

- Verzerrungen durch schräge Montage der Kamera

Bild:Baumer

Bild:Baumer

Roboter benötigen zum Betrieb einen Freiraum, daher müssen Kameras oft in einer geneigten Position montiert werden. Dies führt zu Verzerrungen im aufgenommenen Bild.

Beide Arten von Verzerrungen müssen korrigiert und kalibriert werden, damit die erfassten Koordinaten genau sind.

Koordinatenkalibrierung: Roboter arbeiten mit Koordinatensystemen, die in Einheiten wie Millimetern oder Zoll definiert sind, während Kameras mit Pixelzahlen arbeiten. Daher ist es erforderlich, die Kamera zu kalibrieren, damit das System die Korrelation zwischen Pixeln und den Einheiten der Koordinatensysteme versteht.

Bild:Baumer

Bild:Baumer

Wichtig ist, dass die Messung immer im gleichen Arbeitsabstand (Abstand zwischen Kamera und Objekt) erfolgt. Da Roboter in 3D arbeiten, erfordert auch das „Greifen“ eine „Z“-Angabe .

Z-Kalibrierung: Die Z-Kalibrierung wird zur Berechnung der X- und Y-Koordinaten verwendet, wenn die Z-Achse innerhalb der Schärfentiefe* des Objektivs variiert. Die Kamera wird nach einem bestimmten Verfahren mit der Kalibrierplatte kalibriert (wird später besprochen).

Koordinatenausrichtung: Der Roboter und das Bildverarbeitungssystem haben ihre eigenen Koordinatensysteme. Ihre Abweichungen sind:

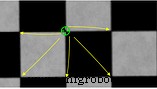

Um dieses Problem zu lösen, wird eine Kalibrierung durchgeführt. Der Roboter kennt seine eigene Position und auch die Position des TCP, während das Vision-System auf einer Kalibrierplatte kalibriert wird. Der Roboter berechnet die Offsets , und die Ausrichtung wird durchgeführt.

Dies ist ein sehr wichtiger Schritt. Der Roboter muss dem Pfad folgen, der vom Ursprungspunkt ausgeht, der vom Bildverarbeitungssystem definiert wurde. Wenn er nicht richtig ausgeführt wird, kann eine falsche Kalibrierung schwerwiegende Pfadabweichungen verursachen und die Folge sein bei Kollisionen.

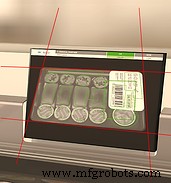

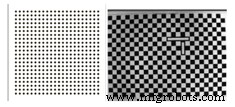

Kalibrierplatte: Die Kalibrierung des Bildverarbeitungssystems wird unter Verwendung einer Standardkalibrierungsplatte durchgeführt, die Markierungen mit genauen Abmessungen aufweist. Abbildung 2.1 zeigt einige Beispiele von Kalibrierplatten.

Abbildung 2.1

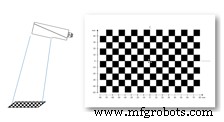

Objektiv- und Montageverzerrung mit Kalibrierplatte korrigieren: Die Kalibrierplatte wird in einem bestimmten Abstand unterhalb der Kamera platziert und das Bild aufgenommen, wie in Abbildung 2.2 gezeigt .

Abbildung 2.2:Kamerapositionierung

Bild:Baumer

Sobald die Verzerrungskalibrierung durchgeführt wurde, sieht das Bild ausgerichtet aus. Dies wird unten in Abbildung 2.3 gezeigt .

Abbildung 2.3

Koordinatenkalibrierung mit Kalibrierplatte: Die Gitterlinien oder Markierungen auf der Kalibrierplatte beziehen sich auf die Anzahl der in der Kamera erfassten Pixel. Wichtig ist, den Ortszeiger exakt auf der Kalibrierplatte zu positionieren.

Die Zeiger werden auf die Punkte/Ecken der Platte gesetzt. Die Abstände zwischen diesen Punkten sind bekannt und werden dann in die Kalibrierungsparametrierungsfelder der Software eingegeben. Das Bildverarbeitungssystem berechnet dann die Anzahl der Pixel, die zum Messen dieser Entfernung verbraucht werden. Diese Einstellung gilt, solange der Arbeitsabstand, das FOV und die Kamerahalterungen beibehalten werden. Das System muss neu kalibriert werden, wenn sich eines der drei Dinge ändert.

Trends und Fortschritte

VGR ist keine neue Technologie. Es hat sich bereits entwickelt und ist zu einer ziemlich ausgereiften Anwendung geworden. Nahezu alle Roboterhersteller bieten mittlerweile integrierte Lösungen für VGR an. Die neuesten Fortschritte bei Kameratechnologien (wie Hochgeschwindigkeitskameras, 3D-Time-of-Flight-Kameras und integrierten Stereokameras) und bei Softwaretechnologien (wie künstliche Intelligenz und maschinelles Lernen) haben jedoch dieses zusätzliche Stück Zuverlässigkeit hinzugefügt und Robustheit zur gesamten Anwendung.

Tiefe neuronale Netze werden eingesetzt, um verschiedene Möglichkeiten der Komponentenpositionierung und -orientierung entlang aller Ebenen zu lehren und erneut zu lehren. Die vielen zu lernenden Möglichkeiten können die Trainingszeit der Netzwerke verlängern, aber die neuesten Computergeräte (wie GPU) machen Aufgaben weniger zeitaufwändig. Cloud-basierte Plattformen für maschinelles Lernen werden derzeit ebenfalls bereitgestellt.

Schlussfolgerung

VGR gewinnt schnell an Popularität in allen Bereichen der Industrie. Die Anwendung, die einst hauptsächlich vom Automobilsegment angetrieben wurde, findet jetzt andere Abnehmer wie Lebensmittel und Pharmazeutika für Hochgeschwindigkeits-Roboter-Pick-and-Place, Palettierung und Depalettierung, Schwermaschinenbau für die Nahtverfolgung von Schweißrobotern, Klebstoffauftrag und so weiter. Es müssen Standards aufgestellt werden um die Interkompatibilität zwischen den Herstellern von Bildverarbeitungssystemen und Roboterherstellern sicherzustellen. Während die Welt auf die „neue Normalität“ in der Fertigung blickt, spielt VGR definitiv eine wichtige Rolle.

Industrietechnik

- Die Zukunft der Robotik

- Robotermaschinenpflege - Vor- und Nachteile

- Die Rolle der Bildverarbeitung in der Industrierobotik

- Beste Lieferanten von Roboterschweißmaschinen in China

- Robotik-Singularität:Was sie in Roboterarmen steckt

- TM Robotics führt neue Robotersteuerung ein

- Visionsgesteuerter Cobot verdoppelt Tagesproduktion

- Roboter erhalten Hand-Auge-Koordination

- Die Geschichte der Robotik in der Fertigung

- Was ist ein Roboter-Kaffee-Barista?