Was steckt hinter der Umstellung auf benutzerdefinierte Sprachagenten?

Automatisierung ist der Weg der Zukunft. Wir leben im heutigen Zeitalter und wollen, dass alles schnell beantwortet, erreicht und empfangen wird. Trotz dieses grundlegenden Wandels nehmen viele Menschen Technologie nicht an. Für manche hängt es mit dem Lebensstil zusammen:Große Unternehmen können zu klobig sein, um ihr System zu transformieren, und Einzelpersonen können in ihren Wegen stecken bleiben und nicht lernen wollen, wie man auf einem Touchscreen navigiert. Bei den meisten kommt es jedoch auf die Daten an – wem gehören sie und wie können sie geschützt werden.

Die Lösung? Es ist so einfach wie die Stimme. Die Voice-Enablement-Technologie kann den Bedarf an Automatisierung decken und gleichzeitig die Daten nahe halten, und wir verwenden sie jeden Tag, unabhängig von Ort und Plattform. Da die digitale Transformation immer mehr Anwendungen beeinflusst, sind Sprachagenten die Antwort. Immer mehr Unternehmen prüfen den Aufbau benutzerdefinierter Sprachplattformen, die in die Technologie eingebettet sind, abgesehen von bekannten Sprachagenten wie Alexa und Google Voice. Einzigartige Sprachplattformen werden der Weg in die Zukunft für Unternehmen sein, die ihre eigenen Daten behalten und kontrollieren möchten.

Hinter der Störung steckt Automatisierung

Da das Internet der Dinge (IoT) auf künstlicher Intelligenz (KI) aufbaut, sehen wir zunehmend den Bedarf an Automatisierung. Wenn das IoT mit KI zusammenarbeitet, verbessert es die Kontrolle, die Benutzer über die riesigen und breiten Sammlungen von Internetgeräten haben. Wir beginnen zu sehen, wie sich die Sprachunterstützung zu Hause und darüber hinaus ausweitet und über Plattformen wie Google Voice, Amazon Alexa, Microsoft Cortana oder einzigartig erstellte Plattformen verbunden wird. Wir bei Harman Embedded Audio haben mit jeder einzelnen Voice-Engine der Welt gearbeitet und kennen die Breite des Marktes aus erster Hand. Wir sehen, dass immer mehr Unternehmen ihre sprachaktivierten Produkte auf ihren eigenen benutzerdefinierten Sprachassistenten-Plattformen aufbauen möchten, damit sie die Kontrolle über die Daten haben.

Die Nachfrage nach Sprachsteuerung wächst

Es ist einer der heißesten Audiotrends. Die nächste große Sache in der Benutzeroberfläche, da Funktionen wie Touchscreens fast allgegenwärtig sind, ist die Möglichkeit, mit einem Gerät zu sprechen. Voice führt die nächste Generation der menschlichen Zusammenarbeit an. Denken Sie an die Verarbeitung natürlicher Sprache auf einem Computer:Die Stimme wird auf eine Weise verarbeitet, die dem entspricht, was die Maschine lieber hören würde, aber wenn Sie dieselbe verarbeitete Datei abspielen würden, wäre sie mechanisch und unnatürlich. Gleiches gilt für das Telefonieren:Es entsteht nicht der Eindruck, mit jemandem in einem Raum zu sein. Hier muss die Stimme hinkommen, und hier werden die oben erwähnten einzigartigen Sprachplattformen folgen.

Wie benutzerdefinierte Sprachagenten aussehen und was an der Erstellung beteiligt ist

Obwohl jede Sprachlösung anders ist, ist es wichtig, dass alle Lösungen flexibel genug sind, um sich an die erforderlichen Anforderungen ihres Anwendungsfalls anzupassen und gleichzeitig Benutzerdaten zu sammeln und zu schützen. Um dies zu erreichen, sind drei Hauptelemente bei der Erstellung und Integration eines Sprachagenten erforderlich.

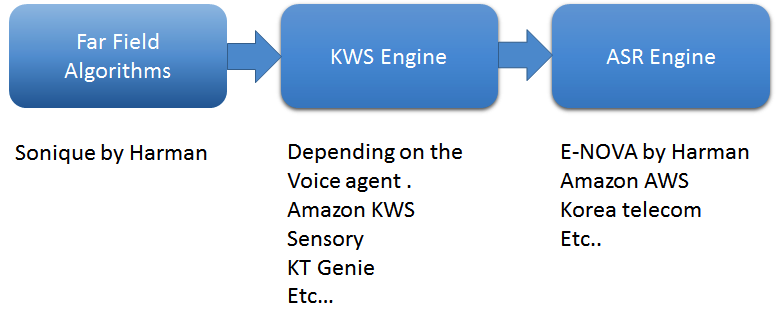

Der erste sind Fernfeldalgorithmen. Verwenden Sie einen erstklassigen Algorithmus, der Fernfeld-Stimmen erfasst. In meinem Unternehmen verwenden wir vier wichtige Softwarealgorithmen von Sonique algorithms:Rauschunterdrückung, akustische Rauschunterdrückung, Schalltrennung und Beamforming sowie Sprachaktivitätserkennung. Diese Algorithmen wurden speziell entwickelt, um in Kombination miteinander verwendet zu werden, um sprachgestützte Anwendungen zu unterstützen.

Wie arbeiten Sie? Denken Sie darüber nach, einen intelligenten Lautsprecher mit einem Menschen zu vergleichen. Der DSP/SOC fungiert als „Gehirn“ des Sprechers, die Mikrofone sind die Ohren und die Sprecher sind der Mund. Für uns löscht unser Gehirn, wenn jemand unseren Namen ruft, alle Geräusche um uns herum und widmet seine ganze Energie diesem Schlüsselwort. Dies haben wir bei einem intelligenten Lautsprecher erreicht – wenn das Schlüsselwort erkannt wird, verwendet das Mikrofon verschiedene Rauschunterdrückungstechniken und richtet seine ganze Kraft auf die Quelle. Dabei werden die meisten Geräusche um ihn herum ausgeblendet. In akustischen Umgebungen gibt es viele Geräuschquellen wie Umgebungsgeräusche, lokale Lautsprecher, HLK und mehr, die Feedback vom Lautsprecher zum Mikrofon widerspiegeln. Jede dieser Geräuschquellen benötigt eine eigene individuelle Lösung. Sonique-Algorithmen unterdrücken die Geräusche und erfassen die bestmöglichen klaren Sprachbefehle.

Außerdem ist der Aufbau einer Keyword-Spotting-Engine (KWS) von entscheidender Bedeutung. KWS erkennt Schlüsselwörter wie „Alexa“ oder „OK Google“, um ein Gespräch zu beginnen. Ich habe mit fast jedem KWS-Engine-Anbieter zusammengearbeitet, und jeder wird von tiefen neuronalen Netzwerken angetrieben – hochgradig anpassbar, immer zuhörend, leichtgewichtig und eingebettet. Für ein großartiges Kundenerlebnis in einer Fernfeld-Sprachanwendung ist die entscheidende Komponente eine Falschannahme- und Falschablehnungsrate. Unter realen Bedingungen ist es wirklich schwierig, eine niedrige False Reject-Rate beizubehalten, da viele externe Geräusche wie Fernseher, Haushaltsgeräte, Duschen usw. zu einer unvollständigen Aufhebung der Audiowiedergabe führen. Erfahrene Entwickler optimieren die KWS-Engine, um die Rate falscher Akzeptanz niedrig zu halten.

Schließlich wandelt die Engine zur automatischen Spracherkennung (ASR) Sprache in Text um. ASR besteht aus dem zentralen Speech-to-Text-Tool (STT) und dem Natural Language Understanding (NLU), das den Rohtext in Daten umwandelt. Die Engine erfordert auch Fähigkeiten, oder anders ausgedrückt, eine Wissensdatenbank, aus der Antworten bereitgestellt werden können, sowie das inverse Text-to-Speech-Tool. Wir haben beispielsweise eine ASR-Engine namens E-NOVA entwickelt, die plattformübergreifende On-Premise-Integrationen bietet, mehrere Sprachen unterstützt (derzeit sieben Sprachen, Tendenz steigend) und trainierbare Modelle, Integrationsunterstützung von Drittanbietern und Sprecheridentifizierung umfasst.

ASR ist der erste Schritt, der es den Sprachtechnologien wie Amazon Alexa, OK Google, Cortana oder Kunden ermöglicht, auf die Frage „Wie ist das Wetter in Los Angeles?“ zu reagieren. Es ist der Schlüsselteil, der den gesprochenen Ton erkennt, ihn als Wörter erkennt, mit dem Ton in einer bestimmten Sprache abgleicht und letztendlich die Wörter identifiziert, die wir sagen. Aufgrund der ASR-Engine fühlt sich das Gespräch natürlich an. Und mit modernen Technologien nutzen die meisten ASR-Engines Cloud Computing. Mit zusätzlichen Technologien wie NLU werden die Gespräche zwischen Mensch und Computer intelligenter und komplexer.

Abbildung 1:Grundlegende Verarbeitungspipeline in Sprachagenten. (Quelle:Harman Embedded Audio)

Die Erstellung benutzerdefinierter Sprachagenten stellt jedoch eine Vielzahl einzigartiger Herausforderungen dar. Das Verständnis der Produktumgebung ist eine der wichtigsten Herausforderungen des Prozesses, und jede Anwendung variiert je nach Anwendungsfall. Stellen Sie sich zum Beispiel vor, zu Hause zu kochen, Ihre Hände sind beschäftigt und voll, wenn es Zeit ist, etwas Wasser zu kochen, genügt eine kurze Aufforderung an den Sprachagenten, der mit Ihrem Sanitärraum verbunden ist:„Wasser auf x Grad kochen“. Die Herausforderung hierbei besteht darin, ob das Gerät in der Lage ist zu hören, was Sie gesagt haben, und wie viel Rauschen das Gerät unterdrückt, um ein sauberes Signal zu erhalten und Sie richtig zu hören. Um dies zu gewährleisten, müssen Sprachalgorithmen auf feindliche Umgebungen abgestimmt, die Mikrofonpositionen angepasst werden, damit sie den Ton aufnehmen können, und Lautsprecher mit niedrigem THD sollten verwendet werden, um ein hohes SNR für Mikrofone zu unterstützen. Dadurch erhalten Sie den bestmöglichen Ton für die ASR-Engine, was zu der richtigen Antwort auf Ihre Fragen führt.

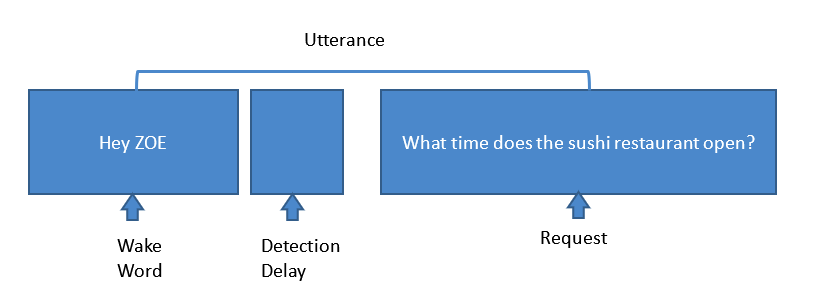

Stellen Sie sich außerdem vor, Sie wären auf einem Kreuzfahrtschiff:Die Geräusche um Sie herum sind völlig anders als in einem Wohnzimmer oder einer Küche. Die größte Herausforderung besteht darin, Algorithmen zu trainieren, um diese Geräusche zu unterdrücken und das saubere Audiosignal für eine genaue Reaktion an das System zu senden. Richtig implementiert kann ein virtuelles Personal Cruise Assistant System, wie wir es für MSC Cruises entwickelt haben, die in Abbildung 2 gezeigten Schritte zuverlässig ausführen.

Abbildung 2:Schritte einer typischen Sprachassistenten-Anfrage. (Quelle:Harman Embedded Audio)

Hier erkennt ein Sprachassistent im Beifahrerzimmer das Weckwort „Hey Zoe“. Wenn KWS das Schlüsselwort erkennt, leitet das gesamte Mikrofon, basierend auf Rauschunterdrückungsalgorithmen, seine Energie zur Quelle um und unterdrückt Umgebungsgeräusche wie Wechselstromgeräusche, TV, unkorrelierte Geräusche, Propeller- und Motorgeräusche, Windgeräusche, AEC , usw. Sonique-Algorithmen sind darauf abgestimmt, all diese Geräusche zu unterdrücken und dem System ein möglichst sauberes Signal zuzuführen. Wenn das System die Anfrage erhält, wandelt die ASR-Engine diese Stimme in Text um. NLU-Engines konvertieren diesen Text dann in Rohdaten, um die Antwort zu erhalten. Aber wir sind noch nicht fertig. Um die gesuchte Antwort zu erhalten, liefert der Wissens-Skill die Antwort auf die Anfrage und die ASR-Engine wandelt diesen Datentext in Sprache um und gibt ihn über den Lautsprecher aus.

Eine weitere Herausforderung ist die Falschratenablehnung (FRR). Der Prozess zum Erreichen von Wake Word FRR, einem der Kontrollpunkte zur Messung der Leistung intelligenter Lautsprecher, ist sowohl zeitaufwändig als auch kostspielig. Das System wird verwendet, um zu überprüfen, ob das Produkt richtig aufwachen kann, wenn ein Aufweckwort erkannt wird. Um FRR zu erreichen, sind trainierte Schlüsselwörter unerlässlich. Unserer Erfahrung nach ermöglicht die Kombination des trainierten Modells mit einem erstklassigen Algorithmus den Entwicklungsteams, die Herausforderung zu meistern und die bestmögliche FRR zu erreichen. Die Weckwortantwort wird unter verschiedenen Bedingungen in einem Labor weiter getestet, um sicherzustellen, dass das System die Industriestandards erfüllt.

Die Vorteile des Einsatzes einzigartiger Sprachagenten

Sprachagenten bieten einen großen Wert für die Benutzererfahrung. Musik ist der größte und einfachste Anwendungsfall, aber der Wert von Sprachagenten geht weit über das Öffnen Ihres Spotify-Kontos aus der Ferne hinaus. Die Stimme kann Dinge einschalten, mit Geräten interagieren, Wasser kochen, einen Wasserhahn aufdrehen – und vieles mehr! Voice ist leistungsstark und die Agenten wissen viel über ihre Benutzer. Aus diesem Grund möchten Unternehmen ihre eigenen Daten abrufen – besitzen, speichern und sichern.

Sprachlösungen haben breite Anwendungsmöglichkeiten, aber der Schlüssel besteht darin, eine Technologie zu nutzen, die plattformübergreifend funktioniert – eine Technologie, die für intelligente Lautsprecher, Laptops und Smartphones auf Apple, Windows oder Android relevant ist – und die gesammelten Daten zu nutzen, um einen Agenten aufzubauen, der versteht, lernt ständig und erinnert sich an die Bedürfnisse der Benutzer. Die Erstellung eines einzigartigen Sprachagenten ermöglicht diese Nutzungsflexibilität – und hält gleichzeitig die Daten intern.

Eingebettet

- Was ist das metallische Glas?

- Was ist der Unterschied zwischen Massenproduktion und kundenspezifischer Produktion?

- Was ist eine neue Plattform in der Cloud?

- Was mache ich mit den Daten?!

- Was ist die Kreislaufwirtschaft?

- Gleichstrom- und Wechselstrommotor:Was ist der Unterschied?

- Was gehört zum Herstellungsprozess?

- Was ist die Druckindustrie?

- Was ist die Farbenindustrie?

- Was ist die Verpackungsindustrie?