Benchmark für maschinelles Lernen erweitert die Unterstützung für Edge-Workloads in Rechenzentren

Die Benchmarking-Organisation ML Commons hat eine neue Runde von MLPerf Inference Scores veröffentlicht. Diese neueste Runde ist in Geräteklassen unterteilt, um einen einfacheren Vergleich zu ermöglichen. Die Ergebnisse umfassen auch eine Reihe neuer KI-Modelle, die eine Reihe unterschiedlicher Workloads darstellen sollen, die kommerziell eingesetzt werden, aber immer noch als Stand der Technik gelten.

Nvidia-beschleunigte Systeme machten etwa 85% der Gesamteinsendungen aus und gewannen alle Kategorien, die sie eingereicht hatten. Es gab jedoch keine Nvidia-Einreichungen in den Mobile- oder Notebook-Klassen (Nvidia ist in diesen Märkten nicht mit KI-Beschleunigungsprodukten präsent). Es gab auch mehrere interessante Einreichungen von Startups und insgesamt eine größere Tendenz, Zahlen in mehreren Spalten zu verwenden, was den Vergleich erleichtert.

Änderungen gegenüber der letzten Runde

Die erste wesentliche Änderung der Ergebnisse dieser Runde besteht darin, dass die Systeme in Klassen unterteilt wurden:Rechenzentrum, Edge, Mobile und Notebook. Mobiltelefone und Notebooks haben sehr spezifische Formfaktoren und Leistungsprofile, wodurch sie sich leicht von der breiteren Edge-Liste unterscheiden lassen.

„Wenn Sie von einem Notebook sprechen, läuft wahrscheinlich Windows, wenn Sie von einem Smartphone sprechen, verwenden Sie wahrscheinlich iOS oder Android“, sagte David Kanter, Executive Director von ML Commons, gegenüber EE Times . „Die Trennung dieser Ergebnisse aus dem größeren Pool von Inferenzwerten ist sehr hilfreich, um die Dinge klarer zu machen.“

Die Benchmarks für diese zweite Runde von Inferenz-Scores wurden ebenfalls überarbeitet, um KI-Modelle aufzunehmen, die moderne Anwendungsfälle darstellen. Während sich die vorherige Runde auf Vision- und Bildverarbeitungsmodelle konzentrierte, umfassen die Rechenzentrums- und Edge-Klassen diesmal das Empfehlungsmodell DLRM, das medizinische Bildgebungsmodell 3D-UNet, mit dem in MRT-Scans nach Tumoren gesucht wird, das Sprache-zu-Text-Modell RNN- T- und Natural Language Processing (NLP)-Modell BERT.

„[Modellauswahl] wird durch den Input der Kunden bestimmt, aber wir möchten nicht in die Falle tappen, dass die Studenten ihren eigenen Test machen“, sagte Kanter und erklärte, dass das Ziel darin bestand, modernste Modelle zu identifizieren, die sich in der Produktion befinden. nicht nur in der Forschungsphase. „DLRM und 3D-UNet, das waren sehr informierte [Entscheidungen], die von unserem Beirat getrieben wurden, Leute aus der medizinischen Welt, Leute, die Empfehlungen in großem Umfang aussprechen… Diese Art von informierter Workload-Konstruktion ist enorm wertvoll.“

Die Mobile- und Notebook-Klassen verwenden MobileNetEdge für die Bildklassifizierung, SSD-MobileNetv2 für die Objekterkennung, Deeplabv3 für die Bildsegmentierung und Mobile BERT für NLP.

Im Allgemeinen wurden auch die Genauigkeitsziele erhöht, um reale Einsätze widerzuspiegeln.

Die Analyse unten bezieht sich nur auf die „geschlossene“ Abteilung für einen fairen Vergleich.

Rechenzentrumsergebnisse

Erwartungsgemäß nutzte der Großteil der Einsendungen in der Rechenzentrumsklasse Nvidia GPU-Beschleuniger. Der Rest nutzte bis auf wenige Ausnahmen (siehe unten) Intel-CPUs für die KI-Verarbeitung. Diesmal keine Einsendungen von Google für seine TPU und keine Einsendungen von irgendjemandem aus der Vokal-Community der Startups, die sich in diesem Bereich etablieren (Graphcore, Cerebras, Groq usw.).

„[Nvidias] Leistungsvorsprung gegenüber den CPUs hat sich bei einem einfachen Computer-Vision-Modell namens ResNet und bei fortgeschrittenen Empfehlungssystemmodellen von etwa 6x auf 30x erhöht… Nvidia A100 ist 237-mal schneller als [Intels] Cooper-Lake-CPU“, sagte Paresh Kharya , Senior Director für Produktmanagement und Marketing bei Nvidia. „Ein einzelner DGX-A100 bietet auf Empfehlungssystemen die gleiche Leistung wie 1000 CPU-Server und einen erstaunlichen Wert für die Kunden.“

Mipsology war der einzige im Handel erhältliche Nicht-CPU-Nicht-GPU-Einsteiger in dieser Abteilung. Das Unternehmen verfügt über eine Beschleunigertechnologie namens Zebra, die auf Xilinx-FPGAs (in diesem Fall einem Xilinx Alveo U250) läuft. Ihre Technologie kann 4096 ResNet-Anfragen pro Sekunde im Servermodus verarbeiten (im Vergleich zu ungefähr 5563 für eine Nvidia T4) oder 5011 Abtastungen pro Sekunde im Offline-Modus (verglichen mit ungefähr 6112 für die Nvidia T4).

Das taiwanesische Unternehmen Neuchips hat eine Bewertung in der Kategorie Forschung, Entwicklung oder Intern eingereicht, was bedeutet, dass das von ihm verwendete Gerät nicht im Handel erhältlich ist und höchstwahrscheinlich nicht für mindestens weitere 6 Monate erhältlich sein wird. RecAccel wurde speziell entwickelt, um DLRM zu beschleunigen, das Empfehlungsmodell, das in diesem Benchmark verwendet wird. Es verwendet ein massiv paralleles Design, das auf einem Intel Stratix FPGA für KI-Inferenz ausgeführt wird. Seine Ergebnisse in der DRLM-Kategorie waren vergleichbar oder schlechter als bei Intel Cooper Lake-CPUs und nicht mit Nvidia vergleichbar.

Edge-Ergebnisse

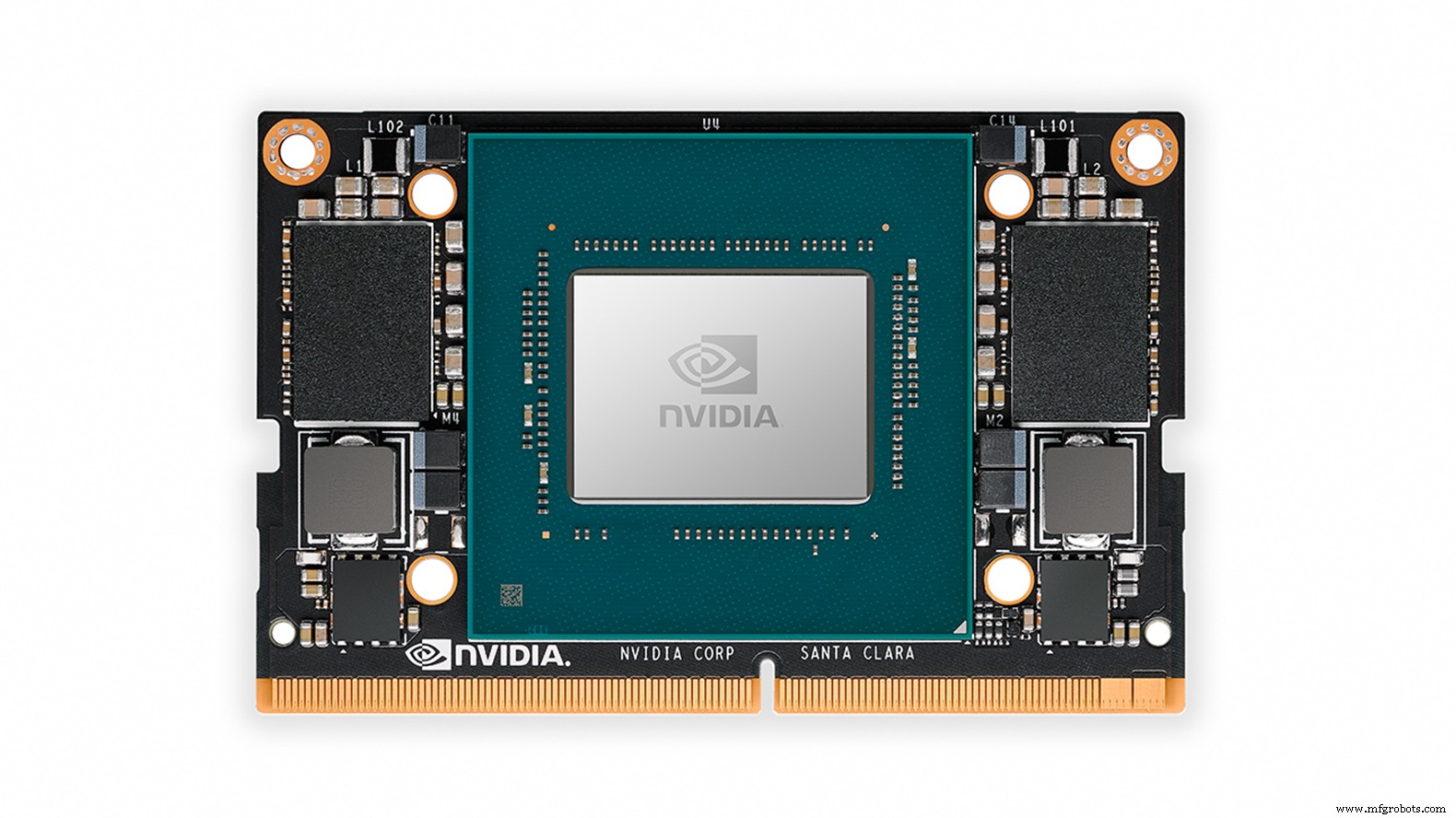

Die Edge-Kategorie wurde von Scores dominiert, die von Nvidias A100, T4, AGX Xavier und Xavier NX beschleunigt wurden.

Centaur Technology hat Ergebnisse seines kommerziell erhältlichen Referenzdesignsystems eingegeben, das den Serverprozessor von Centaur basierend auf seiner hauseigenen x86-Mikroarchitektur sowie einen separaten internen KI-Beschleuniger als Co-Prozessor verwendet. Dieses Referenzdesign ist ein System der Serverklasse für lokale oder private Rechenzentrumsanwendungen und laut Centaur auf Kosten und Formfaktor (anstatt auf Stromverbrauch oder Spitzenleistung) optimiert.

Bei der ResNet-Bildklassifizierung (Single-Stream-Latenz) war das System von Centaur schneller als Nvidias eigene Einreichungen für Serversysteme, die mit dem Tesla T4 ausgestattet waren. Der T4 übertraf jedoch das Design von Centaur bei ResNet-Offline-Samples, die pro Sekunde verarbeitet wurden. Bei der Objekterkennung schnitt Centaur jedoch nicht ganz so gut ab und lag irgendwo zwischen den beiden eingebetteten Edge-Modulen von Nvidia, dem Xavier NX und dem AGX Xavier.

Das britische Ingenieurbüro dividiti, das sich auf die objektive Bewertung von ML-Hardware- und -Softwaresystemen spezialisiert hat, hat eine Reihe von Bewertungen zu Systemen eingereicht, die von Fireflys und Raspberry Pis bis hin zu Nvidia AGX Xavier reichen. Scheinbar identische Ergebnisse für die Raspberry Pi-Einträge verwenden tatsächlich unterschiedliche Betriebssysteme (32-Bit-Debian vs. 64-Bit-Ubuntu – Ubuntu war ungefähr 20 % schneller). Die Ergebnisse des Unternehmens wichen von Nvidias eigenen Ergebnissen für den AGX Xavier ab, da Nvidia sowohl die GPU des AGX Xavier als auch zwei On-Chip-Deep-Learning-Beschleuniger für seine ResNet Offline- und Multistream-Scores verwendet, wobei dividiti nur die GPU verwendet.

Ein dividiti-Sprecher sagte auch der EE Times dass es dem Unternehmen zwar gelungen war, die Ergebnisse von Nvidia für die vorherige Inferenzrunde „mehr oder weniger“ zu reproduzieren, die neuesten Ergebnisse jedoch eine Leistungsregression in das Testsystem einführten, die erst Minuten vor der Einreichungsfrist bemerkt wurde (das Beheben dieses Fehlers verbesserte später einige Latenzen um 10-20%). Dies dient der Veranschaulichung der Bedeutung der Hardware/Software-Kombination für die Ergebnisse.

Die Edge-Kategorie wurde von Ergebnissen dominiert, die von Nvidia-GPUs beschleunigt wurden, einschließlich der Jetson Xavier NX (Bild:Nvidia)

Neu in dieser Kategorie sind IVA Technologies und Mobilint, beide in der Kategorie Forschung, Entwicklung oder Intern.

IVA Technologies, ein russischer Designer und Hersteller von IT-Geräten, hat an einem KI-Beschleunigerchip gearbeitet, der Faltungs-, 3D-Faltungs- und LSTM-Modelle unterstützt. Das Unternehmen reichte eine Bewertung mit der Bezeichnung „FPGA“ ein, bei der es sich möglicherweise um einen Prototyp des auf einem FPGA implementierten Beschleuniger-ASICs handelt. Die Single-Stream-Latenz von ResNet betrug 12,23 ms, ungefähr 4x langsamer als die Xavier NX, und verarbeitete 89 Offline-Samples pro Sekunde, weniger als ein Zehntel der Xavier NX. Die Kategorie Edge ist jedoch breit gefächert und über das Design ist nicht viel bekannt – sie könnte für kleinere Geräte als das Xavier NX gedacht sein.

Mobilint, ein koreanisches KI-Beschleuniger-ASIC-Startup, hat eine Bewertung für sein Mobilint Edge-Design eingereicht, die EE Times Suspects wurde als Prototyp auf einer Xilinx Alveo U250 FPGA-Karte implementiert. Auf ResNet war seine Latenz mit 37,46 ms viel länger als das Design von IVA Technologies, aber es verarbeitete mehr Offline-Samples pro Sekunde (107). Das Unternehmen hat auch Bewertungen für die Objekterkennung eingereicht.

Obwohl weder IVA Technologies noch Mobilint bahnbrechende Ergebnisse erzielt haben, ist das Benchmarking von Prototypen sicherlich von Vorteil, da es beweist, dass die zugehörigen Software-Stacks bereit sind.

Mobile Ergebnisse

In der Kategorie der neuen mobilen SoCs gab es drei Einsendungen, die ziemlich gut aufeinander abgestimmt waren, ohne einen klaren Gewinner.

MediaTek hat Ergebnisse für sein Dimensity 820 (im Xiaomi Redmi 10X 5G-Smartphone) eingereicht. Dieses Gerät verwendet MediaTeks eigene KI-Verarbeitungseinheit (APU) 3.0, die ein FP16- und INT16-fähiger Beschleuniger ist, der für Kamera-/Bildgebungsfunktionen optimiert ist. Der SoC hat auch eine 5-Kern-GPU.

Der Qualcomm Snapdragon 865+ verwendet den Hexagon 698-Prozessor des Unternehmens, der für KI-Beschleunigung entwickelt wurde und mit 15 TOPS taktet, neben der Adreno 650-GPU. Die Benchmarks wurden auf einem Asus ROG Phone 3 durchgeführt.

Samsungs Exynos 990 wurde im Rahmen des Galaxy Note 20 Ultra einem Benchmarking unterzogen. Dieses Gerät enthält neben verschiedenen Arm-CPU-Kernen eine Dual-Core-NPU (Neural Processing Unit) und eine Arm Mali-G77 GPU.

Samsungs Exynos 990 schnitt am besten bei der Bildklassifizierung und NLP ab; der MediaTek Dimensity 820 war bei der Bildklassifizierung sehr nah dran, aber Samsung hatte einen deutlicheren Vorsprung bei NLP. MediaTek hatte einen klaren Vorsprung bei der Objekterkennung, mit dem Qualcomm Snapdragon 865+ auf dem zweiten Platz. MediaTek hat auch den Bildsegmentierungs-Benchmark gewonnen, knapp vor Qualcomm.

Notebook-Ergebnisse

In der Kategorie Notebook gab es nur einen Eintrag – ein Intel-Referenzdesign, das die kommende Intel Xe-LP-GPU als Beschleuniger nutzt. Der Xe-LP ist die Low-Power-Version von Xe-HP und Xe-HPC, die für Rechenzentrums-KI-Beschleunigung und HPC gedacht sind; Keines der größeren Geräte wurde einem Benchmarking unterzogen.

Da es in dieser Klasse nur einen Eintrag gab, ist es schwierig, die Ergebnisse des Xe-LP zu interpretieren. In der Notebook-Kategorie wurden jedoch dieselben KI-Modelle verwendet wie in der mobilen Kategorie, sodass ein Vergleich unumgänglich ist. Der größte Vorteil von Xe-LP gegenüber den mobilen SoCs lag in der Bildsegmentierung (DeeplabV3), wo es den mobilen Gewinner um den Faktor 2,5 beim Durchsatz (Frames pro Sekunde) übertraf. Seine schwächste Leistung war bei der Objekterkennung (SSD – MobileNetv2), wo sein Vorteil gegenüber dem mobilen Gewinner in Bezug auf den Durchsatz (Frames pro Sekunde) um das 1,15-fache lag.

Zukünftige Benchmarks

Für die Zukunft hofft Kanter, dass zukünftige Runden der Benchmarks mehr Nicht-Nvidia- und Nicht-Intel-CPU-Einträge enthalten werden

„Wir haben eine offene Abteilung, in der Sie jedes gewünschte Netzwerk einreichen können“, sagte er. „Eines der netten Dinge daran ist, wenn ein Kunde sagt, dass ich X will und Sie die gesamte Aktivierung dafür vornehmen, können Sie X verwenden, solange Sie den Code eingeben können, damit wir sehen können, was Sie ausführen. ”

Unternehmen können Ergebnisse für nur ein KI-Modell einreichen, um den Entwicklungsaufwand gering zu halten, und können sogar ihre eigenen Modelle in die offene Kategorie einreichen.

Kanter erwähnte auch, dass es die Absicht der Organisation ist, eine Dimension der Leistungsmessung in die nächste Bewertungsrunde einzuführen. Die Arbeiten sind bereits im Gange.

„Eines der Dinge, an denen wir die Leute gerne beteiligen würden, ist die Unterstützung beim Aufbau der Leistungsmessinfrastruktur – helfen Sie uns, die Tools für diese Messungen zu entwickeln“, sagte Kanter.

Die vollständige Liste der MLPerf-Inferenzergebnisse im Detail ist hier verfügbar.

>> Dieser Artikel wurde ursprünglich veröffentlicht am unsere Schwesterseite EE Times.

Eingebettet

- ST:Bewegungssensor mit maschinellem Lernen für hochpräzises, batterieschonendes Aktivitätstracking

- ADLINK:säulenmontierte Edge-KI- und Machine-Learning-Lösung mit Mehrfachzugriff

- NXP verdoppelt maschinelles Lernen am Edge

- Trends treiben die Verarbeitung weiter an den Rand für KI

- Funktionen des vertikalen Bearbeitungszentrums zur Verbesserung der Produktivität

- Ein optimiertes WLAN ist entscheidend für den Erfolg von Edge

- Maschinelles Lernen im Feld

- Der Rand ist jetzt das Zentrum des Geschehens

- Drehzentrum für Schwerlastanwendungen

- Vierachsiges vertikales Drehzentrum für die Wellenfertigung