Prediction Network of Metamaterial with Split Ring Resonator basierend auf Deep Learning

Zusammenfassung

Die Einführung von „Metamaterialien“ hatte tiefgreifende Auswirkungen auf mehrere Bereiche, einschließlich der Elektromagnetik. Die Struktur eines Metamaterials on demand zu entwerfen, ist jedoch immer noch ein äußerst zeitaufwändiger Prozess. Als effiziente Methode des maschinellen Lernens wurde Deep Learning in den letzten Jahren häufig zur Datenklassifizierung und -regression eingesetzt und zeigte tatsächlich eine gute Generalisierungsleistung. Wir haben ein tiefes neuronales Netzwerk für On-Demand-Design aufgebaut. Mit dem erforderlichen Reflexionsgrad als Eingabe werden die Parameter der Struktur automatisch berechnet und dann ausgegeben, um den Zweck des Entwurfs nach Bedarf zu erreichen. Unser Netzwerk hat niedrige mittlere quadratische Fehler (MSE) mit einem MSE von 0,005 sowohl bei den Trainings- als auch bei den Testsätzen erreicht. Die Ergebnisse zeigen, dass das trainierte Modell durch die Verwendung von Deep Learning zum Trainieren der Daten den Entwurf der Struktur genauer steuern und so den Entwurfsprozess beschleunigen kann. Verglichen mit dem traditionellen Designprozess kann die Verwendung von Deep Learning zur Anleitung des Designs von Metamaterialien schnellere, genauere und bequemere Zwecke erreichen.

Einführung

Nanooptik ist ein interdisziplinäres Fach der Nanotechnologie und Optik. In den letzten Jahren ist es Wissenschaftlern gelungen, durch die ständige Konstruktion von Strukturen mit unterschiedlichen Subwellenlängengrößen, um spezielle Wechselwirkungen mit einfallendem Licht zu erzielen, bestimmte Transmissionseigenschaften des Lichts zu manipulieren [1,2,3]. Seitdem Metamaterialien vorgeschlagen wurden, haben sie die Aufmerksamkeit vieler Wissenschaftler auf diesem Gebiet auf sich gezogen, und gleichzeitig schreiten ihre verwandten theoretischen Studien [4, 5], Prozess- [6, 7] und angewandten [8] Forschungen alle mit der gleichen Geschwindigkeit voran. Viele besondere Funktionen wurden realisiert, darunter holographische Bildgebung, perfekte Absorption [9] und flache Linsen [10]. Aufgrund der rasanten Entwicklung der Terahertz-Technologie und ihrer einzigartigen Eigenschaften ist sie in den letzten Jahren auch zu einem beliebten Forschungsthema im Bereich der Metamaterialien geworden [11,12,13].

Obwohl die Anwendung von Metamaterialien sehr weit verbreitet ist, erfordert die traditionelle Entwurfsmethode, dass der Konstrukteur wiederholt komplexe numerische Berechnungen an der zu entwerfenden Struktur durchführt. Dieser Prozess verbraucht viel Zeit und Rechenressourcen. Daher ist es dringend erforderlich, neue Wege zu finden, um traditionelle Konstruktionsmethoden zu vereinfachen oder sogar zu ersetzen.

Als interdisziplinäres Feld deckt das maschinelle Lernen viele Disziplinen ab, darunter Lebenswissenschaften, Informatik und Psychologie, und arbeitet daran, Computer zu verwenden, um menschliche Lernprozesse zu imitieren und zu implementieren, um neue Kenntnisse oder Fähigkeiten zu erwerben. Das Grundprinzip des maschinellen Lernens kann einfach als die Verwendung von Computeralgorithmen beschrieben werden, um die Korrelation zwischen einer großen Datenmenge zu erhalten oder die Regeln zwischen ähnlichen Daten vorherzusagen und schließlich den Zweck der Klassifikation oder Regression zu erreichen. Bisher wurden viele Algorithmen des maschinellen Lernens auf die Bezeichnung von Metamaterialien angewendet und haben signifikante Ergebnisse erzielt, darunter genetische Algorithmen [14], lineare Regressionsalgorithmen [15] und flache neuronale Netze. Da die Struktur immer komplexer wird und die Veränderungen in der Struktur vielfältiger werden, wird die Lösung von Problemen mehr Zeit erfordern. Gleichzeitig macht es die stark nichtlineare Natur der Probleme für einfache maschinelle Lernalgorithmen schwierig, genaue Vorhersagen zu erhalten. Um eine passende Metamaterialstruktur für einen bestimmten elektromagnetischen Effekt zu entwerfen, müssen Designer außerdem versuchen, komplexe numerische Berechnungen an der Struktur durchzuführen. Diese Prozesse werden enorm viel Zeit und Rechenressourcen verbrauchen.

Als einer der herausragendsten Algorithmen im Bereich des maschinellen Lernens hat Deep Learning in verschiedenen verwandten Bereichen wie Computer Vision [16], Feature Extraction [17] und Natural Language Processing [18] weltbekannte Erfolge erzielt. Gleichzeitig sind die Erfolge in anderen nicht-computerbezogenen Bereichen zahlreich, darunter viele grundlegende Disziplinen wie Biowissenschaften, Chemie [19] und Physik [20] [21]. Daher ist die Anwendung von Deep Learning auf das Design von Metamaterialien derzeit auch eine heiße Forschungsrichtung, und es sind viele herausragende Arbeiten erschienen [22,23,24].

Inspiriert von Deep Learning berichtet dieser Artikel über eine Studie, die einen maschinellen Lernalgorithmus basierend auf einem tiefen neuronalen Netzwerk verwendet, um die Struktur des Split-Ring-Resonators (SRR) vorherzusagen, um den Zweck des bedarfsgerechten Designs zu erreichen. Darüber hinaus werden das Vorwärtsnetz und das Rückwärtsnetz innovativ getrennt trainiert, was nicht nur die Genauigkeit des Netzes verbessern kann, sondern durch flexible Kombination auch unterschiedliche Funktionen erreichen kann. Die Ergebnisse zeigen, dass die Methode einen MSE von 0,0058 bzw. 0,0055 auf dem Trainingssatz und dem Validierungssatz erreichen kann und eine gute Robustheit und Verallgemeinerung aufweist. Mit dem trainierten Modell, das den Entwurf von Metamaterialstrukturen leitet, kann der Entwurfszyklus auf Tage oder sogar Stunden verkürzt werden, und die Effizienzsteigerung ist offensichtlich. Darüber hinaus hat diese Methode auch eine gute Skalierbarkeit und muss nur die Trainingssatzdaten ändern, um bei Bedarf unterschiedliche Eingaben oder unterschiedliche Strukturen zu entwerfen.

Theorie und Methode

COMSOL-Modellerstellung

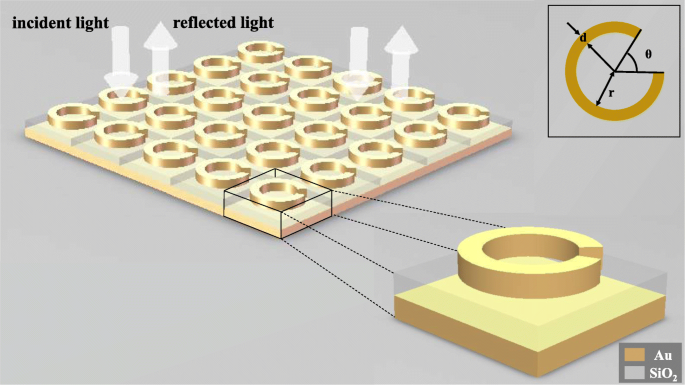

Um zu zeigen, dass Deep Learning auf das umgekehrte Design von Metamaterialstrukturen angewendet werden kann, haben wir eine dreischichtige SRR-Struktur modelliert, die aus einem Goldring, einem Siliziumdioxidboden und einem Goldboden besteht, um ihre elektromagnetische Reaktion unter Einwirkung des einfallendes Licht. Wie in Abb. 1 gezeigt, beträgt der Öffnungswinkel θ des Goldrings, der Innenradius r des Rings und die Linienbreite d des Rings werden als unabhängige Variablen dieser Struktur ausgewählt. Wenn ein Strahl linear polarisierten Lichts normal in die Metamaterialien eintritt, werden die Wellenlängen-Reflexions-Kurven unter verschiedenen Strukturen durch Änderung der Strukturvariablen erhalten. Die Dicke des Au-Rings beträgt 30 nm, der Boden von SiO2 beträgt 100 nm, und der Boden von Au beträgt 50 nm, und die Größe der Metaatome beträgt 200 nm mal 200 nm.

Schematische Darstellung der Struktur. Die gesamte Metaoberfläche besteht aus wiederholt in zwei Richtungen angeordneten Metaatomen und linear polarisiertes Licht fällt senkrecht auf die Metaoberfläche ein. Jedes Metaatom besteht von oben nach unten aus einem Goldring, einem Siliziumdioxidboden und einem Goldboden. Der oberste Goldring enthält drei Strukturparameter, nämlich die Linienbreite d , der Öffnungswinkel θ , und der Innenringradius r

Verwenden Sie COMSOL Multiphysics 5.4 [25] für die Modellierung, wählen Sie die dreidimensionale Raumdimension, wählen Sie Optik ≥ Wellenoptik ≥ elektromagnetische Wellenfrequenzbereich (ewfd) für das physikalische Feld und wählen Sie den Wellenlängenbereich für die Forschung. Erstellen Sie das obige Modell in Geometrie. Das Material jedes Teils und sein Brechungsindex werden der Reihe nach im Material definiert, und Öffnungen und periodische Bedingungen werden im Frequenzbereich der elektromagnetischen Wellen hinzugefügt.

Aufbau eines neuronalen Deep-Learning-Netzwerkmodells

Wir haben ein Rückwärtsnetzwerk und ein Vorwärtsnetzwerk für die Metamaterialstruktur konstruiert. Das Umkehrnetzwerk kann die strukturellen Parameter des SRR aus den gegebenen zwei Sätzen von Wellenlängen-Reflexions-Kurven mit unterschiedlichen Polarisationsrichtungen vorhersagen. Das Vorwärtsnetzwerk kann die Wellenlängen-Reflexions-Kurven in zwei Polarisationsrichtungen durch die gegebenen strukturellen Parameter vorhersagen. Die Funktion des Umkehrnetzwerks ist der Hauptteil der Vorhersagefunktion. Die Rolle des Vorwärtsnetzwerks besteht darin, die Vorhersageergebnisse des Rückwärtsnetzwerks zu überprüfen, um zu beobachten, ob die Vorhersageergebnisse die erforderliche elektromagnetische Reaktion erfüllen.

Verwenden Sie Eclipse 2019 als Entwicklungsplattform, Python3.7 als Programmiersprache und TensorFlow 1.12.0 als Entwicklungsframework.

Die beiden Netzwerke werden separat trainiert, um zu verhindern, dass die Trainingsergebnisse jedes Netzwerks durch den Fehler des anderen Netzwerks beeinflusst werden, wodurch die jeweilige Genauigkeit der beiden Netzwerke sichergestellt wird.

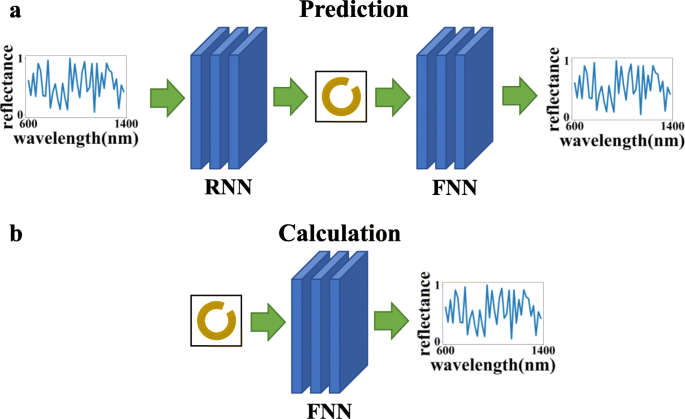

Wie in Abb. 2 gezeigt, besteht ein weiterer Vorteil des getrennten Trainierens der beiden Netze darin, dass sie durch unterschiedliche Verbindungssequenzen für unterschiedliche Zwecke verwendet werden können:(a) Rückwärtsnetz + Vorwärtsnetz, das die gegebene Wellenlängen-Reflexionskurve verwenden kann, um die Strukturparameter erstellen, Vorhersagen treffen und überprüfen, ob die Vorhersageergebnisse den Anforderungen entsprechen, und (b) die Verwendung des Vorwärtsnetzwerks allein den Berechnungsprozess des numerischen Berechnungsverfahrens vereinfachen und die Berechnungszeit verkürzen kann.

In dieser Abbildung bezieht sich FNN auf das vorwärts gerichtete neuronale Netz und RNN bezieht sich auf das rückwärts gerichtete neuronale Netz. Die oberste Grafik (a ) zeigt an, dass die beiden Netzwerke verbunden werden können, um den Effekt der Vorhersage und Überprüfung zu erzielen, und das untere Diagramm (b ) zeigt an, dass das Vorwärtsantwortnetzwerk allein verwendet werden kann, um die optische Antwort zu berechnen

Es ist erwähnenswert, dass das Eingeben und Erhalten der Ergebnisse des trainierten Modells mit der Methode des Deep Learning extrem kurz dauert. Und immer dann, wenn durch Simulation oder Experiment neue Daten gewonnen werden, kann das Modell für weitere Schulungen verwendet werden. Studien haben gezeigt, dass mit der kontinuierlichen Zunahme der Trainingsdaten die Genauigkeit des Modells immer höher und die Generalisierungsleistung immer besser wird [26].

Die Parameter der Struktur sind mehrere Sätze stetiger Eigenwerte, die zum Regressionsproblem gehören. In den letzten Jahren standen vollständig verbundene Netzwerke im Fokus von Deep-Learning-Netzwerken zu Regressionsproblemen und zeigten die Eigenschaften einer hohen Zuverlässigkeit, eines großen Datendurchsatzes und einer geringen Latenz. Wenn Sie in einem vollständig verbundenen Netzwerk einige Anpassungen vornehmen, kann das Netzwerk die Struktur besser vorhersagen.

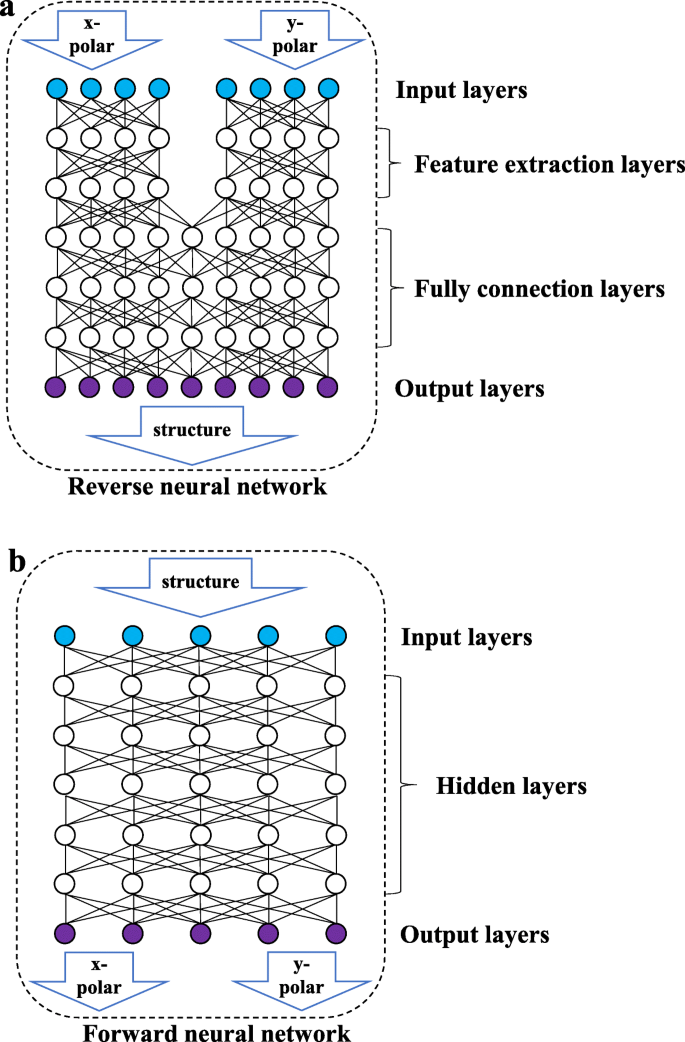

Wie in Fig. 3b gezeigt, ist das Vorwärtsnetzwerk ein vollständig verbundenes Netzwerk, in dem alle Knoten der zwei benachbarten Schichten miteinander verbunden sind. Die Eingabedaten sind der Strukturparameter und die Ausgabe ist die Wellenlängen-Reflexionskurve der beiden Polarisationsrichtungen. Wie in Abb. 3a gezeigt, besteht das Reverse-Netzwerk aus einer Merkmalsextraktionsschicht (FE-Schicht) und einer vollständig verbundenen Schicht (FC-Schicht). Die FE-Schicht enthält zwei Sätze von vollständig verbundenen Netzwerken, die nicht miteinander verbunden sind, und verarbeitet die Wellenlängen-Reflexions-Kurven des linear polarisierten Lichts in den beiden Richtungen, um einige Merkmale der Eingabedaten zu extrahieren. Der FC-Layer lernt die extrahierten Features und gibt die Strukturparameter aus. Aufgrund der Eigenschaften hoher Kohäsion und geringer Kopplung zwischen den Wellenlängen-Reflexionskurven in verschiedenen Polarisationszuständen kann das Trennen der Eingänge von zwei Sätzen von polarisierten Lichtdaten in verschiedene Richtungen verhindern, dass das Netzwerk durch die Datenstandardisierung während des Datenextraktionsprozesses gestört wird. Das Vorwärtsnetzwerk umfasst nicht mehrere Sätze von Eingaben und muss keine gegenseitige Interferenz zwischen den Daten berücksichtigen, daher verfügt es nicht über eine Feature-Extraktionsschicht.

Schematische Darstellung der Netzwerkstruktur. Die obige Abbildung zeigt das umgekehrte Netzwerk. Das Reverse-Netzwerk besteht aus einer Eingabeschicht, einer Merkmalsextraktionsschicht, einer vollständig verbundenen Schicht und einer Ausgabeschicht. Die folgende Abbildung zeigt das Vorwärtsnetzwerk, das aus einer Eingabeschicht, einer versteckten Schicht und einer Ausgabeschicht besteht

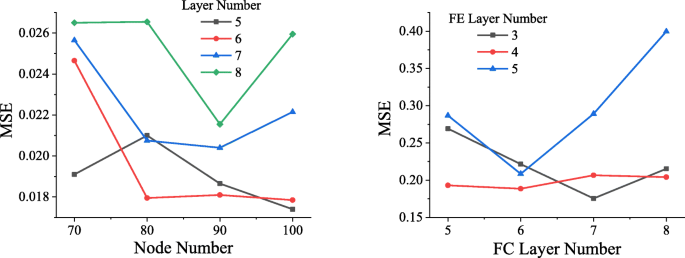

Um die optimale Netzstruktur zu ermitteln, werden Netze in unterschiedlichen Strukturen mit dem gleichen Datensatz trainiert. Wie in Fig. 4 gezeigt, erreicht die MSE, nachdem die Daten 50 Epochen durchlaufen haben (wenn alle Daten ein vollständiges Training durchlaufen haben, eine Epoche genannt), die MSE durch das Vorwärtsnetzwerk mit unterschiedlichen Strukturen. Wie aus dem linken Bild von Fig. 4 ersichtlich ist, beträgt der niedrigste erreichte MSE ungefähr 0,0174, wenn das Vorwärtsnetzwerk 5 versteckte Schichten enthält, wobei jede Schicht 100 Knoten enthält, so dass das Vorwärtsnetzwerk dieser Struktur ausgewählt wird.

Vergleich von Netzwerkstrukturen. In der Abbildung links stellt die horizontale Achse die Anzahl der Knoten in jeder Ebene dar, die vertikale Achse repräsentiert MSE und die Farben Schwarz, Rot, Blau und Grün repräsentieren die Situation, wenn die verborgene Ebene 5, 6, 7 und enthält 8 Schichten bzw. In der Abbildung rechts zeigt die horizontale Achse die Anzahl der Schichten in der vollständig verbundenen Schicht an, die vertikale Achse zeigt MSE an und die schwarzen, roten und blauen Linien zeigen die Situation an, wenn die FE-Schicht 3, 4 und 5 . enthält , bzw.

Ebenso wurden verschiedene Netze von Rückwärtsnetzen trainiert, und das Trainingsvolumen wurde noch auf 50 Epochen festgelegt. Das Ergebnis ist in der rechten Abbildung von Abb. 4 dargestellt. Wenn die Anzahl der FC-Schichten 7 und die Anzahl der FE-Schichten 3 beträgt, erreicht das Netzwerk den niedrigsten MSE, der bei etwa 0,1756 liegt.

Wir haben festgestellt, dass eine größere Anzahl von Netzwerkschichten ein Gradientenexplosionsphänomen erzeugt, das dazu führt, dass das Netzwerk nicht konvergiert und der Verlust unendlich ist, sodass er in der Abbildung nicht aufgeführt ist.

Datenvorverarbeitung

Um ein zuverlässigeres Vorwärtsnetzwerk zu trainieren, werden die Reflexionsdaten neu unterteilt und mit dem Brechungsvermögen von Au und SiO2 . zusammengefügt entsprechend jeder Frequenz. Die gesammelten Daten werden dann normalisiert und in das Vorwärtsnetzwerk eingegeben, was die Genauigkeit des Vorwärtsnetzwerks erheblich verbessern kann.

Um sicherzustellen, dass die Daten mit größeren Werten keinen größeren Einfluss auf das Netzwerk haben als die Daten mit kleineren Werten, müssen die Eingabedaten normalisiert werden, damit jede Datenspalte der Standardnormalverteilung entspricht (der Mittelwert ist 0, die Varianz ist 1), und dann die verarbeiteten Daten x kann wie folgt ausgedrückt werden:

$$ x=\frac{\left({x}_0\hbox{-} \mu\right)}{\sigma} $$ (1)Im Ausdruck x 0 sind die Originaldaten der Probe, μ der Mittelwert der Stichprobe und σ die Standardabweichung der Stichprobe. Wenn die Eingabedaten nicht neu aufgeteilt werden, wird das Reflexionsvermögen nach der Normalisierung verzerrt, was die Genauigkeit des Netzwerks verringert. Die neu unterteilten Daten werden ihre Verteilung aufgrund der Normalisierung nicht beeinflussen.

Neurale Netzwerkmethode

Das Prinzip des neuronalen Netzes besteht darin, viele Neuronen (Knoten) aufzubauen, indem es die Arbeitsweise und das Lernen des menschlichen Gehirns nachahmt [27]. Neuronen sind miteinander verbunden und die Ausgabe wird durch Anpassen des Verbindungsgewichts angepasst. Die Ausgabe des j Knoten einer Schicht kann wie folgt ausgedrückt werden:

$$ {y}_j=\frac{\sum \limits_{i=1}^nf\left({w}_i{x}_i+{b}_j\right)}{n} $$ (2)f ist die Aktivierungsfunktion, w ich ist das Verbindungsgewicht der i . der vorherigen Ebene Knoten verbunden mit dem j Knoten, x ich ist die Ausgabe des i Knoten der vorherigen Schicht, b j ist der Bias-Term dieses Knotens und n ist die Anzahl der Knoten in der vorherigen Schicht, die mit dem j . verbunden sind Knoten.

Auswahl einer Aktivierungsfunktion

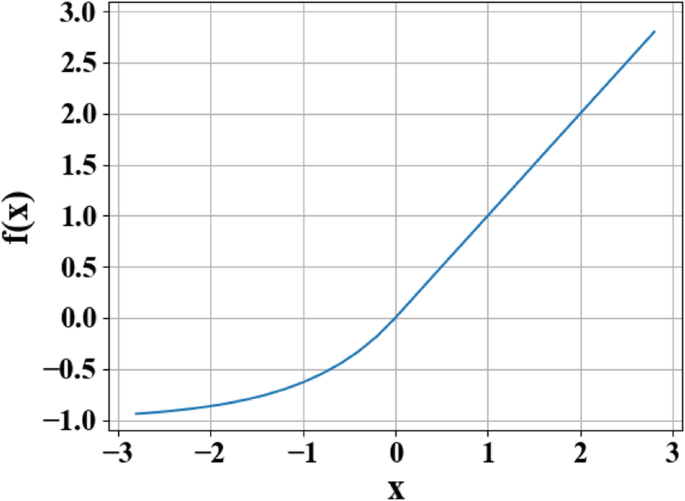

Um der hohen Nichtlinearität des inversen Problems gerecht zu werden, wird die ELU-Funktion [28] als Aktivierungsfunktion jeder Neuronenschicht verwendet [28]. Die Ausgabe f (x ) der ELU-Funktion kann als stückweise Form wie folgt ausgedrückt werden:

$$ f(x)=\left\{\begin{array}{c}x\\ {}\alpha \left({e}^x-1\right)\end{array}\right.{\displaystyle \begin{array}{c},\\ {},\end{array}}{\displaystyle \begin{array}{c}x\ge 0\\ {}x<0\end{array}} $$ (3)In dieser Funktion x ist die ursprüngliche Eingabe und der Parameterwert für α reicht von 0 bis 1.

Der Grund für die Verwendung der Aktivierungsfunktion besteht darin, dass die Aktivierungsfunktion die nichtlineare Ausdrucksfähigkeit jeder Schicht des Netzwerks ändert, wodurch die gesamte nichtlineare Anpassungsfähigkeit des Netzwerks verbessert wird. Wie in Abb. 5 gezeigt, kombiniert die ELU-Funktion die Vorteile der Aktivierungsfunktionen von Sigmoid und rektifizierter Lineareinheit (ReLU). Wenn x <0, hat es eine bessere weiche Sättigung, was das Netzwerk robuster gegenüber Eingangsänderungen und Rauschen macht. Wenn x> 0, gibt es keine Sättigung, was hilfreich ist, um das Verschwinden des Gradienten des Netzwerks zu mildern. Das Merkmal, dass der Mittelwert der ELU nahe bei 1 liegt, kann die Anpassung des Netzwerks erleichtern. Das Ergebnis beweist, dass die Verwendung von ELU als Aktivierungsfunktion des Deep Learning, neuronalen Netzwerks die Robustheit des Netzwerks erheblich verbessert.

Exponentielle lineare Einheiten (ELU) Funktionskurve. In der Abbildung x stellt die ursprüngliche Eingabe dar und f (x ) steht für den Funktionsausgang

Schema der Gewichtungsinitialisierung

Das Initialisierungsverfahren der Netzwerkgewichtung jeder Schicht bestimmt die Geschwindigkeit der Netzwerkanpassung und bestimmt sogar, ob das Netzwerk angepasst werden kann oder nicht. Die Initialisierung der Varianzskalierung basiert auf der Menge der Eingabedaten auf jeder Ebene und extrahiert Gewichte aus einer abgeschnittenen Normalverteilung, die auf 0 zentriert ist, sodass die Varianz auf einen bestimmten Bereich reduziert werden kann, dann können die Daten tiefer über das Netzwerk verteilt werden [29 ]. In dieser Netzwerkstruktur kann die Verwendung der Varianzskalierungsinitialisierung die Konvergenzgeschwindigkeit des Netzwerks erheblich beschleunigen.

Überanpassungslösung

Aufgrund unzureichender Daten führt das Netzwerk zu einer gewissen Überanpassung. Bei reduzierter Überanpassung kann das Netzwerk eine gute Generalisierungsleistung für Daten außerhalb des Trainingssatzes aufweisen. Die L2-Regularisierung (in Regressionsproblemen auch als Weight-Decay bezeichnet) wird verwendet, um das Gewicht w . zu verarbeiten . Die reguläre Ausgabe L kann wie folgt ausgedrückt werden:

$$ L={L}_0+\frac{\lambda }{2n}\sum {w}^2 $$ (4)In Gl. (4), L 0 stellt die ursprüngliche Verlustfunktion dar, und auf dieser Basis wird ein Regularisierungsterm \( \frac{\lambda }{2n}\sum {w}^2 \) hinzugefügt, wobei λ repräsentiert den Regularisierungskoeffizienten, n der Datendurchsatz und w das Gewicht. Nachdem der Regularisierungsterm hinzugefügt wurde, wird der Wert der Gewichtung w tendenziell insgesamt abnimmt und das Auftreten von überhöhten Werten vermieden werden kann, daher w wird auch Gewichtsdämpfung genannt. Die L2-Regularisierung kann die Gewichtung reduzieren, um eine große Steigung der angepassten Kurve zu vermeiden, wodurch das Überanpassungsphänomen des Netzwerks effektiv gemildert und die Konvergenz unterstützt wird.

Auf dieser Grundlage wird auch die Dropout-Methode verwendet. Diese Methode kann visuell als „Verbergen“ einer bestimmten Größe von Netzwerkknoten für jedes Training und als Verstecken verschiedener Knoten während jedes Trainings betrachtet werden, um das Ziel zu erreichen, mehrere „Teilnetzwerke“ zu trainieren. Und durch Training können die meisten „Teilnetze“ die Ziele genau darstellen, und die Ergebnisse aller „Teilnetze“ können sortiert werden, um die Lösung der Ziele zu erhalten.

Die Verwendung der oben erwähnten L2-Regularisierungs- und Dropout-Methoden kann nicht nur die durch unzureichende Daten verursachte geringe Generalisierung effektiv verringern, sondern auch die Auswirkungen einer kleinen Menge fehlerhafter Daten im Datensatz auf die Trainingsergebnisse reduzieren.

Auf dieser Netzwerkstruktur und diesem Datensatz mit Dropout =0,2 und L2-Regularisierungskoeffizient λ =0,0001, kann das Netzwerk eine ähnliche Genauigkeit auf dem Trainingssatz und dem Testsatz erreichen, wodurch eine hohe Generalisierungsleistung erreicht wird.

Ergebnis und Diskussion

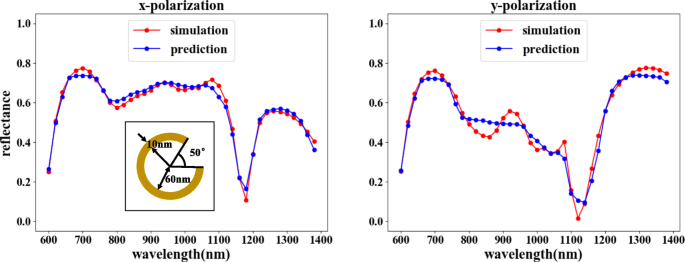

Nach dem Training kann unser Vorwärtsnetzwerk mit einem MSE von 0,0015 einen hohen Anpassungsgrad erreichen, was zeigt, dass die Ausgabe den Simulationsergebnissen sehr ähnlich ist, wie in Abb. 6 gezeigt. Dies stellt auch sicher, dass beim Training des Rückwärtsnetzwerks die Ergebnisse des Reverse-Netzwerks können zuverlässig überprüft werden.

Ergebnisse des Vorwärtsnetzwerktrainings. Die entsprechenden Strukturparameter sind θ =50°, r =60 nm und d =10 nm. In der Figur repräsentiert die horizontale Achse die einfallende Lichtwellenlänge, die vertikale Achse repräsentiert das Reflexionsvermögen, die rote Linie repräsentiert das COMSOL-Simulationsergebnis und die blaue Linie repräsentiert das Netzwerktrainingsergebnis. Die linke Abbildung zeigt die Reflektivitätskurve entsprechend dem x -polarisierter Eingang, und die rechte Abbildung zeigt die Reflektivitätskurve entsprechend dem y -polarisierter Eingang

Schließlich werden wir zwei Modelle aus dem gelernten Netzwerk generieren und die beiden Modelle verbinden, um die Vorhersagefunktion zu erreichen.

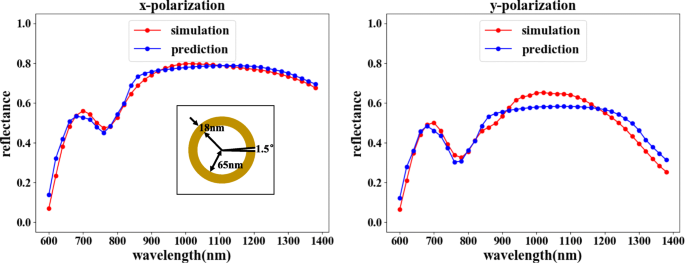

Die Vorhersagefunktion kann die in Fig. 2a gezeigte Kombination wählen. Das Rückwärtsnetzwerk sagt die entsprechende Struktur gemäß der erforderlichen Wellenlängen-Reflexionskurve vorher, und das Vorwärtsnetzwerk verifiziert die optische Reaktion der Struktur. Wie in Fig. 7 gezeigt, stimmen die Reflexionseigenschaften des einfallenden Lichts in den beiden Polarisationsrichtungen durch Vergleichen des verifizierten Reflexionsvermögens mit dem Eingangsreflexionsvermögen grundsätzlich überein. Obwohl bei bestimmten Wellenlängenwerten eine geringfügige Fehlanpassung des Reflexionsvermögens beobachtet werden kann, ist der gesamte Anpassungstrend eindeutig unwiderlegbar, da die Fehler innerhalb eines akzeptablen Bereichs liegen.

Das Rückwärtsnetzwerk gefolgt von einem Vorwärtsnetzwerk kann den Zweck der Vorhersage erfüllen. In der Figur repräsentiert die horizontale Achse die einfallende Lichtwellenlänge, die vertikale Achse repräsentiert das Reflexionsvermögen, die rote Linie repräsentiert das COMSOL-Simulationsergebnis und die blaue Linie repräsentiert das Netzwerktrainingsergebnis. Die linke Abbildung zeigt die Reflektivitätskurve entsprechend dem x -polarisierter Eingang, und die rechte Abbildung zeigt die Reflektivitätskurve entsprechend dem y -polarisierter Eingang. Die vorhergesagten Ergebnisse für die Eingangswellenlängen-Reflexionskurve sind θ =1,5°, r =65 nm und d =18 nm

Schlussfolgerung

In diesem Artikel haben wir unser entwickeltes Deep-Learning-Netzwerk vorgestellt, das in der Lage ist, durch flexible Kombinationen von Netzwerkkonfigurationen verschiedene Effekte zu erzielen. Unser entwickeltes Reverse-Netzwerk kann die erforderliche Struktur unter Verwendung der Eingangswellenlängen-Brechungskurve vorhersagen, was die zur Lösung des Reverse-Problems erforderliche Zeit erheblich verkürzen und durch die Verwendung flexibler Kombinationen unterschiedliche Anforderungen erfüllen kann. Die Ergebnisse zeigen, dass das Netzwerk eine höhere Genauigkeit bei den Vorhersagen erreicht hat, was weiter impliziert, dass On-Demand-Design mit unserer Methode gelöst werden kann. Die Verwendung von Deep Learning zur Steuerung des Designs von Metamaterialien kann automatisch genauere Metamaterialstrukturen erhalten, ein Ergebnis, das mit herkömmlichen Designmethoden nicht erreicht werden kann.

Verfügbarkeit von Daten und Materialien

Das Datum, an dem das Manuskript aus unserem Simulationsnetzwerk stammt, und wir können es aus persönlichen Gründen nicht teilen.

Abkürzungen

- ELU:

-

Exponentielle Lineareinheiten

- FC-Schicht:

-

Vollständig verbundene Ebene

- FE-Schicht:

-

Feature-Extraktionsschicht

- FNN:

-

Neuronales Netzwerk weiterleiten

- MSE:

-

Mittlere quadratische Fehler

- ReLU:

-

Gleichgerichtete Lineareinheit

- RNN:

-

Reverses neuronales Netzwerk

- SRR:

-

Split-Ring-Resonator

Nanomaterialien

- Einsatz von FPGAs für Deep Learning

- Automotive-Prozessor mit integriertem KI-Beschleuniger

- KI-Ziffernerkennung mit PiCamera

- Ein mobiler Roboter mit visueller Hindernisvermeidung

- Verbesserung der Anlagenleistung durch maschinelles Lernen

- Unüberwachtes Lernen mit künstlichen Neuronen

- WND arbeitet mit Sigfox zusammen, um Großbritannien mit einem IoT-Netzwerk zu versorgen

- Split() String-Methode in Java:So teilen Sie Strings mit Beispiel

- Die elektrischen Eigenschaften von Hybridverbundwerkstoffen basierend auf mehrwandigen Kohlenstoffnanoröhren mit Graphit-Nanoplättchen

- Akkulebensdauer mit maschinellem Lernen vorhersagen