Aktivieren der Hardware für das Metaverse

Das Metaverse wird viel diskutiert, insbesondere wenn Unternehmen wie Facebook und Nvidia ihre Visionen der digitalen Zukunft präsentieren. Aber was genau ist das Metaverse, was sind die Hardwareherausforderungen, um es zu ermöglichen, und welche Elemente sind bereits vorhanden? Das Analystenhaus IDTechEx hat sich kürzlich eingehend mit den Fortschritten in Bereichen wie Displays, Bildsensoren, Optik, Haptik, Augmented Reality / Virtual Reality beschäftigt; wir präsentieren hier einige dieser Diskussionen.

Das Endspiel für das Metaverse besteht darin, dass virtuelle Welten nahtlos neben der realen existieren, mit immersiven Interaktionen zwischen den beiden, die unsere Wahrnehmung der physischen Präsenz verändern. Die Software dafür ist fast da, aber die Hardware hat noch viele Hürden zu überwinden.

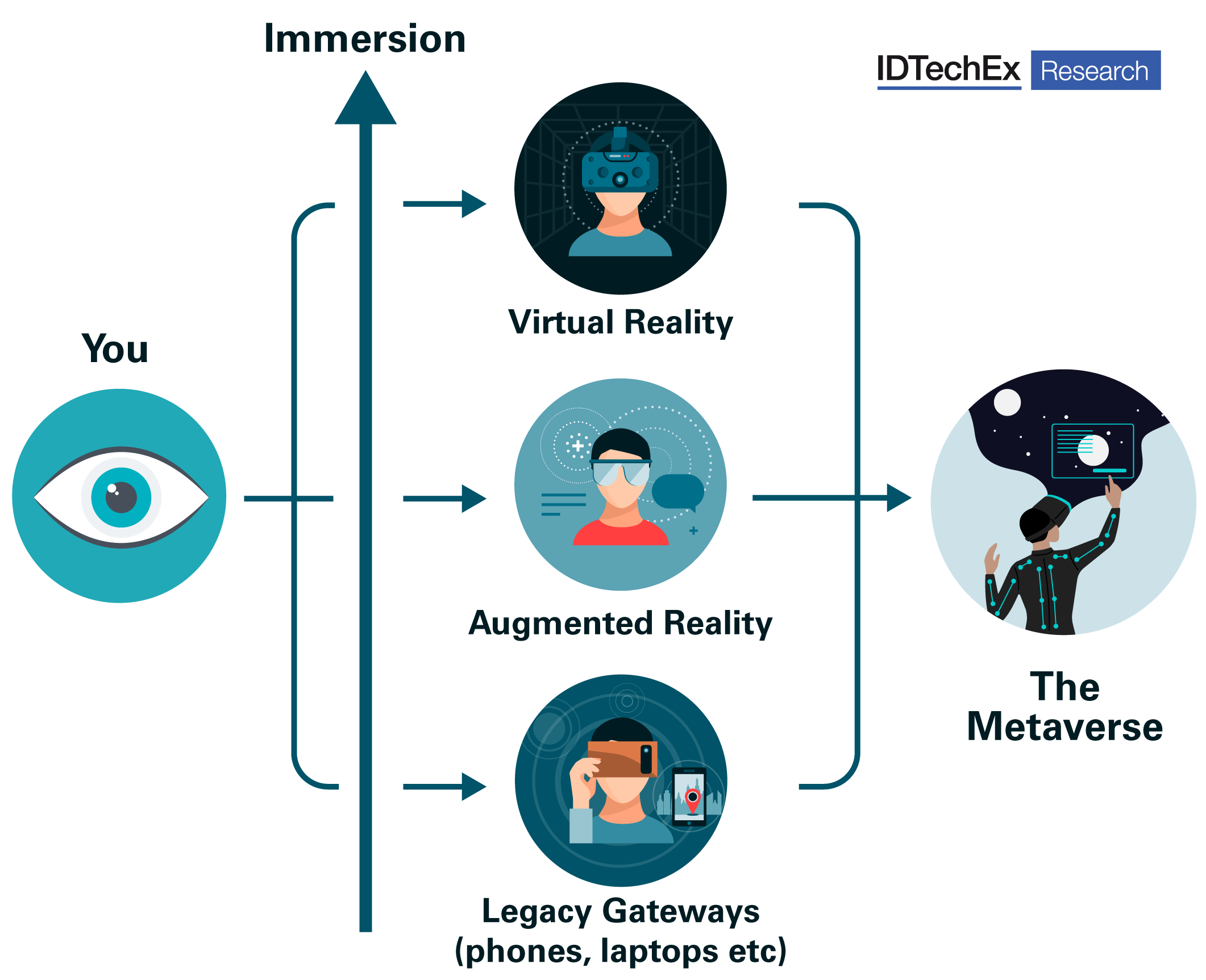

Das Metaverse verspricht einen sprunghaften Wandel in der gesellschaftlichen Kommunikation, bleibt aber ohne die Hardware-Technologie letztlich ein Wunschtraum. Wir werden weiterhin in der Lage sein, über unsere Telefone und Laptops mit dem Metaverse zu interagieren, aber diese werden zu Legacy-Geräten. Um eintauchen zu können, bedarf es einer Virtual Reality (VR)-Brille; Für eine echte Integration zwischen dem erstellten und dem physischen sind Augmented Reality (AR)-Geräte erforderlich.

Ein Prüfstein in der AR/VR-Geräteindustrie ist die soziale Akzeptanz, und ohne Fortschritte in der Sensor-, Anzeige- und Optiktechnologie werden AR- und VR-Headsets nicht schlank genug sein, um dies zu erreichen. Obwohl Milliarden von Dollar in die Entwicklung gesteckt wurden, sagte IDTechEx, dass echte AR-Brillen noch lange nicht neben Ray-Bans stehen, was das Aussehen oder die Anzeige von Bildern in IMAX-Qualität angeht. Meta (ehemals Facebook) kündigte sein AR-Brillen-Projekt gleichzeitig mit seiner Namensänderung an und gab zu, dass es noch Jahre nicht tragfähig war. VR-Headsets laden manchmal zu Vergleichen mit Robocop ein – nur die High-End-Geräte verwischen die Grenzen zwischen dem, was real ist und was nicht.

Langfristig ist das Ziel ein leichtes und komfortables Gerät, das Sie den ganzen Tag tragen können, zwischen AR und VR wechseln und gleichzeitig natürliche Interaktionen zwischen Ihnen und anderen Metaverse-Benutzern ermöglichen. Der technologische Weg zur Hardware, die für die Entwicklung dieses hypothetischen Geräts erforderlich ist, stellt noch überzeugendere Entwicklungen und komplexe Herausforderungen als die Software.

MicroLED-Displays sind ein Teil der Lösung

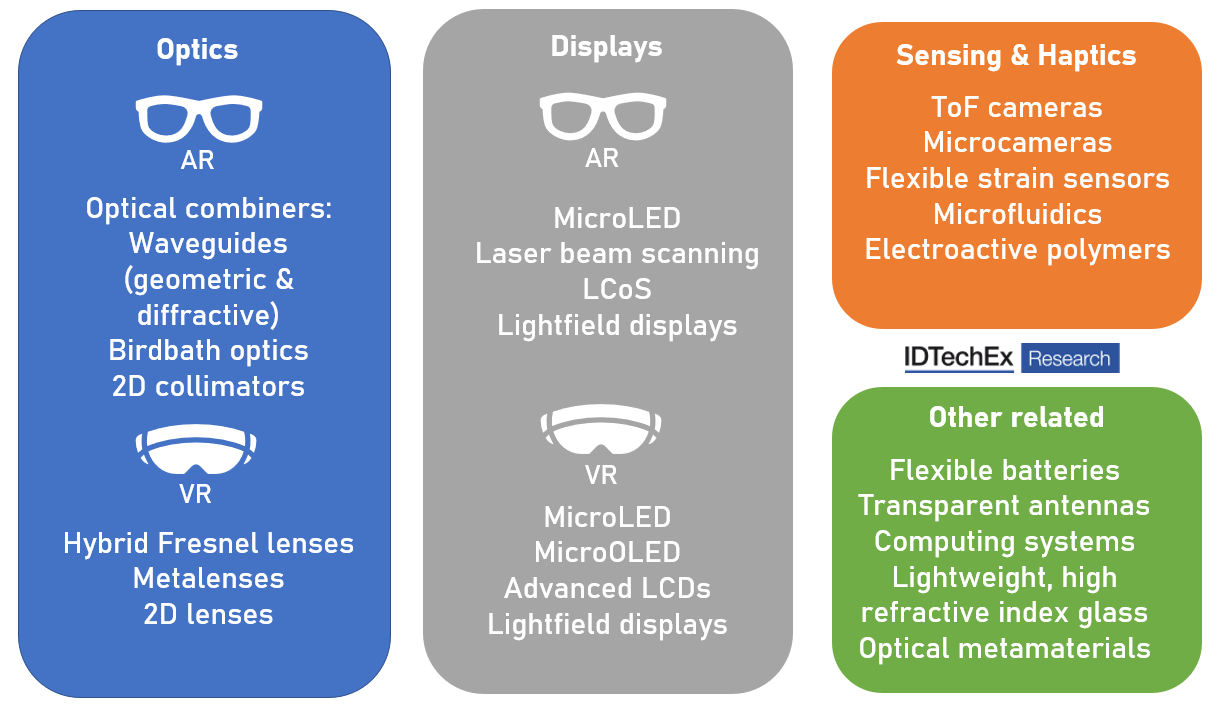

Wenn Sie einen Bildschirm direkt vor Ihre Augen stellen, werden Dinge sichtbar, die wir beim Betrachten eines Telefons oder Fernsehers nicht bemerken. Wir sehen die Lücken zwischen den Pixeln in einem Phänomen, das als Screen Door-Effekt bezeichnet wird, und die Faustregel lautet, dass 60 Pixel pro Grad (ppd) Sichtfeld erforderlich sind, damit VR oder AR wie die Realität aussehen, was zu großen Anforderungen an die Auflösung führt . Darüber hinaus ist eine Optik erforderlich, um diese Bilder für unser Sehvermögen richtig zu fokussieren und zu dimensionieren. Im Fall von AR ist diese Optik sehr ineffizient, was zu Helligkeitsanforderungen von mehreren Millionen Nits führt – als Referenz:Der Bildschirm des iPhone 13 Pro Max erreicht 1200 Nits.

MicroLED-Displays sind eine vielversprechende Lösung für AR und VR. Sie leiden nicht unter Einbrennen wie OLED-Displays, können verrückte Helligkeitsstufen haben (JadeBird stellt eine für AR-Anwendungen mit einer maximalen Helligkeit von 3 Millionen Nits her) und ermöglichen winzige Pixelabstände, wobei Mojo Vision eine sogenannte NanoLED produziert Display, das klein genug ist, um in eine Kontaktlinse zu passen und einen Subpixelabstand von 900 nm hat.

Es gibt jedoch ein großes Problem:microOLED-Mikrodisplays sind nicht gut darin, Vollfarbbilder zu erzeugen, wobei blaue microLEDs deutlich effizienter sind als andere Farben. Die Quantenpunkt-Farbkonvertierung ist hier die bevorzugte Lösung, die die Konversion von blauem Licht in Rot und Grün ermöglicht, und diese Quantenpunkte können Tintenstrahldrucker oder lithografisch gemustert werden. Es gibt immer noch Bedenken hinsichtlich der Langlebigkeit, insbesondere bei sehr hellen Mikrodisplays, sowie der Abhängigkeit von Schwermetallen in vielen Formulierungen. Der Entwicklungszeitplan für microLED-Displays wird in diesem Bericht zu Technologie, Kommerzialisierung, Chancen, Markt und Akteuren detailliert beschrieben.

Das größte Schlachtfeld für AR ist insbesondere die Kombinatoroptik. Diese Geräte überlagern projizierte Bilder auf einer transparenten Linse. Hier kämpfen Unternehmen um die beste Farbwiedergabe, das größte Sehfeld und die größte Eyebox, um ein überzeugendes Display-Erlebnis zu ermöglichen, das für jedes Augenpaar funktioniert.

Angesichts der großen Neuigkeiten in diesem Jahr scheinen Oberflächenreliefwellenleiter die Lösung zu sein, auf die die Branche setzt. Im Mai wurde WaveOptics von Snap (einem weiteren Social-Media-Giganten mit Blick auf das Metaverse) übernommen und im November führte die Investition von Giganten wie Samsung Electronics in Digilens zu einer Bewertung von 500 Millionen US-Dollar. Beide sind Fabless-Waveguide-Firmen. Eine aufregende Entwicklung von Digilens ist der TREX-Waveguide, der die effektive Bildschirmauflösung verdoppeln kann und eine Waffe im Arsenal des Erreichens der 60ppd darstellt. Ein weiterer Bericht über Optik und Displays in AR, VR und MR behandelt die Technologien, Akteure und Märkte und befasst sich ausführlich mit der optischen Kombinator- und Displaytechnologie in diesen Anwendungen.

Eye-Tracking-Technologie

Wenn Sie versuchen würden, ein Headset zu bauen, das alle 135° des horizontalen Sichtfelds jedes Auges bei einer Auflösung von 60ppd abdeckt, würde es schnell unüberschaubar – glücklicherweise ist nur unser Sehzentrum von dieser hohen Qualität, die äußeren Ränder sind es nicht so anspruchsvoll. Durch die Verfolgung unserer Augen kann die Auflösung in der Mitte des Blickwinkels des Benutzers maximiert werden, während die Anforderungen an anderer Stelle gesenkt werden.

In Zukunft könnte diese Eye-Tracking-Technologie sogar verwendet werden, um AR/VR-Bilder per Laserstrahl-Scanning direkt auf die Netzhaut zu projizieren, wodurch die Notwendigkeit von Kombinatoroptiken und Korrekturen für Brillenträger vermieden wird:Das heißt, wenn sich die Verbraucher damit anfreunden können die Idee.

Unternehmen in diesem Bereich nutzen neue Bildsensortechnologien, um das Auge effizienter zu verfolgen. Ereignisbasiertes Sehen kann dazu beitragen, die Verarbeitungsanforderungen niedrig zu halten, indem Bewegungen nativ aufgezeichnet werden, anstatt einen Strom herkömmlicher Bildrahmen. Mit gedruckten Bildsensoren kann die Eye-Tracking-Technologie in ein schlankeres Paket gequetscht werden. Meta Materials Inc. (keine Beziehung zu Meta) bettet bereits Mikrokameras direkt in Brillenlinsen ein und dieser Ansatz wird mit zunehmender Reife der Technologie in Kombinator- oder Lupenoptiken für AR bzw. VR integriert.

Haptik und Sinneserfahrungen

All das, was bisher besprochen wurde, ist kaum mehr als ein High-End-Fernseher, der an Ihr Gesicht geschnallt ist, wenn Sie nicht auf eine Weise interagieren können, die der realen Welt ähnelt. AR- und VR-Geräte müssen nicht nur unsere Bewegungen erfassen, sondern für ein vollständiges Eintauchen sind auch haptische (Touch-Feedback) Geräte erforderlich. Im November 2021 stellte Metas Reality Labs (RL)-Abteilung einen Prototyp eines haptischen Handschuhprodukts vor, einschließlich Videos von Mark Zuckerberg, der verschiedene Demos ausprobiert. Dieser Handschuh verwendet mikrofluidische Systeme, um lokales haptisches Feedback an verschiedene Bereiche der Hand zu geben, und scheint jedem Finger ein weiteres Berührungsfeedback zu geben. Obwohl es einige Kontroversen über die Ähnlichkeit dieses Prototyps mit einem Produkt von HaptX gab, ist die IP-Position von Meta hier stark und repräsentiert die Bemühungen von Metaverse-fokussierten Unternehmen, um sicherzustellen, dass sensorische Erfahrungen über das audiovisuelle hinaus vermittelt werden, so IDTechEx.

Der Analyst sagte, ein Hauptgewinner auf der Sensorseite bei den jüngsten Headsets seien Time-of-Flight-Kameras für die Handverfolgung, die Interaktionen im Game-Controller-Stil mit VR- und AR-Geräten überflüssig machen. Es ist bekannt, dass Apple seit Jahren in den VR/AR-Bereich investiert, und im Oktober 2021 berichteten Branchenquellen, dass LG Innotek damit begonnen hatte, Time-of-Flight-Kameras an das Unternehmen für ein VR-Headset zu liefern, das 2022 auf den Markt kommen soll eine Technologie ist, ist es normalerweise eine starke Aussage, dass sie allgegenwärtig wird und einen weiteren Datenpunkt in der starken Zukunft für AR und VR darstellt.

IDTechEx kommt zu dem Schluss, dass das Metaverse in begrenztem Umfang bereits da ist. Der Berg der Hardwareentwicklung, der seine vollständige Realisierung verhindert, wird langsam erklommen und leichte, gut aussehende AR-Brillen, die in Zukunft unsere Telefone und Laptops ersetzen, fühlen sich fast sicher an.

Sensor

- Das beste Zubehör für Ihren Raspberry Pi

- SICHT:Für Blinde

- Die Zukunft der kontaktlosen Lieferung

- Die sieben Voraussetzungen für eine optimierte Bearbeitung

- Der Fall für den 3D-Druck in der Fertigung

- Mondtaschenlampe zur Suche nach Wasser auf dem Mond

- Was bringt 5G für das IoT/IIoT?

- Eine skalierbare Methode zur großflächigen Integration von 2D-Materialien

- Die Herausforderung der 5S-Methode für die Industrie 4.0

- Danke für die Erinnerungen!