So vermeiden Sie Fallstricke bei Datenanalyseprojekten

Eine aktuelle Capgemini-Studie ergab, dass 15 % der Big-Data-Initiativen in Europa scheitern. Damit Ihr Projekt zu den 85% Erfolgreichen gehört, habe ich die vier wichtigsten Fallstricke zusammengefasst, auf die Sie achten sollten. (Dieser Blogbeitrag enthält die ersten beiden Fallstricke, die anderen beiden werden in einem anderen Blogbeitrag veröffentlicht. )

Diese zu kennen und zu berücksichtigen, erhöht die Erfolgschancen Ihres Data Analytics-Projekts erheblich. Keine Sorge:Mit diesen Herausforderungen und Fallstricken sind Sie bei weitem nicht allein. In unserem ersten Data-Analytics-Workshop sehen wir regelmäßig Teilnehmer, die ihnen begegnen, bis zum Ende des Projekts. Hier möchte ich meine Erkenntnisse aus vielen erfolgreichen Workshops und Projekten mit Ihnen teilen, die wichtigsten Fallstricke aufzeigen und mit Beispielanwendungsfällen veranschaulichen.

1. Der Initiator – IT vs. Abteilung

Data Analytics und Big Data sind nicht dasselbe – auch wenn sie oft synonym verwendet werden.

IT-Abteilungen betrachten Projekte oft durch eine „Big-Data-Brille“. Sie stellen die Infrastruktur zum Sammeln großer Datenmengen bereit; beispielsweise in Form von Datenbank-Clustern. Diese Datenbanken speichern riesige Datenmengen, die an sich keinen Mehrwert für das Unternehmen schaffen. Deshalb sollte das Data Analytics-Projekt immer ein klar definiertes technologisches sowie kommerzielles Ziel haben. Das Sammeln von Daten nur um ihrer selbst willen bringt dem Unternehmen keinerlei Vorteile.

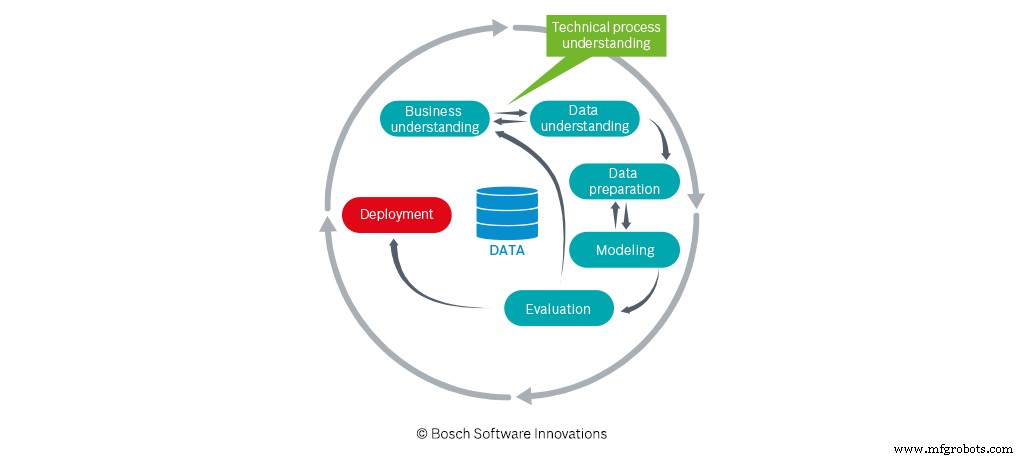

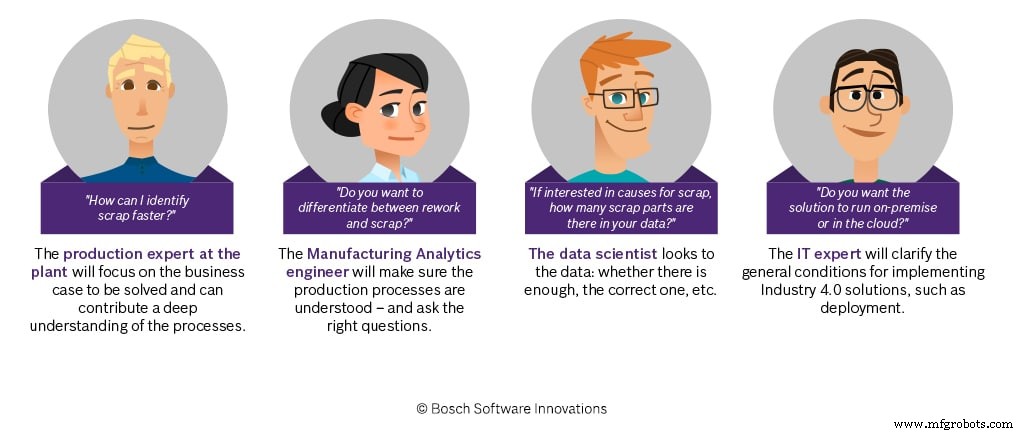

Mehrwert entsteht erst, wenn das Unternehmen die Daten und die daraus resultierenden Erkenntnisse nutzt. Hier kommen seine (nicht-administrativen) Abteilungen ins Spiel. Sie definieren, welche Ziele sie mit Data Analytics erreichen wollen – nicht mit Big Data. Sie vermitteln das technische Verständnis, das es Data Scientists ermöglicht, gezielt mit den Daten zu arbeiten. Eine enge Zusammenarbeit zwischen dem Ideengeber (Abteilung) und den Data Scientists ist daher ein absolutes Muss, um das definierte Projektziel zu erreichen.

Mit anderen Worten:Der Erfolg oder Misserfolg eines Data Analytics-Projekts hängt davon ab, was und wie viel technisches Prozessverständnis an die Data Scientists weitergegeben wird. Auch Data Analytics Engineers spielen hier eine wichtige Rolle. Sie unterstützen die „Übersetzung“ und den Wissenstransfer zwischen den verschiedenen Disziplinen. Data-Analytics-Ingenieure greifen auf ihre operative Erfahrung in der Fertigung oder Logistik und ein fundiertes Grundverständnis von Data-Analytics-Ansätzen zurück. Die Datenexperten müssen nicht nur das Projektziel verstehen, sondern insbesondere auch die Zusammenhänge in den Daten. Noch wichtiger ist, dass sie den Bezug zur realen Welt (Maschinen, Sensoren usw.) und die damit verbundenen Prozessschritte erkennen müssen.

Wie die Capgemini-Studie zeigt, sind IT-Abteilungen häufig die Initiatoren von Data Analytics-Projekten. Dies ist an sich kein Problem, solange die anderen Abteilungen eng eingebunden sind und die fachlichen Ziele des Projekts definieren.

2. Nicht alle Daten sind gleich

Projekt gestartet, Ziel definiert – los!

Stopp!

Bevor die Data Scientists loslegen können, müssen Sie die Qualität und Quantität der Daten überprüfen.

a) Qualität der Daten

Hier ist es wichtig zu überlegen, in welchem Format die Daten vorliegen, wo nach welchen Daten gesucht werden muss und ob die Daten über verschiedene Quellen hinweg transparent sind.

Beispiel:

Um einen Datensatz aus mehreren Quellen zu integrieren, benötigen Sie eine eindeutige Kennung, die eine korrekte Zuordnung der Daten ermöglicht. Dies kann beispielsweise ein Zeitstempel oder eine Teilenummer sein. Die Verwendung eines Zeitstempels erschwert die Integration, wenn in den einzelnen Datenquellen unterschiedliche Datums-/Zeitformate verwendet werden (deutsches vs. US-amerikanisches Datumsformat, Uhrzeit in UTS etc.); es ist jedoch immer noch möglich. Bei unterschiedlichen Zeitbasen ist dies hingegen praktisch unmöglich. Dies ist der Fall, wenn es keine einheitliche Zeitsynchronisation gibt, die die Zeitstempel für alle Datenquellen generiert.

b) Menge der Daten

Je mehr, desto besser – so sagt man. In Bezug auf die Datenanalyse stimmt dies jedoch nur teilweise. Generell gilt natürlich:Je mehr Daten Sie haben, desto besser. Aber auch hier gilt es einige wichtige Aspekte zu beachten.

Je nach technischer Zieldefinition kann es beispielsweise wichtig sein, dass die zugrunde liegenden Daten nicht nur positive Ergebnisse enthalten, sondern auch eine ausreichende Anzahl negativer Ergebnisse.

Beispiel:Vorhersage eines negativen Ergebnisses

Wenn das Ziel des Projekts darin besteht, ein Modell zur Vorhersage eines negativen Ergebnisses zu entwickeln, muss der Trainingsdatensatz, der zum Trainieren des Vorhersagemodells verwendet wird, eine ausreichende Anzahl von negativen Ergebnissen enthalten. Andernfalls kann das Modell diese negativen Ergebnisse nicht lernen und ist daher nicht in der Lage, sie vorherzusagen – folglich können Sie mit diesem Datensatz das Projektziel nicht erreichen! Aus diesem Grund sollten Sie bei der Zusammenstellung des Trainingsdatensatzes darauf achten, dass dieser eine ausreichende Menge des vorherzusagenden Parameters (Zielgröße) enthält – im obigen Beispiel negative Ergebnisse. Eine Möglichkeit, dies zu erreichen, besteht darin, den Zeitraum der Datenerhebung zu erweitern.

c) Die „richtigen“ Daten

Es ist also klar, dass die Datenmenge nicht das einzige Kriterium ist. Du brauchst vor allem die richtigen Daten!

Was meinen wir mit den „richtigen Daten“?

Die Daten müssen die relevanten Informationen enthalten, die zur Erreichung des technischen Projektziels erforderlich sind. Wenn Sie beispielsweise ein Modell zur Vorhersage der Produktqualität im Sinne einer Oberflächenrauheitsmessung entwickeln möchten, muss diese Größe im Datensatz abgebildet werden. Wenn Sie die Messung durchführen, ohne den Messwert nachträglich zu speichern, können Sie kein entsprechendes Modell entwickeln. Auch dies ist kein unlösbares Problem, kann aber den Fortschritt verzögern, da zunächst eine ausreichende Datenbasis generiert werden muss (z.B. mit Hilfe zusätzlicher Sensorik, Speicherung der relevanten Daten etc.).

Wer stellt sicher, dass Ihr Datenanalyseprojekt erfolgreich ist?

Quelle:Bosch.IO

Quelle:Bosch.IO

Damit Experten a), b) und c) erreichen, haben wir die Erfahrungen aus vielen erfolgreichen Projekten in Datenqualitätsleitlinien gebündelt, die wir zu Projektbeginn bereitstellen. Auch mit diesem Thema beschäftigen wir uns in den ersten Workshops, indem wir die Use Cases identifizieren, die Quick Wins liefern. Auf diese Weise sensibilisieren wir Fertigungsexperten für diese Themen, was sich für die nächsten Schritte im Prozess immer als klarer Vorteil erweist.

Industrietechnik

- Upgrade von Industrie 4.0 mit Edge Analytics

- Optimierung der Fertigung mit Big Data Analytics

- So vermeiden Sie Probleme mit gebrauchten CNC-Maschinen

- Erzielung von Geschäftsergebnissen mit Big-Data-Projekten und KI

- Drei Fallstricke bei der Zustellung auf der letzten Meile – und wie man sie vermeidet

- Wie Data Science bei der Bekämpfung des Coronavirus-Ausbruchs half

- Data Mining, KI:Wie Industriemarken mit dem E-Commerce Schritt halten können

- Wie Cloud Analytics die Transformation der digitalen Lieferkette beschleunigen kann

- 5 Gründe, warum IoT-Projekte scheitern und wie man sie vermeidet

- Entwicklung industrieller maschineller Lernprojekte:3 häufige Fehler, die es zu vermeiden gilt