ETSI-Bericht ebnet den Weg zur Standardisierung der KI-Sicherheit

Ein neuer Bericht von ETSI, der europäischen Normungsorganisation für Telekommunikations-, Rundfunk- und elektronische Kommunikationsnetze und -dienste, soll den Weg für die Etablierung eines Standards für die Sicherheit künstlicher Intelligenz (KI) ebnen.

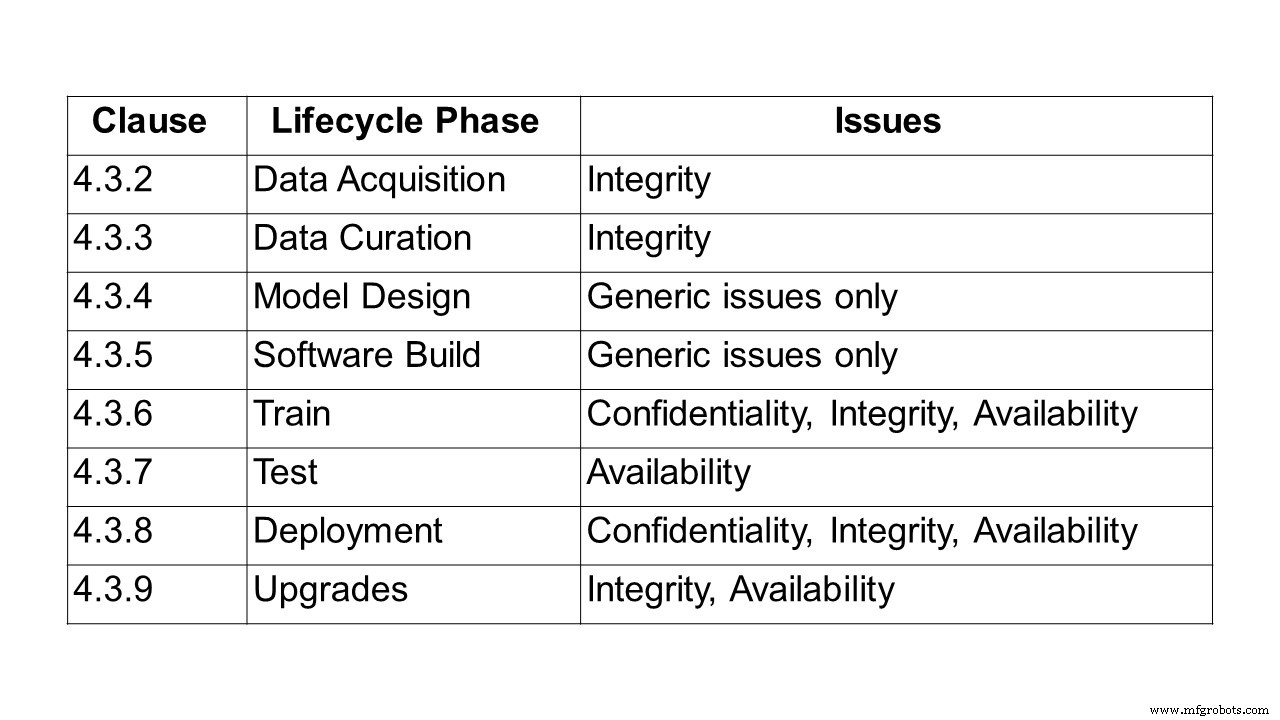

Der erste Schritt auf dem Weg zu einem Standard besteht darin, das Problem der Absicherung KI-basierter Systeme und Lösungen zu beschreiben. Dies tut der 24-seitige Bericht ETSI GR SAI 004, der als erster von der ETSI Securing Artificial Intelligence Industry Specification Group (SAI ISG) veröffentlicht wurde. Es definiert die Problemstellung und konzentriert sich insbesondere auf maschinelles Lernen (ML) und die Herausforderungen in Bezug auf Vertraulichkeit, Integrität und Verfügbarkeit in jeder Phase des Lebenszyklus des maschinellen Lernens. Es weist auch auf einige der umfassenderen Herausforderungen von KI-Systemen hin, darunter Voreingenommenheit, Ethik und Erklärbarkeit. Es werden eine Reihe verschiedener Angriffsvektoren sowie mehrere Fälle von realem Einsatz und Angriffen beschrieben.

Um die Probleme bei der Sicherung von KI zu identifizieren, bestand der erste Schritt darin, KI zu definieren. Für die ETSI-Gruppe ist künstliche Intelligenz die Fähigkeit eines Systems, sowohl explizite als auch implizite Darstellungen und Verfahren zur Ausführung von Aufgaben zu handhaben, die als intelligent gelten würden, wenn sie von einem Menschen ausgeführt würden. Diese Definition stellt noch immer ein breites Spektrum an Möglichkeiten dar. Allerdings wird jetzt eine begrenzte Anzahl von Technologien machbar, was hauptsächlich auf die Entwicklung von maschinellen Lern- und Deep-Learning-Techniken und die breite Verfügbarkeit der Daten und Verarbeitungsleistung zurückzuführen ist, die zum Trainieren und Implementieren solcher Technologien erforderlich sind.

Zahlreiche Ansätze für maschinelles Lernen werden allgemein verwendet, darunter überwachtes, unüberwachtes, halbüberwachtes und verstärkendes Lernen.

- Überwachtes Lernen – bei dem alle Trainingsdaten gekennzeichnet werden und das Modell trainiert werden kann, um den Output basierend auf einem neuen Satz von Inputs vorherzusagen.

- Semi-überwachtes Lernen – wobei der Datensatz teilweise gekennzeichnet ist. In diesem Fall können sogar die unbeschrifteten Daten verwendet werden, um die Qualität des Modells zu verbessern.

- Unüberwachtes Lernen – bei dem der Datensatz nicht gekennzeichnet ist und das Modell nach Struktur in den Daten sucht, einschließlich Gruppierung und Clustering.

- Verstärkendes Lernen – wo eine Richtlinie, die das Verhalten definiert, von Agenten durch Erfahrung erlernt wird, um ihre Belohnung zu maximieren; und Agenten sammeln Erfahrung, indem sie in einer Umgebung durch Zustandsübergänge interagieren.

Innerhalb dieser Paradigmen kann eine Vielzahl von Modellstrukturen verwendet werden, wobei einer der häufigsten Ansätze die Verwendung von tiefen neuronalen Netzen ist, bei denen das Lernen über eine Reihe von hierarchischen Schichten durchgeführt wird, die das Verhalten des menschlichen Gehirns nachahmen.

Es können auch verschiedene Trainingstechniken verwendet werden, nämlich kontradiktorisches Lernen, bei dem das Trainingsset nicht nur Proben enthält, die die gewünschten Ergebnisse widerspiegeln, sondern auch kontradiktorische Proben, die das erwartete Verhalten herausfordern oder stören sollen.

„Es gibt viele Diskussionen über die KI-Ethik, aber keine über Standards zur Sicherung der KI. Sie werden jedoch immer wichtiger, um die Sicherheit von KI-basierten automatisierten Netzwerken zu gewährleisten. Dieser erste ETSI-Bericht soll eine umfassende Definition der Herausforderungen bei der Sicherung von KI liefern. Parallel arbeiten wir an einer Bedrohungs-Ontologie, wie man eine KI-Datenlieferkette absichert und testet“, erklärt Alex Leadbeater, Vorsitzender von ETSI SAI ISG.

Auf die Frage nach Zeitplänen sagte Leadbeater zu embedded.com:„Weitere 12 Monate sind eine vernünftige Schätzung für die technischen Spezifikationen. In den nächsten Quartalen werden weitere technische Berichte erscheinen (AI Threat Ontology, Data Supply Chain Report, SAI Mitigation Strategy Report). Tatsächlich sollte eine Spezifikation zum Sicherheitstest von KI noch vor Ende des zweiten Quartals veröffentlicht werden. Die nächsten Schritte werden darin bestehen, spezifische Bereiche in der Problembeschreibung zu identifizieren, die zu detaillierteren informativen Arbeitselementen erweitert werden können.“

Berichtsübersicht

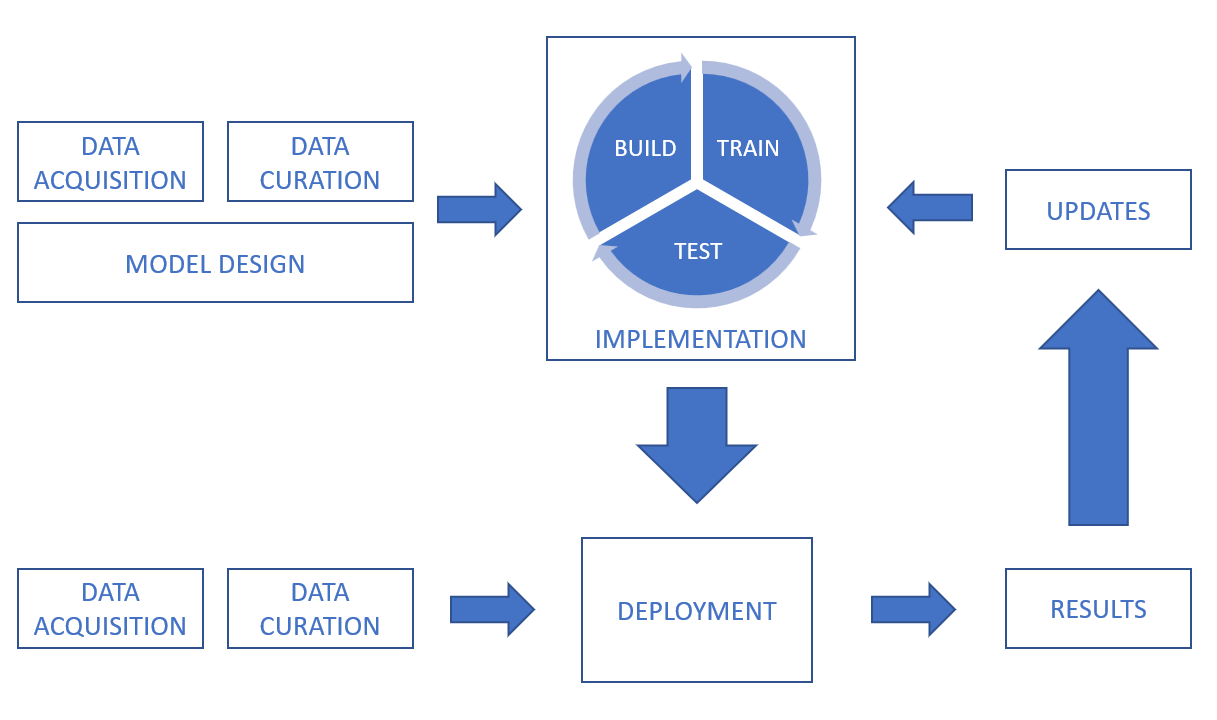

Nach der Definition von KI und maschinellem Lernen betrachtet der Bericht dann die Datenverarbeitungskette und deckt die Herausforderungen der Vertraulichkeit, Integrität und Verfügbarkeit während des gesamten Lebenszyklus ab, von der Datenerfassung, Datenkuration, Modelldesign und Softwareerstellung bis hin zu Schulung, Test, Bereitstellung und Inferenz und Upgrades.

In einem KI-System können Daten aus einer Vielzahl von Quellen bezogen werden, darunter Sensoren (z. B. CCTV-Kameras, Mobiltelefone, medizinische Geräte) und digitale Assets (z. B. Daten von Handelsplattformen, Dokumentenauszüge, Protokolldateien). Daten können auch in vielen verschiedenen Formen vorliegen (einschließlich Text, Bilder, Video und Audio) und können strukturiert oder unstrukturiert sein. Neben Sicherheitsherausforderungen im Zusammenhang mit den Daten selbst ist es wichtig, die Sicherheit der Übertragung und Speicherung zu berücksichtigen.

Um einen Hinweis auf die Integritätsherausforderungen bei der Datenpflege zu geben, muss bei der Reparatur, Erweiterung oder Konvertierung von Datensätzen sichergestellt werden, dass die Prozesse keine Auswirkungen auf die Qualität und Integrität der Daten haben. Bei überwachten Machine-Learning-Systemen ist es wichtig, dass die Datenkennzeichnung korrekt und möglichst vollständig ist und dass die Kennzeichnung ihre Integrität behält und nicht beispielsweise durch Poisoning-Angriffe kompromittiert wird. Es ist auch wichtig, sich der Herausforderung zu stellen, sicherzustellen, dass der Datensatz unvoreingenommen ist. Techniken zur Datenerweiterung können sich auf die Integrität der Daten auswirken.

Ein weiterer behandelter Bereich betrifft Designherausforderungen, andere unbeabsichtigte Faktoren wie Voreingenommenheit, Datenethik und Erklärbarkeit.

Zum Beispiel sollte Bias nicht nur während der Design- und Trainingsphase berücksichtigt werden, sondern auch nach der Bereitstellung eines Systems, da Bias noch eingeführt werden könnten. Der Bericht nennt ein Beispiel aus dem Jahr 2016, als ein Chatbot gestartet wurde, der als Experiment zum „Gesprächsverständnis“ gedacht war. Der Chatbot würde über Tweets und Direktnachrichten mit Nutzern sozialer Netzwerke interagieren. Innerhalb weniger Stunden begann der Chatbot, höchst anstößige Nachrichten zu twittern. Nachdem der Chatbot zurückgezogen wurde, wurde festgestellt, dass das Konto des Chatbots manipuliert wurde, um ein voreingenommenes Verhalten von Internet-Trollen zu zeigen. Verzerrungen stellen nicht unbedingt ein Sicherheitsproblem dar, sondern können einfach dazu führen, dass das System seine funktionalen Anforderungen nicht erfüllt.

Zum Thema Ethik hebt der Bericht mehrere Beispiele hervor, darunter autonome Autos und das Gesundheitswesen. Darin wird ein Papier der University of Brighton zitiert, in dem ein hypothetisches Szenario diskutiert wurde, in dem ein mit KI betriebenes Auto einen Fußgänger umfährt, und die daraus resultierenden rechtlichen Verpflichtungen untersucht wurden. Im März 2018 wurde dieses Szenario Realität, als ein selbstfahrendes Auto in der Stadt Tempe, Arizona, einen Fußgänger überfuhr und tötete. Dies rückte nicht nur die rechtlichen Verpflichtungen, sondern auch die potenziellen ethischen Herausforderungen des Entscheidungsprozesses selbst in den Fokus. Im Jahr 2016 startete das Massachusetts Institute of Technology (MIT) eine Website namens Moral Machine, die die Herausforderungen untersucht, die es intelligenten Systemen ermöglichen, ethische Entscheidungen zu treffen. Die Site versucht zu untersuchen, wie sich Menschen in ethischen Dilemmata verhalten, und ein besseres Verständnis dafür zu gewinnen, wie sich Maschinen verhalten sollten.

Der Bericht betont, dass ethische Bedenken zwar keinen direkten Einfluss auf die traditionellen Sicherheitsmerkmale Vertraulichkeit, Integrität und Verfügbarkeit haben, aber einen erheblichen Einfluss auf die individuelle Wahrnehmung der Vertrauenswürdigkeit eines Systems haben können. Es ist daher unerlässlich, dass KI-Systemdesigner und -implementierer die ethischen Herausforderungen berücksichtigen und bestrebt sind, robuste ethische Systeme zu schaffen, die Vertrauen bei den Benutzern aufbauen können.

Schließlich befasst sich der Bericht mit Angriffstypen, von Poisoning und Backdoor-Angriffen bis hin zu Reverse Engineering, gefolgt von realen Anwendungsfällen und Angriffen.

Bei einem Vergiftungsangriff versucht ein Angreifer, das KI-Modell normalerweise während der Trainingsphase zu kompromittieren, damit sich das eingesetzte Modell so verhält, wie es der Angreifer wünscht. Dies kann daran liegen, dass das Modell aufgrund bestimmter Aufgaben oder Eingaben versagt oder dass das Modell eine Reihe von Verhaltensweisen lernt, die für den Angreifer wünschenswert, aber nicht vom Modelldesigner beabsichtigt sind. Vergiftungsangriffe können normalerweise auf drei Arten auftreten:

- Datenvergiftung – bei denen der Angreifer während der Datenerhebungs- oder Datenpflegephase falsche oder falsch gekennzeichnete Daten in den Datensatz einfügt.

- Algorithmusvergiftung – wenn ein Angreifer in die für den Lernprozess verwendeten Algorithmen eingreift. Föderiertes Lernen umfasst beispielsweise das Trainieren einzelner Modelle anhand von Teilmengen von Daten und das anschließende Kombinieren der gelernten Modelle, um das endgültige Modell zu bilden. Dies bedeutet, dass die einzelnen Datensätze privat bleiben, jedoch eine inhärente Schwachstelle geschaffen wird. Da jeder einzelne Datensatz von einem Angreifer kontrolliert werden könnte, könnte er diesen Teil des Lernmodells direkt manipulieren und das gesamte Lernen des Systems beeinflussen.

- Modellvergiftung – wenn das gesamte bereitgestellte Modell einfach durch ein alternatives Modell ersetzt wird. Diese Art von Angriff ähnelt einem herkömmlichen Cyberangriff, bei dem die elektronischen Dateien, aus denen das Modell besteht, geändert oder ersetzt werden könnten.

Während der Begriff „Künstliche Intelligenz“ auf einer Konferenz in den 1950er Jahren am Dartmouth College in Hannover, New Hampshire, USA, entstand, zeigen die im ETSI-Bericht beschriebenen Fälle von realem Gebrauch, wie sehr er sich seitdem weiterentwickelt hat. Zu diesen Fällen gehören Angriffe mit Werbeblockern, Verschleierung von Malware, Deepfakes, Handschriftwiedergabe, menschliche Stimme und gefälschte Gespräche (was bereits viele Kommentare mit Chatbots ausgelöst hat).

Wie geht es weiter? Laufende Berichte im Rahmen dieser ISG

Diese Industry Specification Group (ISG) untersucht mehrere laufende Berichte als Teil der Arbeitselemente, in die sie tiefer eintauchen wird.

Sicherheitstests :Der Zweck dieses Workitems besteht darin, Ziele, Methoden und Techniken zu identifizieren, die für Sicherheitstests von KI-basierten Komponenten geeignet sind. Übergeordnetes Ziel ist ein Leitfaden für Sicherheitstests von KI und KI-basierten Komponenten, der die unterschiedlichen Algorithmen der symbolischen und subsymbolischen KI berücksichtigt und relevante Bedrohungen aus dem Workitem „KI-Bedrohungsontologie“ adressiert. Sicherheitstests von KI weisen einige Gemeinsamkeiten mit Sicherheitstests herkömmlicher Systeme auf, stellen jedoch aufgrund von neuen Herausforderungen neue Herausforderungen und erfordern andere Ansätze.

(a) erhebliche Unterschiede zwischen symbolischer und subsymbolischer KI und traditionellen Systemen, die starke Auswirkungen auf ihre Sicherheit und darauf haben, wie ihre Sicherheitseigenschaften getestet werden können;

(b) Nichtdeterminismus, da sich KI-basierte Systeme im Laufe der Zeit weiterentwickeln können (selbstlernende Systeme) und sich die Sicherheitseigenschaften verschlechtern können;

(c) Testorakelproblem, die Zuweisung eines Testurteils ist für KI-basierte Systeme anders und schwieriger, da nicht alle erwarteten Ergebnisse a priori bekannt sind, und (d) datengesteuerte Algorithmen:Im Gegensatz zu herkömmlichen Systemen, (Trainings-)Daten bildet das Verhalten der subsymbolischen KI.

Der Umfang dieser Arbeitseinheit zu Sicherheitstests umfasst die folgenden Themen (aber nicht beschränkt auf):

- Sicherheitstestansätze für KI

- Testen von Daten für KI aus Sicherheitsgründen

- Sicherheits-Testorakel für KI

- Definition von Testangemessenheitskriterien für Sicherheitstests von KI

- Testziele für Sicherheitsattribute von KI

Und es bietet Richtlinien für Sicherheitstests von KI unter Berücksichtigung der oben genannten Themen. Die Leitlinien werden die Ergebnisse des Arbeitselements „AI Threat Ontology“ verwenden, um relevante Bedrohungen für die KI durch Sicherheitstests abzudecken und auch Herausforderungen und Einschränkungen beim Testen von KI-basierten Systemen anzugehen.

KI-Bedrohungsontologie :Der Zweck dieser Arbeitsaufgabe besteht darin, zu definieren, was als KI-Bedrohung angesehen wird und wie sie sich von Bedrohungen zu herkömmlichen Systemen unterscheiden könnte. Der Ausgangspunkt für diese Arbeit ist, dass es derzeit kein gemeinsames Verständnis dafür gibt, was ein Angriff auf KI ist und wie er erstellt, gehostet und verbreitet werden könnte. Das zu liefernde Arbeitselement „KI-Bedrohungsontologie“ zielt darauf ab, die Terminologie zwischen den verschiedenen Interessengruppen und verschiedenen Branchen abzustimmen. In diesem Dokument wird definiert, was mit diesen Begriffen im Zusammenhang mit Cyber- und physischer Sicherheit gemeint ist, und mit einer begleitenden Erzählung, die sowohl für Experten als auch für ein weniger informiertes Publikum in den verschiedenen Branchen leicht zugänglich sein sollte. Beachten Sie, dass diese Bedrohungs-Ontologie die KI als System, als gegnerischen Angreifer und als Systemverteidiger anspricht.

Bericht zur Datenlieferkette :Daten sind eine kritische Komponente bei der Entwicklung von KI-Systemen. Dazu gehören Rohdaten sowie Informationen und Feedback von anderen Systemen und Human in the Loop, die alle dazu verwendet werden können, die Funktion des Systems durch Training und Umschulung der KI zu verändern. Der Zugang zu geeigneten Daten ist jedoch häufig eingeschränkt, sodass auf weniger geeignete Datenquellen zurückgegriffen werden muss. Die Beeinträchtigung der Integrität von Trainingsdaten hat sich als praktikabler Angriffsvektor gegen ein KI-System erwiesen. Dies bedeutet, dass die Sicherung der Lieferkette der Daten ein wichtiger Schritt zur Sicherung der KI ist. Dieser Bericht fasst die Methoden zusammen, die derzeit verwendet werden, um Daten für das Training von KI zu beschaffen, sowie die Vorschriften, Standards und Protokolle, die den Umgang und die gemeinsame Nutzung dieser Daten steuern können. Es wird dann eine Lückenanalyse zu diesen Informationen durchführen, um mögliche Anforderungen an Standards zur Gewährleistung der Rückverfolgbarkeit und Integrität der Daten, der zugehörigen Attribute, Informationen und Rückmeldungen sowie deren Vertraulichkeit abzudecken.

Strategie zur Minderung der ORKB Bericht:Dieses Arbeitselement zielt darauf ab, bestehende und potenzielle Abwehr von Bedrohungen für KI-basierte Systeme zusammenzufassen und zu analysieren. Ziel ist es, Richtlinien zur Abwehr von Bedrohungen zu haben, die durch die Einführung von KI in Systeme eingeführt werden. Diese Richtlinien geben Aufschluss über die Grundlagen der Absicherung KI-basierter Systeme durch die Abwehr bekannter oder potenzieller Sicherheitsbedrohungen. Sie behandeln auch Sicherheitsfunktionen, Herausforderungen und Einschränkungen bei der Einführung von Abwehrmaßnahmen für KI-basierte Systeme in bestimmten potenziellen Anwendungsfällen.

?Die Rolle der Hardware bei der Sicherheit von KI: Erstellung eines Berichts, der die Rolle von Hardware, sowohl spezialisierter als auch allgemeiner Art, bei der Sicherheit von KI identifiziert. Dabei werden die in der Hardware verfügbaren Abwehrmaßnahmen zur Abwehr von Angriffen sowie die allgemeinen Anforderungen an die Hardware zur Unterstützung von SAI behandelt. Darüber hinaus befasst sich dieser Bericht mit möglichen Strategien zum Einsatz von KI zum Schutz von Hardware. Der Bericht wird auch eine Zusammenfassung der akademischen und industriellen Erfahrungen im Bereich Hardwaresicherheit für KI bieten. Darüber hinaus befasst sich der Bericht mit Schwachstellen oder Schwachstellen, die durch Hardware verursacht werden und die Angriffsvektoren auf KI verstärken können.

Der vollständige ETSI-Bericht, der die Problemstellung zur Sicherung der KI definiert, ist hier verfügbar.

Internet der Dinge-Technologie

- Tipps und Trends zur IIoT-Sicherheit für 2020

- Ein Rezept für industrielle Sicherheit:Eine Prise IT, eine Prise OT und eine Prise SOC

- Die Suche nach einem universellen IoT-Sicherheitsstandard

- TI:BAW-Resonatortechnologie ebnet den Weg für die Kommunikation der nächsten Generation

- Cyber-Sicherheitsleitfaden für Cloud-Business-Anwender

- Der Bericht fordert dringende Maßnahmen zur Abwehr von Cyberbedrohungen für kritische Infrastrukturen

- Drei Schritte für globale IoT-Sicherheit

- Eine vierstufige Anleitung zur Gewährleistung der Sicherheit von IoT-Geräten

- Was die Einführung von 5G für die IoT-Sicherheit bedeutet

- FTCs "Made in USA"-Anspruchsstrafe ebnet den Weg für zusätzliche Durchsetzung