Wie Worteinbettungen neue Thermoelektrika entdecken

Sprechen Sie heute mit jemandem und er wird Ihnen sagen, dass künstliche Intelligenz das nächste große Ding ist – die heiße Kartoffel, von der jeder ein Stück haben will, aber niemand kauen kann.

Eine gute Mehrheit von ihnen wird Ihnen auch sagen, dass vieles von dem, was als KI kursiert, eigentlich nur ein Hype ist – eine Verherrlichung des guten alten maschinellen Lernens und der Mathematik, gekleidet in Powerpoint. Und zum größten Teil hätten sie recht.

Ein Bereich, in dem die Anwendung von KI-Tools wie Deep Learning geradezu revolutionär war, ist die Verarbeitung natürlicher Sprache.

Ein einfaches Beispiel sind die Chatbots, die Websites verwalten. Sie werden von relativ komplizierten Deep-Learning-Architekturen betrieben, die als neuronale Netzwerke mit Long Short Term Memory (LSTM) bezeichnet werden. Diese Algorithmen können „verstehen“, was wir ihnen sagen, und als Antwort lesbare zusammenhängende Sätze zusammensetzen. Sicher, dieser Bot ist kein Sokrates, aber er spuckt kein zufälliges Durcheinander von Wörtern aus. Es gibt den unbestreitbaren Hinweis auf eine Intelligenz auf niedrigem Niveau.

Worteinbettungen

Die moderne Ära des Deep Learning in der Sprachverarbeitung begann mit der Veröffentlichung von Tomas Mikolovs word2vec-Artikel im Jahr 2013. Ihr Triumph war die Entwicklung einer rechnerisch durchführbaren Methode zur Generierung von Worteinbettungen oder Wortvektoren mit neuronalen Netzen.

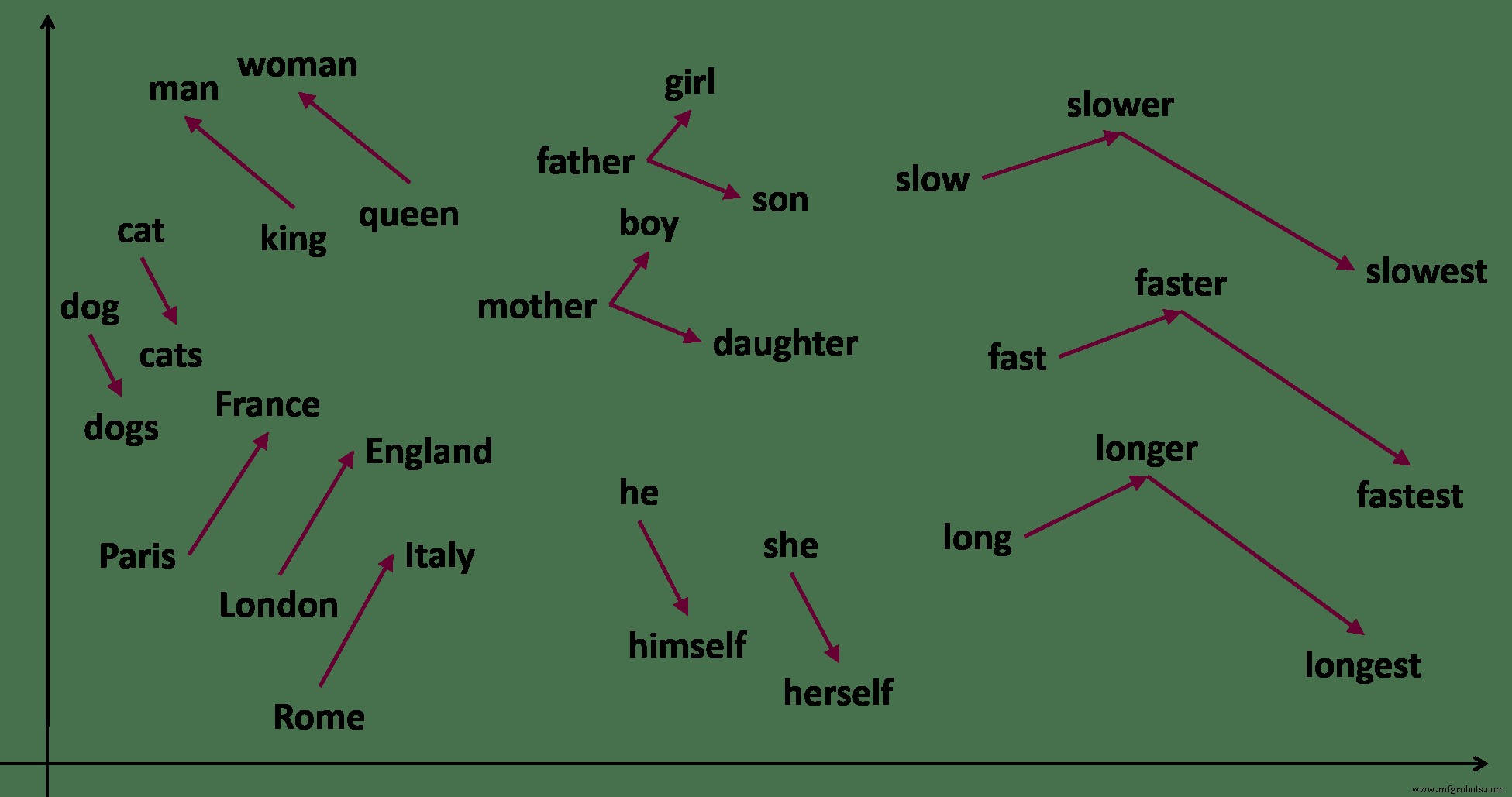

Denken Sie an die Worte Mann, Frau, König undKönigin . Wenn Sie gebeten werden, diese Wörter zu gruppieren, haben Sie eine Reihe von vernünftigen Möglichkeiten. Ich neige dazu, [Mann, Frau zu sehen ] und [König, Königin ]. Du könntest [Mann, König sehen ] und [Frau, Königin ].

Word Embedding erfasst semantische Beziehungen zwischen Wörtern in einem Text. Von https://samyzaf.com/ML/nlp/nlp.html

Ich kenne auch das Wort König und Mann sind genauso verwandt wie „Frau “ und „Königin ’.

Mann:König =Frau:Königin

Auch wenn ich diese Wörter noch nie zuvor gehört habe, kann ich diese Zusammenhänge lernen, indem ich die Sätze beobachte, auf die ich stoße. „Dieser Mann ist ein König “, „Die Königin war eine gottesfürchtige Frau “, „Sie regierte als Königin der Leinwand “, „Sein Königreich wird kommen ’. Diese Sätze suggerieren allein durch die Wortnähe, dass der König ist meistens ein Mann und das eine Königin ist höchstwahrscheinlich eine Frau .

Worteinbettungen machen dasselbe, aber für Millionen von Wörtern aus Tausenden von Dokumenten. Der Schlüssel hier ist, dass die Wörter aus dem Kontext gelernt werden . Was dieses mathematische Analogiespiel ermöglicht, sind die Möglichkeiten moderner Computer und die Magie des Deep Learning.

Deep-Learning-Worteinbettungen

Angenommen, wir möchten die Einbettungen für alle Wörter in Harry Potter finden .

Wir erstellen zunächst eine Art mathematische Tresor-Bibliotheks-Kammer. Ein monströses multidimensionales Ungetüm, das groß genug ist, um alle Wörter aufzunehmen, die wir brauchen. Dies ist der Vektorraum .

Das Ziel ist, durch Harry Potter zu gehen Wort für Wort und legen Sie jedes Wort in einen Tresorraum in der Kammer. Ähnliche Wörter wie Kleid und Umhang gehen Sie in den gleichen Tresor. Quidditch und Schnatz befinden sich in angrenzenden Gewölben. Auto und Zentaur sind so weit weg wie Banana und Voldemort .

Die Worteinbettung eines Wortes ist die Adresse des Tresors, in dem es gefunden werden soll. Mathematisch macht dies es zu einem Vektor im Vektorraum .

Sie können sehen, warum kein Mensch jemals diesen Job haben möchte. Es sind viel zu viele Worte und viel zu viel Bewegung erforderlich.

Ein neuronales Netz tut dies jedoch außergewöhnlich gut. Es tut dies durch, nun ja, Magie.

A Deep Neural Net ist eine Art massive Maschine mit Millionen von Zahnrädern und Hebeln. Am Anfang ist alles Chaos und nichts passt zu irgendetwas, obwohl überall herumgewürfelt wird. Dann beginnen langsam einige der Zahnräder zu blockieren. Die Hebel fallen ins Lot – und aus Chaos entsteht Ordnung. Die Maschine setzt sich in Bewegung. Frankenstein lebt!

Die Sprache ist hier absichtlich vage. Ich möchte Sie zu den Anwendungen von Worteinbettungen führen, anstatt wie sie abgeleitet werden. Allerdings wissen wir auf grundlegender Ebene nicht genau, wie neuronale Netze das tun, was sie tun. Daher müssen wir in unseren Experimenten mit der Anzahl der Schichten, den Aktivierungsfunktionen, der Anzahl der Neuronen in jeder Schicht usw. herumspielen, bevor wir zu unserer Aufgabe kommen. Aber das ist ein Thema für einen anderen Tag.

Thermoelektrik

In einem 2019 veröffentlichten Artikel generierte ein Forscherteam des Lawrence Berkeley Lab die Worteinbettungen aller Abstracts in rund 3,3 Millionen Artikeln, die in 1000 Zeitschriften veröffentlicht wurden. Diese Liste ist offensichtlich riesig und deckt fast jedes Thema ab, das in den letzten Jahrzehnten in der Materialwissenschaft veröffentlicht wurde.

Wenn es um einen wissenschaftlichen Text geht, sind auch chemische Formeln und Symbole „Wörter“. Daher gibt es einen Wortvektor für LiCoO 2 – das ist eine übliche Batteriekathode. Sie können dann Fragen stellen wie:Was sind die Wortvektoren, die LiCoO2 am nächsten kommen?

Wir wissen, dass LiCoO2 ein Vektor im Vektorraum ist. Wir müssen also nur Vektoren in der Nähe finden.

Die Antwort lautet LiMn 2 O 4 , LiNi 0,5 Mn 1,5 O 4 , LiNi 0,8 Co 0,2 O 2 , LiNi 0,8 Co 0,15 Al 0,05 O 2 und LiNiO 2 – die alle auch Lithium-Ionen-Kathodenmaterialien sind.

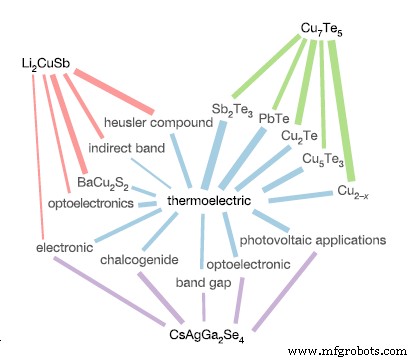

Der Beziehungsweg ausgewählter chemischer Verbindungen zum Wort „thermoelektrisch“. Li2CuSb ist nicht direkt mit „Thermoelektrik“ verwandt, aber es sind fast andere Wörter, die Indikatoren für diese Eigenschaft sind, wie „indirektes Band“ und „Optoelektronik“. Von [2]

Sehen Sie, was wir hier gemacht haben?

Wir haben wirklich versucht, andere Materialien zu erforschen, die unserer Lieblingskathode ähneln. Anstatt tausend Artikel zu lesen, Notizen zu machen und eine Liste von Lithiumverbindungen zu erstellen, löste die Worteinbettung die Aufgabe in wenigen Sekunden.

Das ist die Kraft der Worteinbettung. Durch die Umwandlung semantischer Abfragen in mathematische Vektoroperationen ermöglicht uns dieser Ansatz, große Textdatenbanken besser und effizienter abzufragen und zu verstehen.

Als weiteres Beispiel untersuchten die Forscher, wie oft eine chemische Verbindung in der Nähe des Vektors für „Thermoelektrika gefunden wurde ’. (Das sind Materialien, die elektrische Energie in Wärme umwandeln oder umgekehrt).

Sie können dies durch eine einfache Vektoroperation namens Skalarprodukt tun. Ähnliche Vektoren haben ein Skalarprodukt, das sich einem nähert. Unterschiedliche Vektoren haben ein Punktprodukt nahe null.

Durch Ausführen der gleichen Operation mit chemischen Verbindungen in der Datenbank und dem Wort „thermoelektrisch “ fanden die Autoren alle Chemikalien, die wahrscheinlich thermoelektrisch waren .

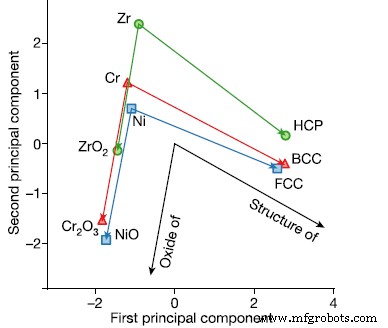

Die Worteinbettungen aus der Abstract-Datenbank können Fragen beantworten wie:Wenn Zr Hexagonal ist, ist Chromium …? (körperzentriert) Von [2]

Die Autoren zeigen weiter, dass ähnliche Beziehungen für mehrere Materialeigenschaften wie Kristallstruktur und Ferroelektrizität nachgewiesen werden können. Darüber hinaus zeigen sie, dass unter Verwendung dieser Technik mehrere der aktuellen Thermoelektrika schon vor Jahren anhand der vorhandenen Literatur hätten vorhergesagt werden können.

Die Analyse ist ein sehr schöner, eleganter und doch täuschend einfacher Ausdruck der Frage „Welche von allen vom Menschen untersuchten Materialien sind wahrscheinlich thermoelektrisch?“ .

Materialdatenbanken sind das Gebot der Stunde

Sie würden annehmen, dass wir diese Liste bereits haben – offensichtlich hat jemand die ganze Arbeit notiert, die wir geleistet haben? Erstellung von Materialhandbüchern und elektronischen Datenbanken?

Die Antwort ist ein überraschendes Nein. Die enorme Menge an Wissen, die wir im Laufe der Jahre angehäuft haben, ist in Texten wie Büchern, Zeitschriften und Papieren eingeschlossen. Es gibt so viele davon, dass es uns unmöglich ist, sie manuell zu durchsuchen.

Genau aus diesem Grund sind Worteinbettungen und die in diesem Dokument vorgestellten Techniken geradezu revolutionär.

Sie versprechen, die Art und Weise, wie wir mit Texten interagieren, zu verändern und unsere Materialdatenbank schnell zu beschleunigen.

Welche Materialien wurden für die Piezoelektrizität untersucht? Gibt es einen Supraleiter, den wir in der Literatur übersehen haben? Gibt es ein neues Medikament, das Alzheimer heilen kann?

Fragen Sie nach den Worteinbettungen. Sie würden es wissen.

Industrietechnik

- Wie man beim Lehren neuer Software nicht scheitert

- Python New Line:So drucken Sie OHNE Newline in Python

- Wie sich ein neuer Leasing-Buchungsstandard auf Transport und Logistik auswirkt

- Wie die Lebensmittelindustrie auf ein neues Verbraucherverhalten reagiert

- Wie ein neuseeländischer Fleischexporteur durch die Pandemie navigiert

- Wie man in einer neuen Ära des grenzüberschreitenden E-Commerce erfolgreich ist

- Wie Einzelhändler die Auswirkungen neuer Versandzuschläge abschwächen können

- Wie man bei langsamen Bestellungen neue Kunden anspricht

- Pennsylvania bietet neue Finanzierung an, um Studenten in Philadelphia zu helfen, Möglichkeiten in der Fertigung zu entdecken

- Wie der MTConnect-Standard dazu beiträgt, eine neue Ära in der Fertigung zu gestalten